教程

应用程序开发人员可以使用Fabric教程开始构建自己的解决方案。通过在本地计算机上部署测试网络,开始使用将智能合约部署到渠道教程中提供的步骤来部署和测试智能合约。编写你的第一个应用 介绍了如何使用Fabric SDK提供的API从客户端应用程序调用智能合约。要深入了解Fabric应用程序和智能合约如何协同工作,您可以访问 开发应用 话题

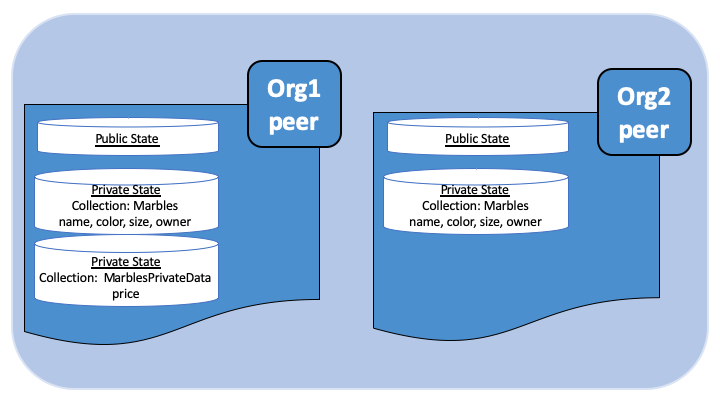

网络管理者可以使用将智能合约部署到通道教程和创建通道 教程系列,学习管理运行网络的重要方面。网络管理者和应用程序开发人员都可以使用关于私有数据和CouchDB的教程来探索重要的Fabric特性。当您准备好在生产环境中部署Hyperledger fabric时,请参阅部署一个生产网络.

有两个更新通道的教程: 更新通道配置 和 Updating the capability level of a channel , Upgrading your components 展示了如何升级组件,如 peer节点、排序节点、SDK等。

使用Fabric的测试网络⭐

下载Hyperledger Fabric Docker镜像和示例后,您将可以使用以fabric-samples代码库中提供的脚本来部署测试网络。 您可以通过在本地计算机上运行节点来使用测试网络以了解Fabric。更有经验的开发人员可以使用 网络测试其智能合约和应用程序。该网络工具仅用作教育与测试目的。它不应该用作部署产品网络的模板。 该测试网络在Fabric v2.0中被引入作为first-network示例的长期替代。该示例网络使用Docker Compose部署了一个Fabric网络。 因为这些节点是隔离在Docker Compose网络中的,所以测试网络不配置为连接到其他正在运行的fabric节点。

注意: 这些指导已基于最新的稳定版Docker镜像和提供的tar文件中的预编译的安装软件进行验证。 如果您使用当前的master分支的镜像或工具运行这些命令,则可能会遇到错误。

开始之前

在运行测试网络之前,您需要克隆fabric-samples代码库并下载Fabric镜像。确保已安装 的 准备阶段 和 安装示例、二进制和 Docker 镜像.

启动测试网络

您可以在fabric-samples代码库的test-network目录中找到启动网络的脚本。 使用以下命令导航至测试网络目录:

1

|

cd fabric-samples/test-network

|

在此目录中,您可以找到带注释的脚本network.sh,该脚本在本地计算机上使用Docker镜像建立Fabric网络。 你可以运行./network.sh -h以打印脚本帮助文本:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

Usage:

network.sh <Mode> [Flags]

Modes:

up - bring up fabric orderer and peer nodes. No channel is created

up createChannel - bring up fabric network with one channel

createChannel - create and join a channel after the network is created

deployCC - deploy the asset transfer basic chaincode on the channel or specify

down - clear the network with docker-compose down

restart - restart the network

Flags:

-ca <use CAs> - create Certificate Authorities to generate the crypto material

-c <channel name> - channel name to use (defaults to "mychannel")

-s <dbtype> - the database backend to use: goleveldb (default) or couchdb

-r <max retry> - CLI times out after certain number of attempts (defaults to 5)

-d <delay> - delay duration in seconds (defaults to 3)

-ccn <name> - the short name of the chaincode to deploy: basic (default),ledger, private, secured

-ccl <language> - the programming language of the chaincode to deploy: go (default), java, javascript, typescript

-ccv <version> - chaincode version. 1.0 (default)

-ccs <sequence> - chaincode definition sequence. Must be an integer, 1 (default), 2, 3, etc

-ccp <path> - Optional, chaincode path. Path to the chaincode. When provided the -ccn will be used as the deployed name and not the short name of the known chaincodes.

-cci <fcn name> - Optional, chaincode init required function to invoke. When provided this function will be invoked after deployment of the chaincode and will define the chaincode as initialization required.

-i <imagetag> - the tag to be used to launch the network (defaults to "latest")

-cai <ca_imagetag> - the image tag to be used for CA (defaults to "latest")

-verbose - verbose mode

-h - print this message

Possible Mode and flag combinations

up -ca -c -r -d -s -i -verbose

up createChannel -ca -c -r -d -s -i -verbose

createChannel -c -r -d -verbose

deployCC -ccn -ccl -ccv -ccs -ccp -cci -r -d -verbose

Taking all defaults:

network.sh up

Examples:

network.sh up createChannel -ca -c mychannel -s couchdb -i 2.0.0

network.sh createChannel -c channelName

network.sh deployCC -ccn basic -ccl javascript

|

在test-network目录中,运行以下命令删除先前运行的所有容器或工程:

然后,您可以通过执行以下命令来启动网络。如果您尝试从另一个目录运行脚本,则会遇到问题:

此命令创建一个由两个peer节点和一个orderer节点组成的Fabric网络。 运行./network.sh up时没有创建任何channel, 虽然我们将在后面的步骤实现。 如果命令执行成功,您将看到已创建的节点的日志:

1

2

3

4

5

6

7

8

9

10

11

|

Creating network "net_test" with the default driver

Creating volume "net_orderer.example.com" with default driver

Creating volume "net_peer0.org1.example.com" with default driver

Creating volume "net_peer0.org2.example.com" with default driver

Creating orderer.example.com ... done

Creating peer0.org2.example.com ... done

Creating peer0.org1.example.com ... done

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

8d0c74b9d6af hyperledger/fabric-orderer:latest "orderer" 4 seconds ago Up Less than a second 0.0.0.0:7050->7050/tcp orderer.example.com

ea1cf82b5b99 hyperledger/fabric-peer:latest "peer node start" 4 seconds ago Up Less than a second 0.0.0.0:7051->7051/tcp peer0.org1.example.com

cd8d9b23cb56 hyperledger/fabric-peer:latest "peer node start" 4 seconds ago Up 1 second 7051/tcp, 0.0.0.0:9051->9051/tcp peer0.org2.example.com

|

如果未得到此结果,请跳至故障排除 寻求可能出现问题的帮助。 默认情况下,网络使用 cryptogen工具来建立网络。 但是,您也可以 通过证书颁发机构建立网络。

测试网络的组成部分

部署测试网络后,您可能需要一些时间来检查其网络组件。 运行以下命令以列出所有正在您的计算机上运行的Docker容器。 您应该看到由network.sh脚本创建的三个节点:

与Fabric网络互动的每个节点和用户都必须属于一个网络成员的组织。 Fabric网络成员的所有组织通常称为联盟(consortium)。 测试网络有两个联盟成员,Org1和Org2。 该网络还包括一个维护网络排序服务的排序组织。

Peer 节点 是任何Fabric网络的基本组件。 peer节点存储区块链账本并在进行交易之前对其进行验证。 peer运行智能合约用于管理区块链账本的上的业务逻辑。

网络中的每个peer都必须属于该联盟的成员。 在测试网络里,每个组织各自运营一个peer节点, peer0.org1.example.com和peer0.org2.example.com.

每个Fabric网络还包括一个排序服务。 虽然peer节点验证交易并将交易块添加到区块链账本,但是他们不决定交易顺序或产生区块。 在分布式网络上,peer可能运行得很远彼此之间没有什么共同点,并且对何时创建事务没有共同的看法。 在交易顺序上达成共识是一个代价高昂的过程,为peer增加开销。

排序服务允许peer节点专注于验证交易并将它们提交到账本。 排序节点从客户那里收到认可的交易后,他们就交易顺序达成共识,然后添加区块。 这些区块之后被分配给添加这些区块到账本的peer节点。 排序节点还可以操作定义Fabric网络的功能的系统通道,例如如何制作块以及节点可以使用的Fabric版本。 系统通道定义了哪个组织是该联盟的成员。

该示例网络使用一个单节点Raft排序服务,该服务由排序组织运行。 您可以看到在您机器上正在运行的排序节点orderer.example.com。 虽然测试网络仅使用单节点排序服务,但是一个真实的网络将有多个排序节点,由一个或多个多个排序组织操作。 不同的排序节点将使用Raft共识算法达成跨交易顺序的共识网络。

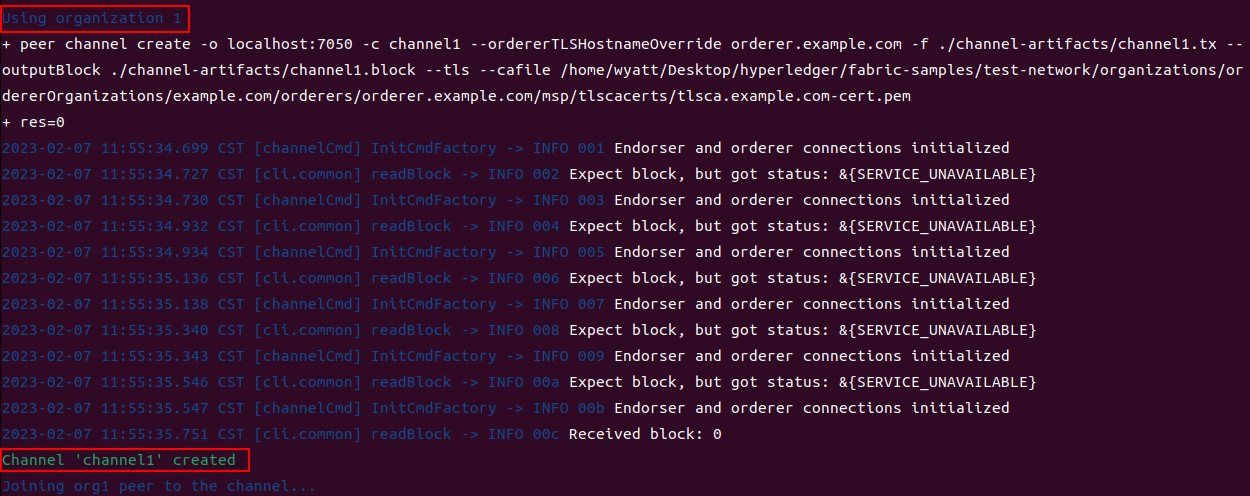

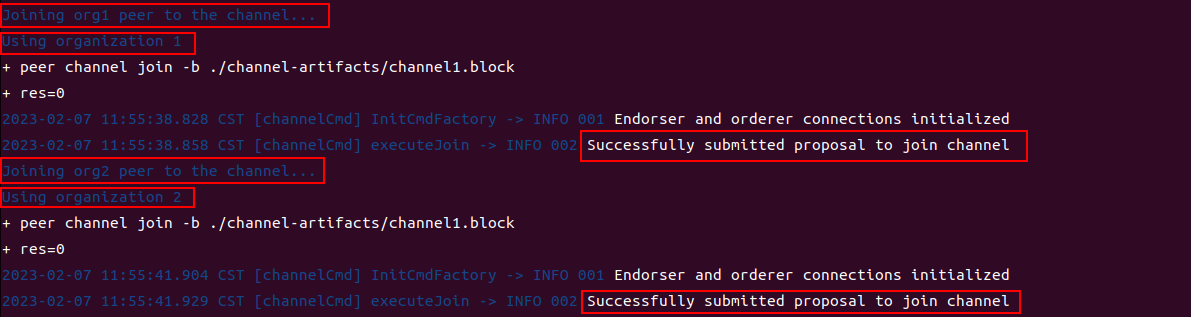

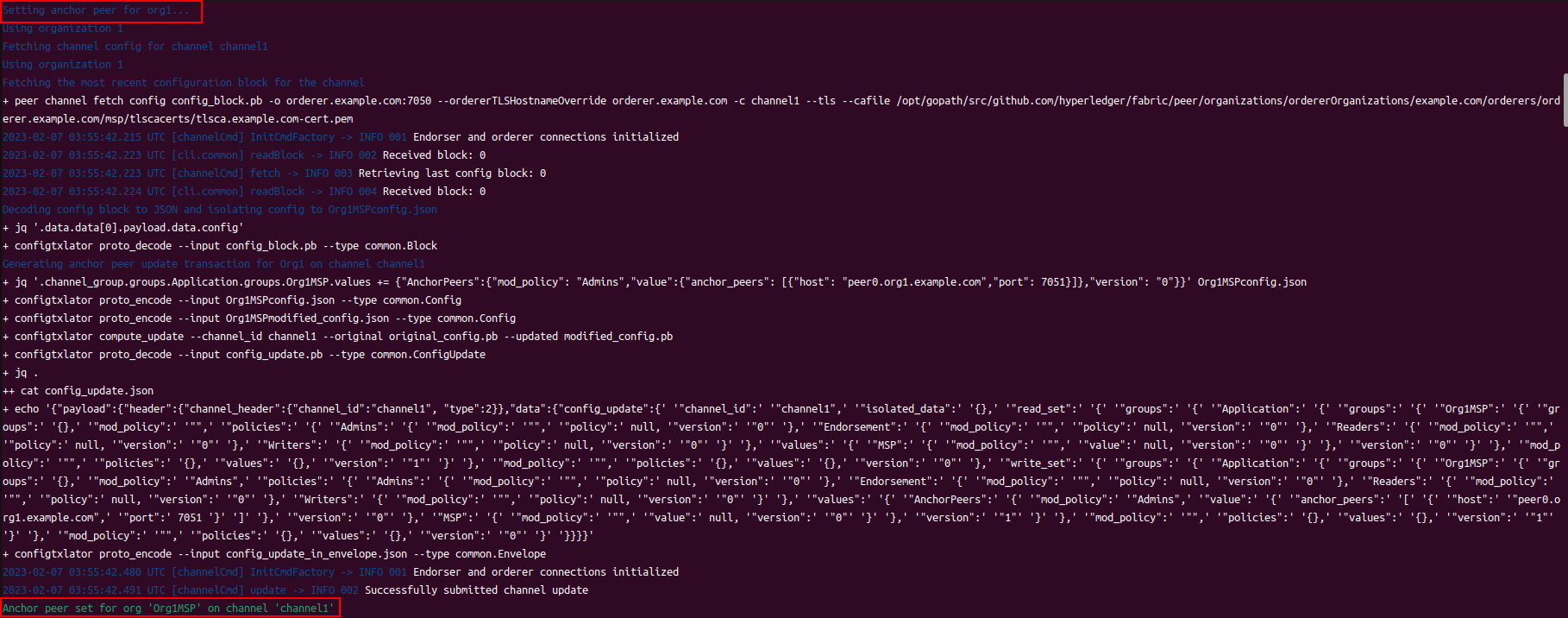

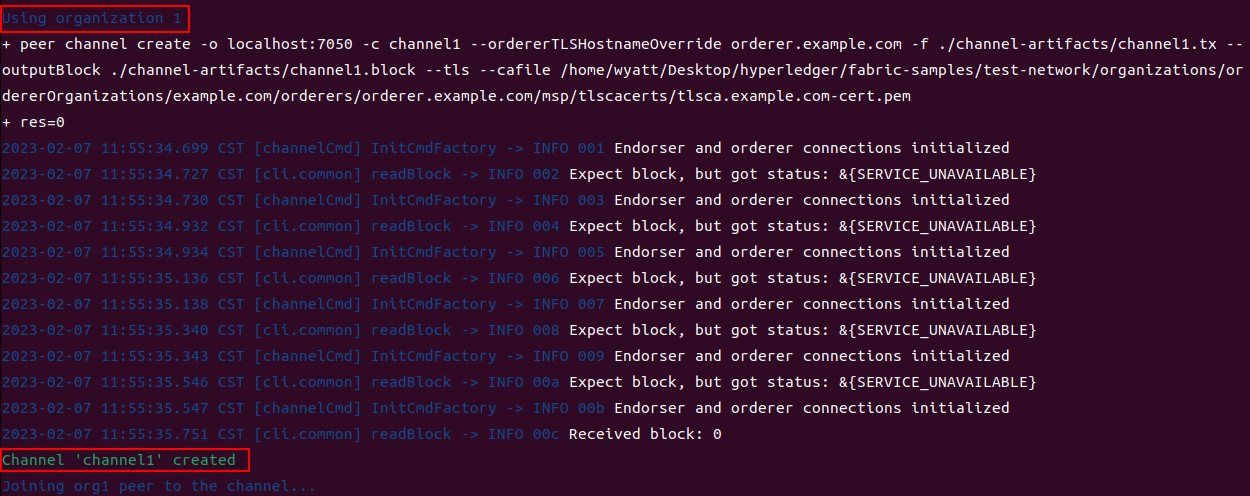

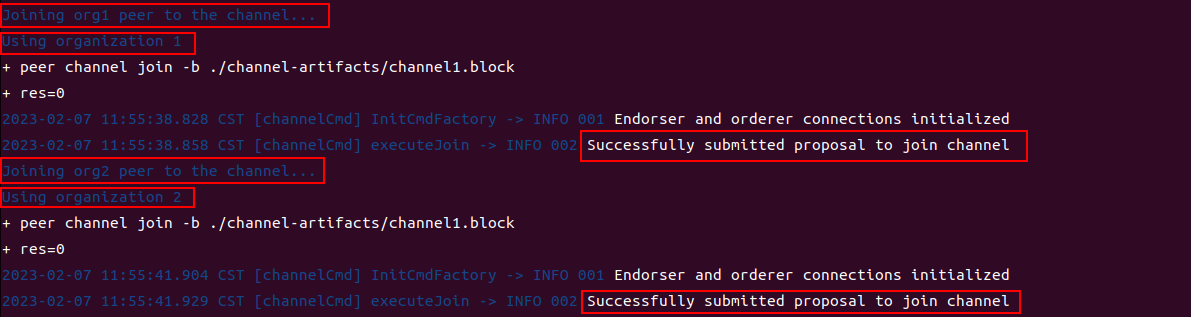

创建一个通道

现在我们的机器上正在运行peer节点和排序节点, 我们可以使用脚本创建用于在Org1和Org2之间进行交易的Fabric通道。 通道是特定网络成员之间的专用通信层。通道只能由被邀请加入通道的组织使用,并且对网络的其他成员不可见。 每个通道都有一个单独的区块链账本。被邀请的组织“加入”他们的peer节点来存储其通道账本并验证交易。

您可以使用network.sh脚本在Org1和Org2之间创建通道并加入他们的peer节点。 运行以下命令以创建一个默认名称为“ mychannel”的通道:

1

|

./network.sh createChannel

|

如果命令成功执行,您将看到以下消息打印在您的日志:

1

|

========= Channel successfully joined ===========

|

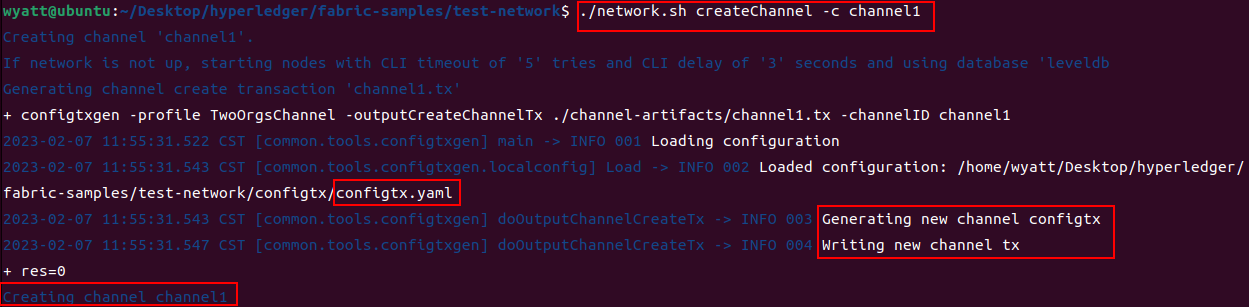

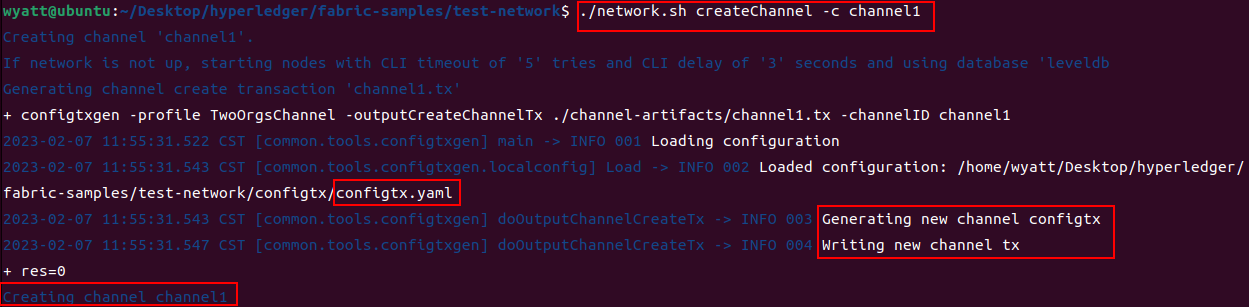

您也可以使用channel标志创建具有自定义名称的通道。 作为一个例子,以下命令将创建一个名为channel1的通道:

1

|

./network.sh createChannel -c channel1

|

通道标志还允许您创建多个不同名称的多个通道。 创建mychannel或channel1之后,您可以使用下面的命令创建另一个名为channel2的通道:

1

|

./network.sh createChannel -c channel2

|

如果您想一步建立网络并创建频道,则可以使用up和createChannel模式一起:

1

|

./network.sh up createChannel

|

在通道启动一个链码

创建通道后,您可以开始使用智能合约与通道账本交互。 智能合约包含管理区块链账本上资产的业务逻辑。 由成员运行的应用程序网络可以在账本上调用智能合约创建,更改和转让这些资产。 应用程序还通过智能合约查询,以在分类帐上读取数据。

为确保交易有效,使用智能合约创建的交易通常需要由多个组织签名才能提交到通道账本。 多个签名是Fabric信任模型不可或缺的一部分。 一项交易需要多次背书,以防止一个通道上的单一组织使用通道不同意的业务逻辑篡改其对等节点的分类账本。 要签署交易,每个组织都需要调用并在其对等节点上执行智能合约,然后签署交易的输出。 如果输出是一致的并且已经有足够的组织签名,则可以将交易提交到账本。 该政策被称为背书政策,指定需要执行智能交易的通道上的已设置组织合同,针对每个链码设置为链码定义的一部分。

在Fabric中,智能合约作为链码以软件包的形式部署在网络上。 链码安装在组织的peer节点上,然后部署到某个通道,然后可以在该通道中用于认可交易和区块链账本交互。 在将链码部署到通道前,该频道的成员需要就链码定义达成共识,建立链码治理。 何时达到要求数量的组织同意后,链码定义可以提交给通道,并且可以使用链码了。

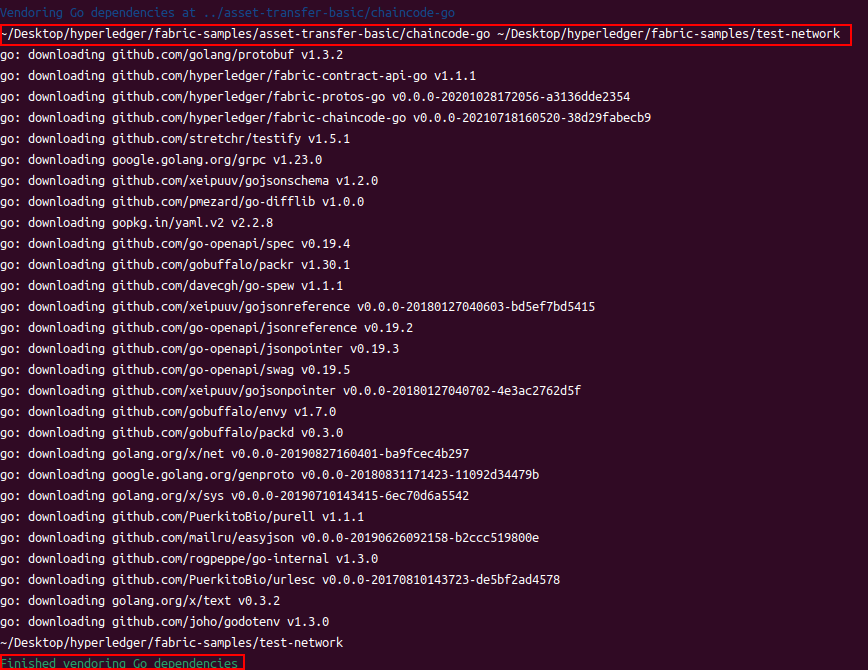

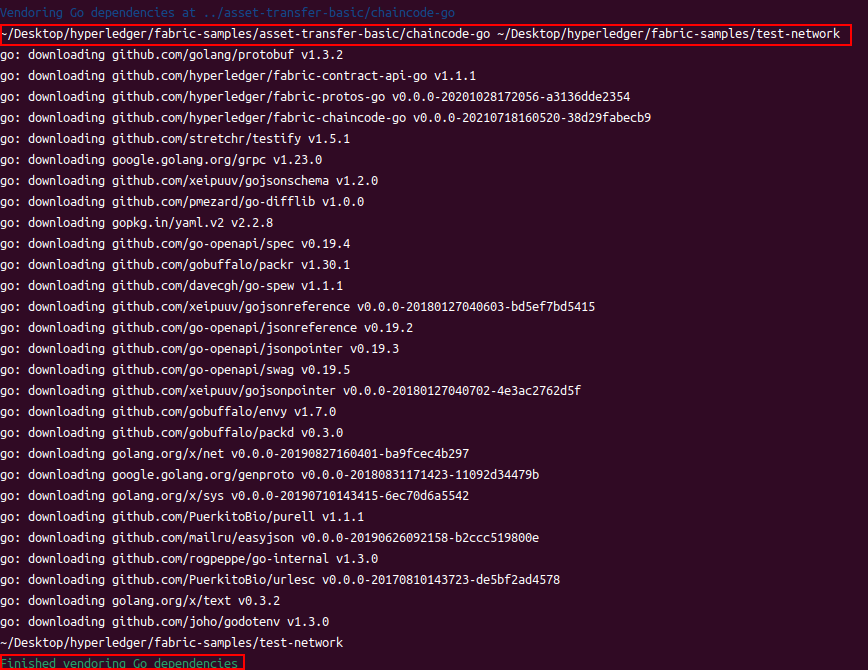

使用network.sh创建通道后,您可以使用以下命令在通道上启动链码:

1

|

./network.sh deployCC -ccn basic -ccp ../asset-transfer-basic/chaincode-go -ccl go

|

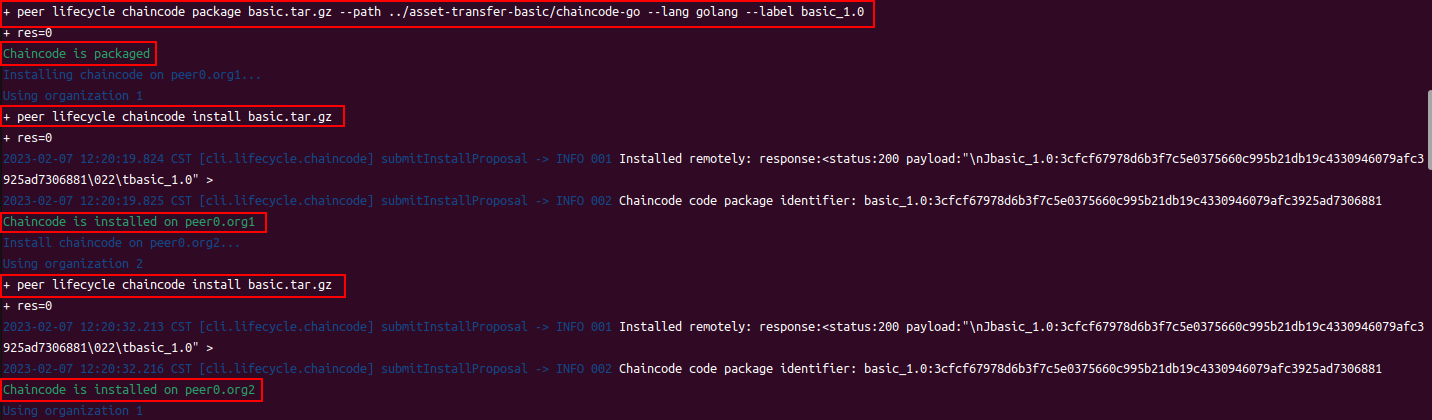

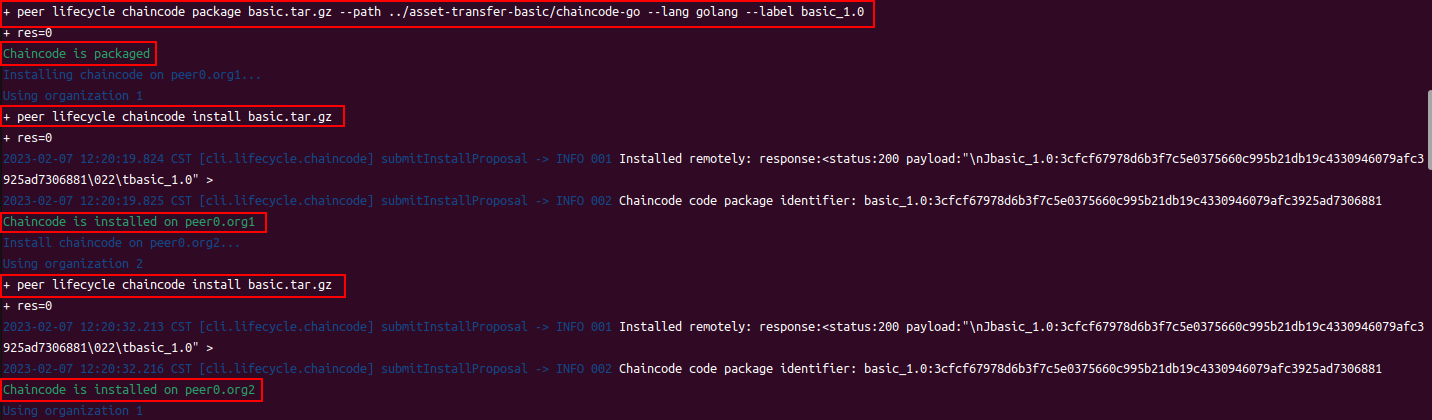

deployCC子命令将在peer0.org1.example.com和peer0.org2.example.com上安装 asset-transfer (basic) 链码。 然后在使用通道标志(或mychannel如果未指定通道)的通道上部署指定的通道的链码。 如果您第一次部署一套链码,脚本将安装链码的依赖项。默认情况下,脚本安装Go版本的 asset-transfer (basic) 链码。 但是您可以使用语言便签 -l,用于安装 Java 或 javascript 版本的链码。 您可以在 fabric-samples 目录的 asset-transfer-basic 文件夹中找到 asset-transfer (basic) 链码。 此目录包含作为案例和用来突显 Fabric 特征的样本链码。

BUG:无法下载mod

解决:更换go代理

1

2

|

go env -w GOPROXY=https://goproxy.cn

go env -w GO111MODULE=on

|

与网络交互

在您启用测试网络后,可以使用peer CLI与您的网络进行交互。 peer CLI允许您调用已部署的智能合约,更新通道,或安装和部署新的智能合约。

确保您正在从test-network目录进行操作。 如果你按照说明安装示例,二进制文件和Docker映像, 您可以在fabric-samples代码库的bin文件夹中找到peer二进制文件。 使用以下命令将这些二进制文件添加到您的CLI路径:

1

|

export PATH=${PWD}/../bin:$PATH

|

您还需要将fabric-samples代码库中的FABRIC_CFG_PATH设置为指向其中的core.yaml文件:

1

|

export FABRIC_CFG_PATH=$PWD/../config/

|

现在,您可以设置环境变量,以允许您作为Org1操作peer CLI:

1

2

3

4

5

6

7

|

# Environment variables for Org1

export CORE_PEER_TLS_ENABLED=true

export CORE_PEER_LOCALMSPID="Org1MSP"

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org1.example.com/users/Admin@org1.example.com/msp

export CORE_PEER_ADDRESS=localhost:7051

|

CORE_PEER_TLS_ROOTCERT_FILE和CORE_PEER_MSPCONFIGPATH环境变量指向Org1的organizations文件夹中的的加密材料。

如果您使用 ./network.sh deployCC -ccl go 安装和启动 asset-transfer (basic) 链码,您可以调用链码(Go)的 InitLedger 方法来赋予一些账本上的初始资产(如果使用 typescript 或者 javascript,例如 ./network.sh deployCC -l javascript,你会调用相关链码的 initLedger 功能)。 运行以下命令用一些资产来初始化账本:

1

|

peer chaincode invoke -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem -C mychannel -n basic --peerAddresses localhost:7051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt --peerAddresses localhost:9051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt -c '{"function":"InitLedger","Args":[]}'

|

如果命令成功,您将观察到类似以下的输出:

1

|

-> INFO 001 Chaincode invoke successful. result: status:200

|

现在你可以用你的 CLI 工具来查询账本。运行以下指令来获取添加到通道账本的资产列表:

1

|

peer chaincode query -C mychannel -n basic -c '{"Args":["GetAllAssets"]}'

|

如果成功,您将看到以下输出:

1

2

3

4

5

6

7

8

|

[

{"ID": "asset1", "color": "blue", "size": 5, "owner": "Tomoko", "appraisedValue": 300},

{"ID": "asset2", "color": "red", "size": 5, "owner": "Brad", "appraisedValue": 400},

{"ID": "asset3", "color": "green", "size": 10, "owner": "Jin Soo", "appraisedValue": 500},

{"ID": "asset4", "color": "yellow", "size": 10, "owner": "Max", "appraisedValue": 600},

{"ID": "asset5", "color": "black", "size": 15, "owner": "Adriana", "appraisedValue": 700},

{"ID": "asset6", "color": "white", "size": 15, "owner": "Michel", "appraisedValue": 800}

]

|

当一个网络成员希望在账本上转一些或者改变一些资产,链码会被调用。使用以下的指令来通过调用 asset-transfer (basic) 链码改变账本上的资产所有者:

1

|

peer chaincode invoke -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem -C mychannel -n basic --peerAddresses localhost:7051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt --peerAddresses localhost:9051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt -c '{"function":"TransferAsset","Args":["asset6","Christopher"]}'

|

如果命令成功,您应该看到以下响应:

1

|

2019-12-04 17:38:21.048 EST [chaincodeCmd] chaincodeInvokeOrQuery -> INFO 001 Chaincode invoke successful. result: status:200

|

因为 asset-transfer (basic) 链码的背书策略需要交易同时被 Org1 和 Org2 签名,链码调用指令需要使用 --peerAddresses 标签来指向 peer0.org1.example.com 和 peer0.org2.example.com。因为网络的 TLS 被开启,指令也需要用 --tlsRootCertFiles 标签指向每个 peer 节点的 TLS 证书。

调用链码之后,我们可以使用另一个查询来查看调用如何改变了区块链账本的资产。因为我们已经查询了 Org1 的 peer,我们可以把这个查询链码的机会通过 Org2 的 peer 来运行。设置以下的环境变量来操作 Org2:

1

2

3

4

5

6

7

|

# Environment variables for Org2

export CORE_PEER_TLS_ENABLED=true

export CORE_PEER_LOCALMSPID="Org2MSP"

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org2.example.com/users/Admin@org2.example.com/msp

export CORE_PEER_ADDRESS=localhost:9051

|

你可以查询运行在 peer0.org2.example.com asset-transfer (basic) 链码:

1

|

peer chaincode query -C mychannel -n basic -c '{"Args":["ReadAsset","asset6"]}'

|

结果显示 "asset6" 转给了 Christopher:

1

|

{"ID":"asset6","color":"white","size":15,"owner":"Christopher","appraisedValue":800}

|

关停网络

使用完测试网络后,您可以使用以下命令关闭网络:

该命令将停止并删除节点和链码容器,删除组织加密材料,并从Docker Registry移除链码镜像。 该命令还删除之前运行的通道项目和docker卷。如果您遇到任何问题,还允许您再次运行./ network.sh up。

下一步

既然您已经使用测试网络在您的本地计算机上部署了Hyperledger Fabric,您可以使用教程来开始开发自己的解决方案:

- 使用将智能合约部署到通道 教程了解如何来将自己的智能合约部署到测试网络。

- 访问编写您的第一个应用程序 教程了解如何从您的客户端程序使用Fabric SDK提供的API调用智能合约。

- 如果您准备将更复杂的智能合约部署到网络,请跟随商业票据教程 探索两个组织使用区块链网络进行商业票据交易的用例。

您可以在教程页上找到Fabric教程的完整列表。

使用认证机构建立网络

Hyperledger Fabric使用公钥基础设施(PKI)来验证所有网络参与者的行为。 每个节点,网络管理员和用户提交的交易需要具有公共证书和私钥以验证其身份。 这些身份必须具有有效的信任根源,该证书是由作为网络中的成员组织颁发的。 network.sh脚本在创建对等和排序节点之前创建所有部署和操作网络所有需要的加密材料。

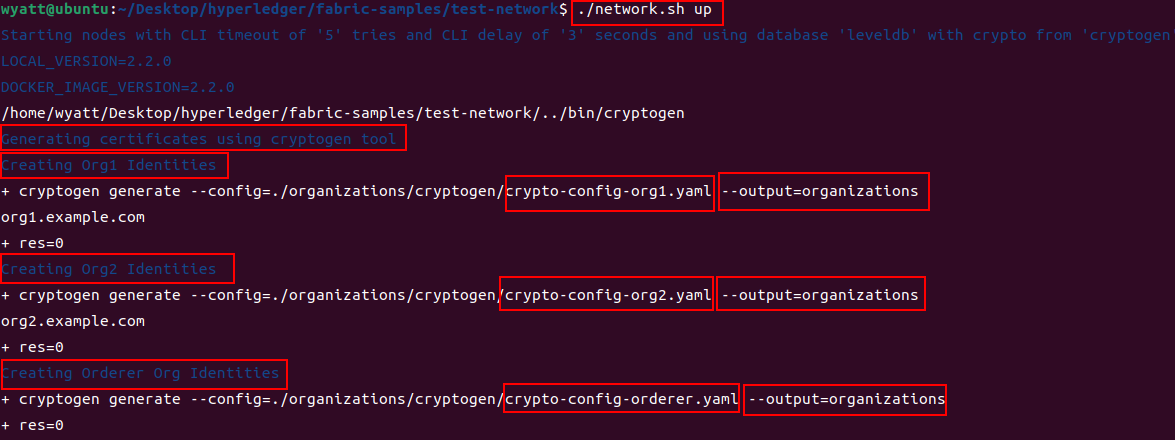

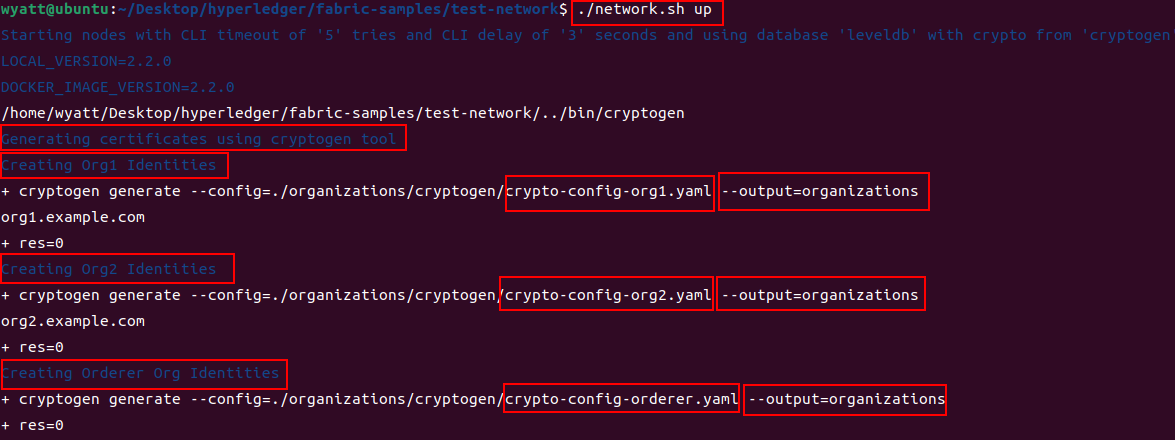

默认情况下,脚本使用cryptogen工具创建证书和密钥。 该工具用于开发和测试,并且可以快速为具有有效根信任的Fabric组织创建所需的加密材料。 当您运行./network.sh up时,您会看到cryptogen工具正在创建Org1,Org2和Orderer Org的证书和密钥。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

creating Org1, Org2, and ordering service organization with crypto from 'cryptogen'

/Usr/fabric-samples/test-network/../bin/cryptogen

##########################################################

##### Generate certificates using cryptogen tool #########

##########################################################

##########################################################

############ Create Org1 Identities ######################

##########################################################

+ cryptogen generate --config=./organizations/cryptogen/crypto-config-org1.yaml --output=organizations

org1.example.com

+ res=0

+ set +x

##########################################################

############ Create Org2 Identities ######################

##########################################################

+ cryptogen generate --config=./organizations/cryptogen/crypto-config-org2.yaml --output=organizations

org2.example.com

+ res=0

+ set +x

##########################################################

############ Create Orderer Org Identities ###############

##########################################################

+ cryptogen generate --config=./organizations/cryptogen/crypto-config-orderer.yaml --output=organizations

+ res=0

+ set +x

|

测试网络脚本network.sh还提供了使用证书颁发机构(CA)的网络的启动选项。 在生产网络中,每个组织操作一个CA(或多个中间CA)来创建属于他们的组织身份。 所有由该组织运行的CA创建的身份享有相同的组织信任根源。 虽然花费的时间比使用cryptogen多,但是使用CA建立测试网络,提供了在生产环境中部署网络的指导。 部署CA还可以让您注册Fabric SDK的客户端身份,并为您的应用程序创建证书和私钥。

如果您想使用Fabric CA建立网络,请首先运行以下命令关停所有正在运行的网络:

然后,您可以使用CA标志启动网络:

执行命令后,您可以看到脚本启动了三个CA,网络中的每个组织一个。

1

2

3

4

5

6

7

|

##########################################################

##### Generate certificates using Fabric CA's ############

##########################################################

Creating network "net_default" with the default driver

Creating ca_org2 ... done

Creating ca_org1 ... done

Creating ca_orderer ... done

|

值得花一些时间检查/network.sh脚本部署CA之后生成的日志。 测试网络使用Fabric CA客户端为每个组织的CA注册节点和用户身份。 之后这个脚本使用enroll命令为每个身份生成一个MSP文件夹。 MSP文件夹包含每个身份的证书和私钥,以及在CA运营的组织中建立身份的角色和成员身份。 您可以使用以下命令来检查Org1管理员用户的MSP文件夹:

1

|

tree organizations/peerOrganizations/org1.example.com/users/Admin@org1.example.com/

|

该命令将显示MSP文件夹的结构和配置文件:

1

2

3

4

5

6

7

8

9

10

11

12

|

organizations/peerOrganizations/org1.example.com/users/Admin@org1.example.com/

└── msp

├── IssuerPublicKey

├── IssuerRevocationPublicKey

├── cacerts

│ └── localhost-7054-ca-org1.pem

├── config.yaml

├── keystore

│ └── 58e81e6f1ee8930df46841bf88c22a08ae53c1332319854608539ee78ed2fd65_sk

├── signcerts

│ └── cert.pem

└── user

|

您可以在signcerts文件夹中找到管理员用户的证书,然后在keystore文件夹中找到私钥。 要了解有关MSP的更多信息,请参阅成员服务提供者概念主题。

cryptogen和Fabric CA都为每个组织在organizations文件夹中生成加密材料。 您可以在organizations/fabric-ca目录中的registerEnroll.sh脚本中找到用于设置网络的命令。 要了解更多有关如何使用Fabric CA部署Fabric网络的信息,请访问Fabric CA操作指南。 您可以通过访问identity和membership概念主题了解有关Fabric如何使用PKI的更多信息。

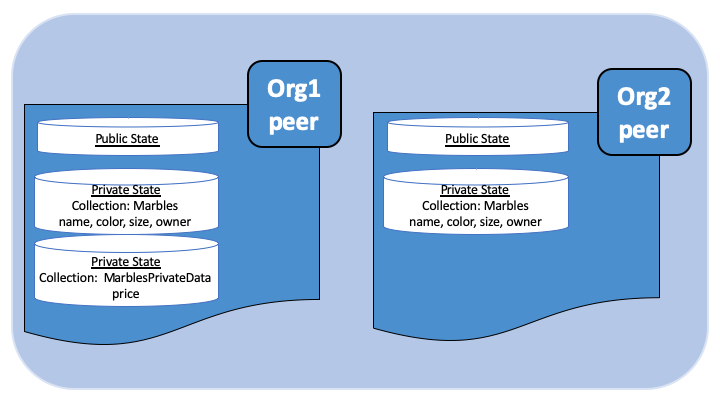

幕后发生了什么⭐⭐⭐

如果您有兴趣了解有关示例网络的更多信息,则可以调查test-network目录中的文件和脚本。 下面的步骤提供了有关在您发出./network.sh up命令时会发生什么情况的导览。

./ network.sh为两个peer组织和排序组织创建证书和密钥。 默认情况下,脚本利用cryptogen工具使用位于organizations/cryptogen文件夹中的配置文件。 如果使用-ca标志创建证书颁发机构,则脚本使用Fabric CA服务器配置文件和位于organizations/fabric-ca文件夹的registerEnroll.sh脚本。 cryptogen和Fabric CA均会在organisations文件夹创建所有三个组织中的加密资料和MSP文件夹。

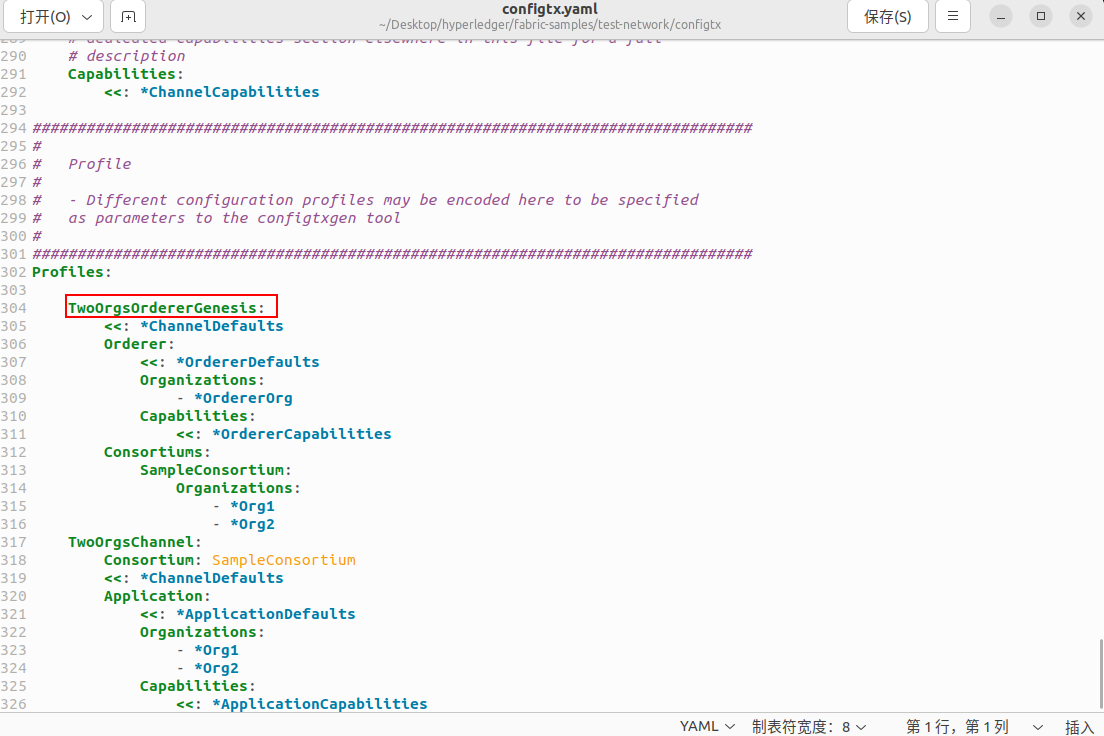

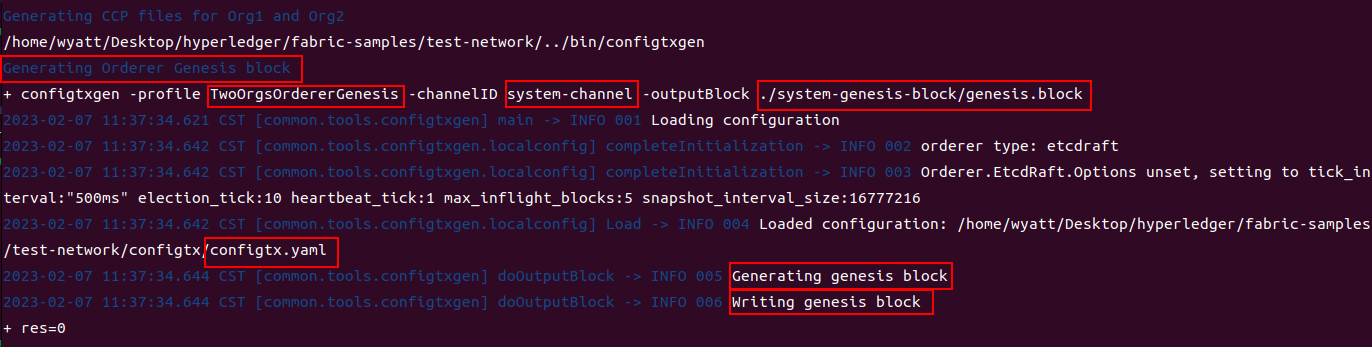

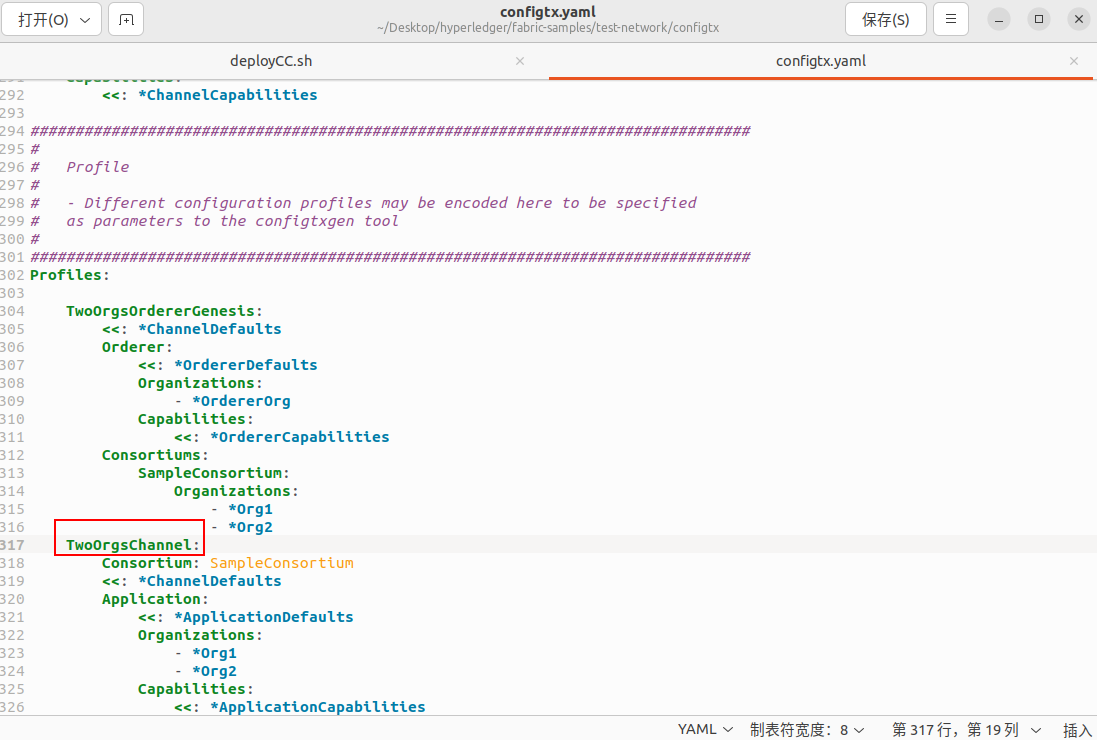

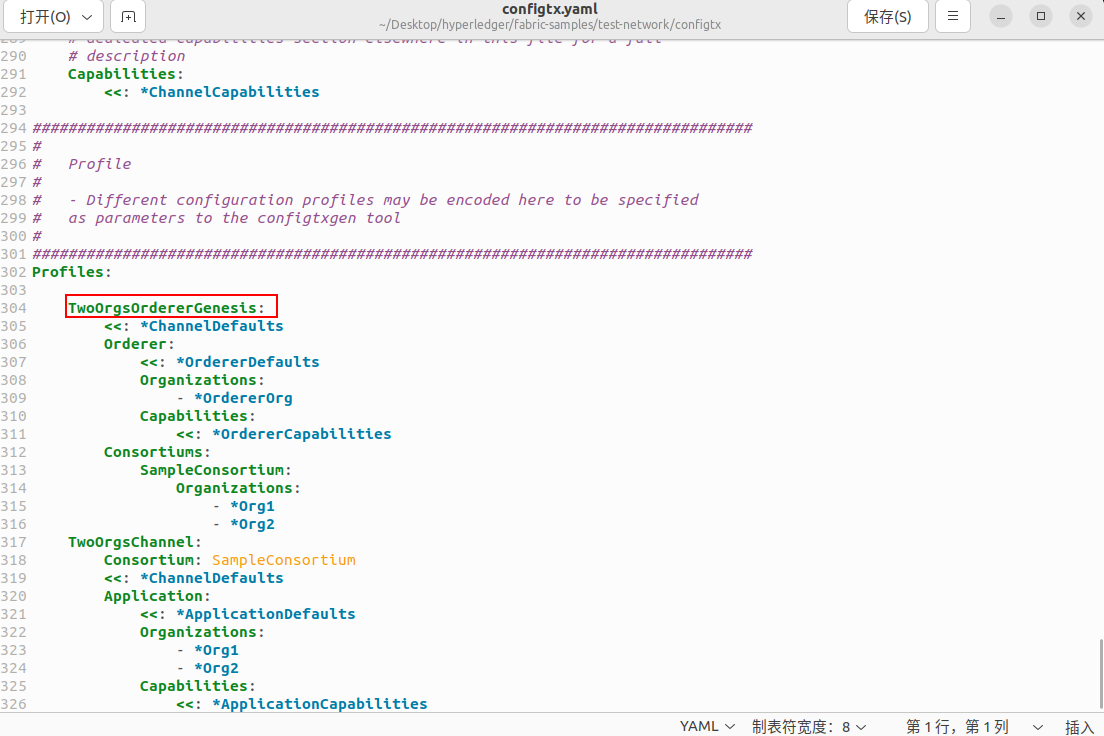

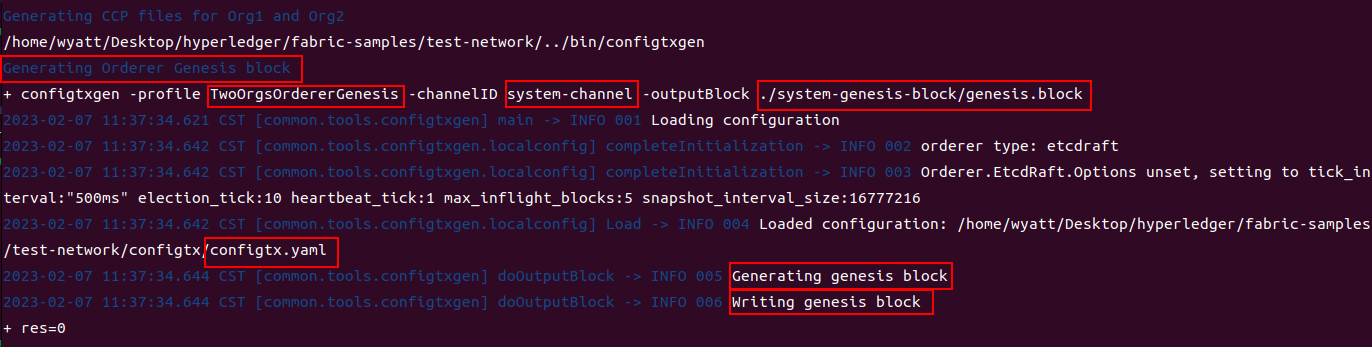

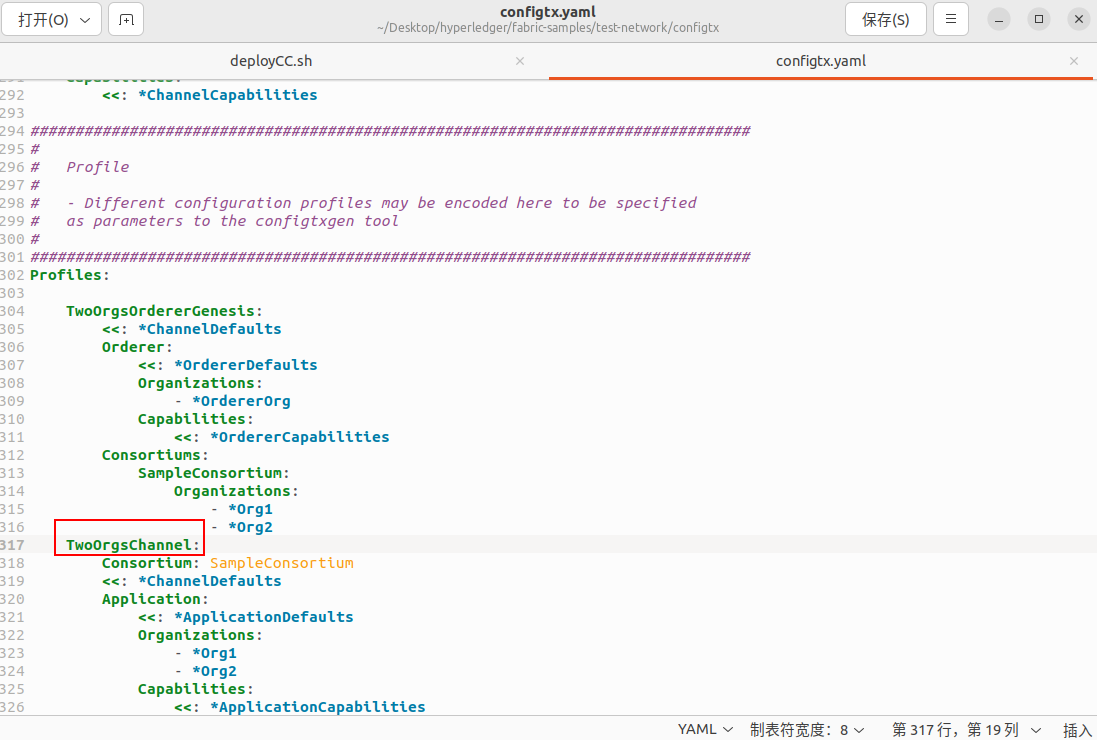

- 该脚本使用

configtxgen工具创建系统通道生成块。 Configtxgen使用了通道配置文件configtx/configtx.yaml中的TwoOrgsOrdererGenesis轮廓(profiles)信息创建创世区块。 区块被存储在system-genesis-block文件夹中。

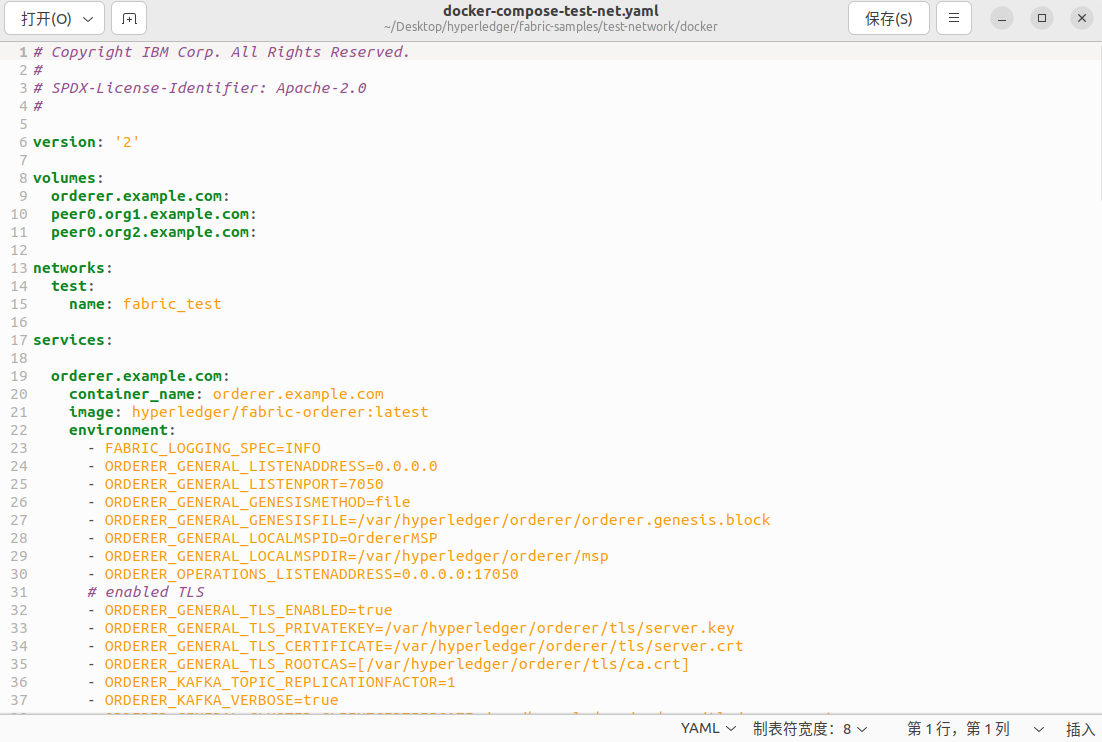

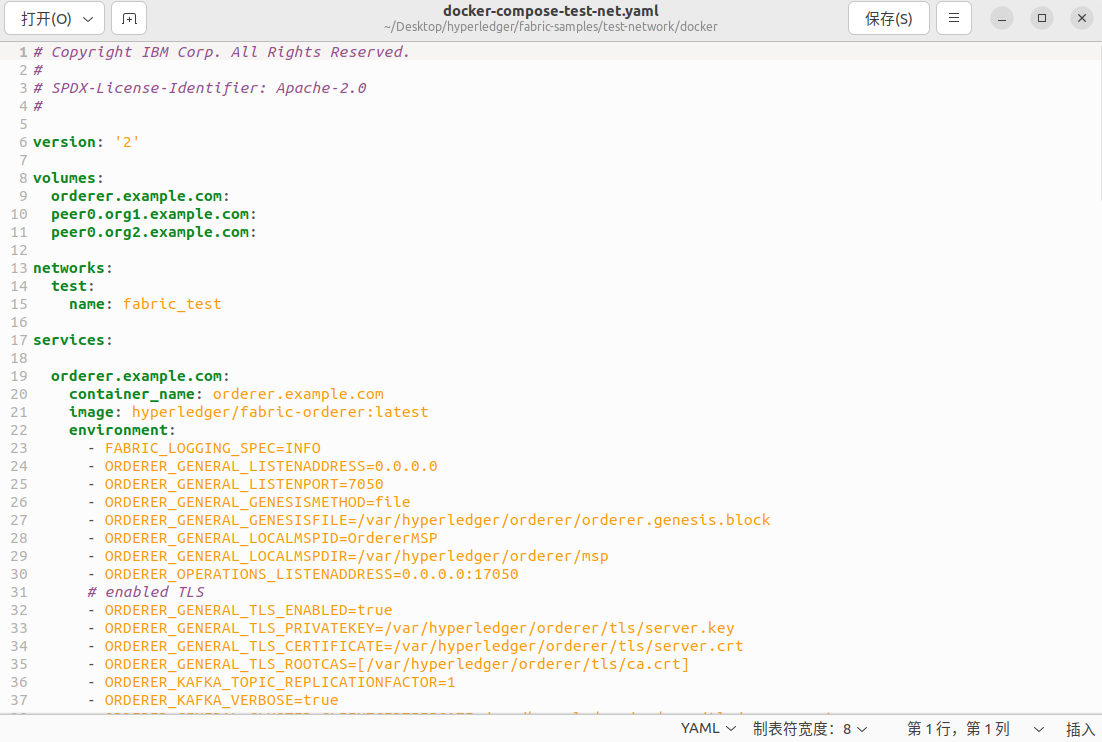

- 一旦组织的加密材料和系统通道的创始块生成后,

network.sh就可以启动网络的节点。 脚本使用docker文件夹中的docker-compose-test-net.yaml文件创建peer节点和排序节点。 docker文件夹还包含 docker-compose-ca.yaml文件启动网络节点三个Fabric CA。 该文件旨在用于Fabric SDK 运行端到端测试。 请参阅Node SDK代码库有关运行这些测试的详细信息。

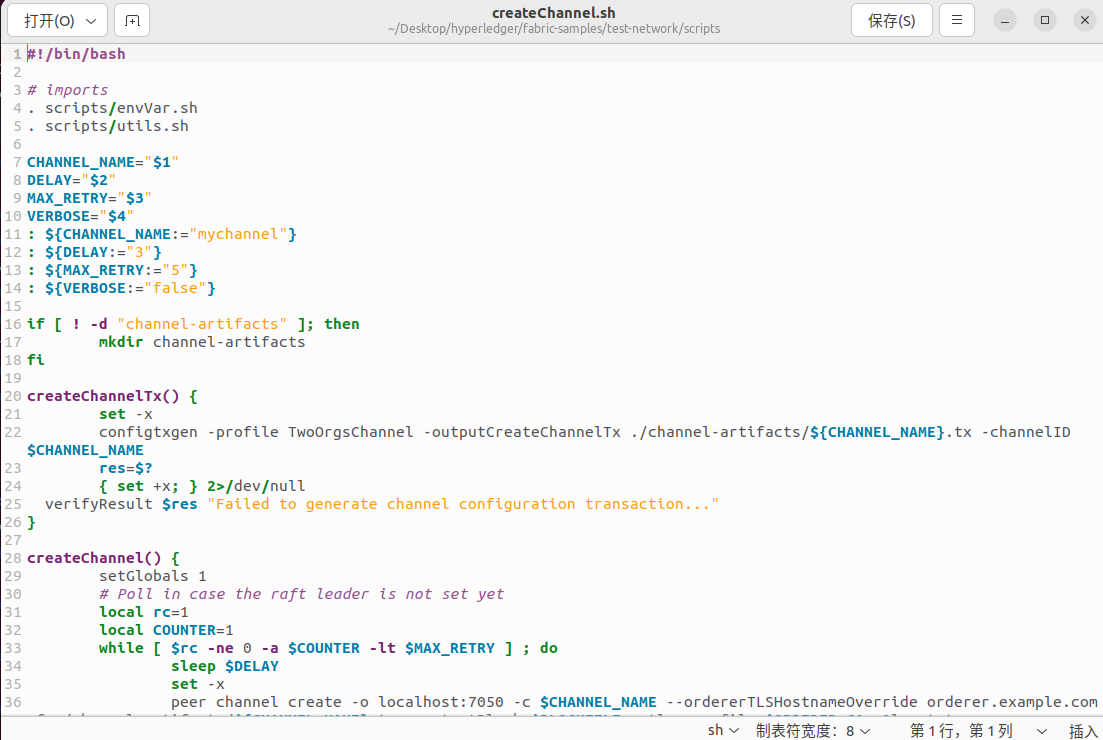

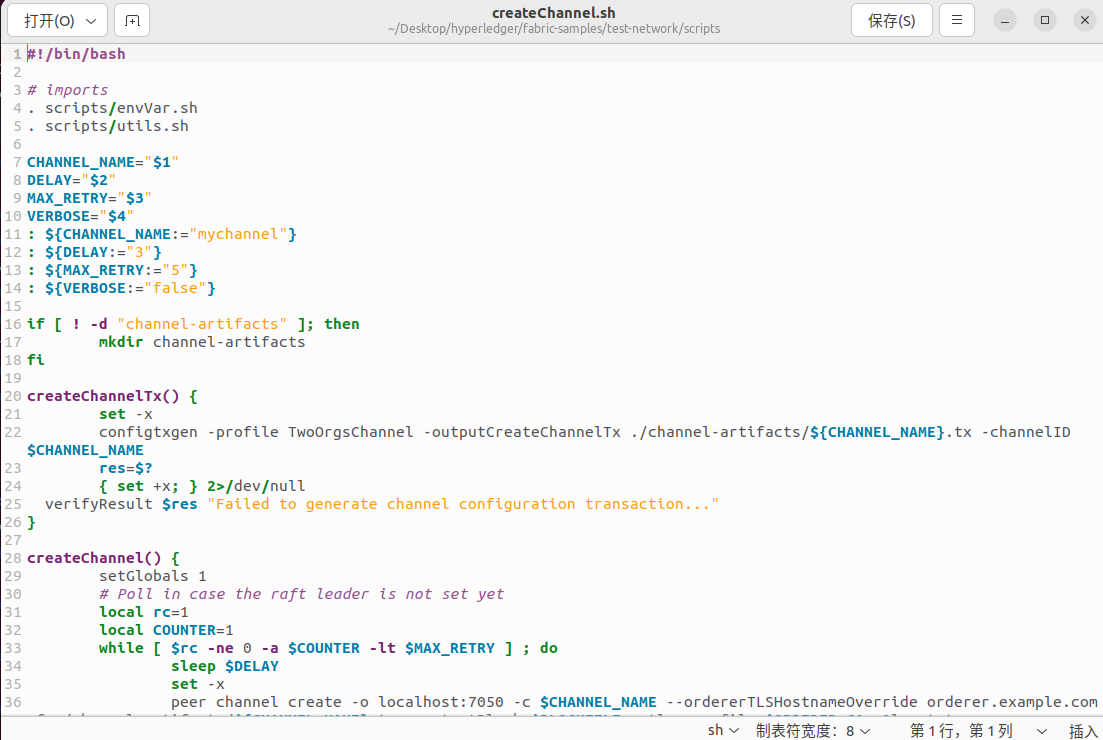

- 如果您使用

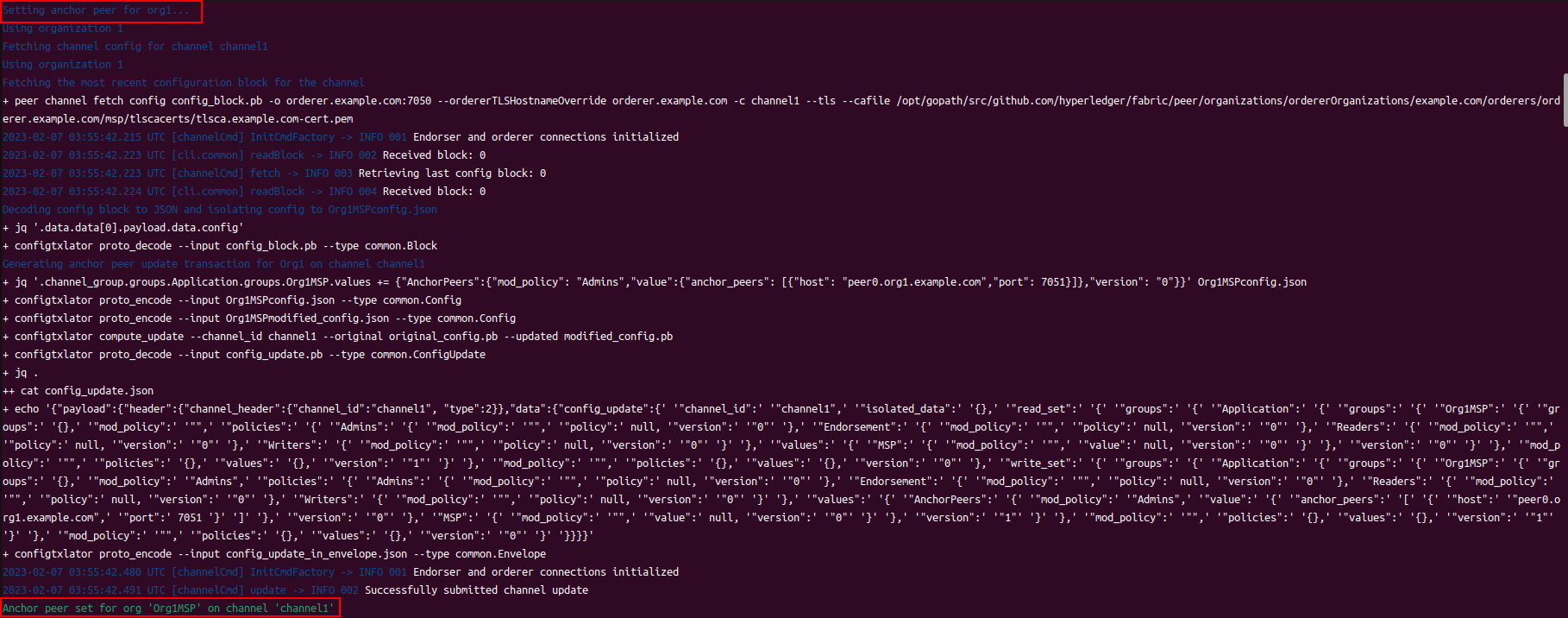

createChannel子命令,则./network.sh使用提供的通道名称, 运行在scripts文件夹中的createChannel.sh脚本来创建通道。 该脚本使用configtx.yaml文件来中的TwoOrgsChannel轮廓创建通道,以及设置两个锚节点。 该脚本使用peer节点cli创建通道,加入peer0.org1.example.com和peer0.org2.example.com 到通道, 以及使两个peer节点都成为锚节点。

- 如果执行

deployCC命令,./network.sh会运行deployCC.sh脚本在两个 peer 节点上安装链码asset-transfer (basic), 然后定义通道上的链码。 一旦将链码定义提交给通道,peer节点cli则可以使用Init初始化链码并调用链码将初始数据放入账本。

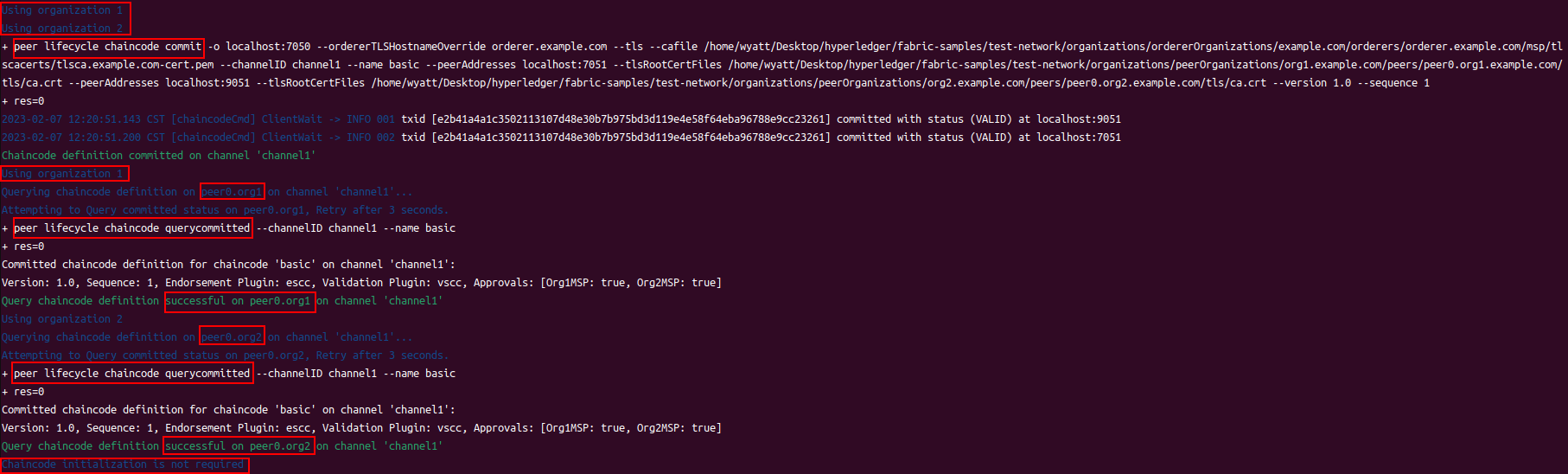

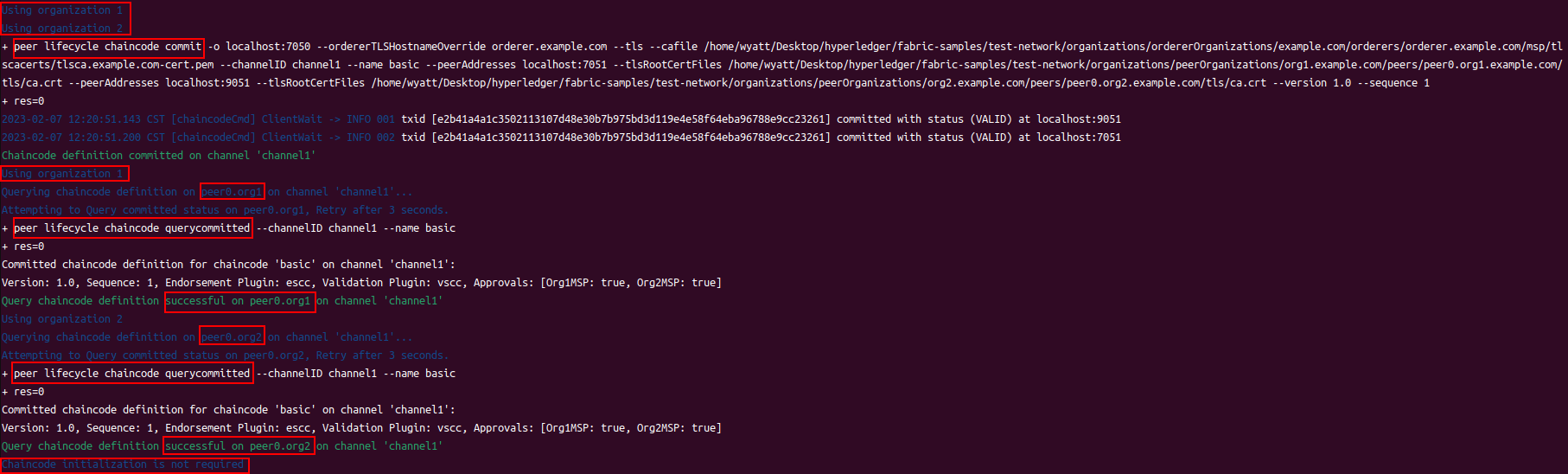

- Commit the chaincode definition on the channel.(提交链码到通道上)

- Query the committed chaincode definitions by channel on a peer. Optional: provide a chaincode name to query a specific definition.(确认操作)

- 输入命令时没要求初始化

故障排除

如果您对本教程有任何疑问,请查看以下内容:

-

您应该始终重新启动网络。 您可以使用以下命令删除先前运行的工件,加密材料,容器,卷和链码镜像:

如果您不删除旧的容器,镜像和卷,将看到报错。

-

如果您看到Docker错误,请先检查您的Docker版本(Prerequisites), 然后尝试重新启动Docker进程。 Docker的问题是经常无法立即识别的。 例如,您可能会看到您的节点无法访问挂载在容器内的加密材料导致的错误。

如果问题仍然存在,则可以删除镜像并从头开始:

1

2

|

docker rm -f $(docker ps -aq)

docker rmi -f $(docker images -q)

|

-

如果您在创建,批准,提交,调用或查询命令时发现错误,确保您已正确更新通道名称和链码名称。 提供的示例命令中有占位符值。

-

如果您看到以下错误:

1

|

Error: Error endorsing chaincode: rpc error: code = 2 desc = Error installing chaincode code mycc:1.0(chaincode /var/hyperledger/production/chaincodes/mycc.1.0 exits)

|

您可能有先前运行中的链码镜像(例如dev-peer1.org2.example.com-asset-transfer-1.0或 dev-peer0.org1.example.com-asset-transfer-1.0)。 删除它们并再次尝试。

1

|

docker rmi -f $(docker images | grep dev-peer[0-9] | awk '{print $3}')

|

-

如果您看到以下错误:

1

2

|

[configtx/tool/localconfig] Load -> CRIT 002 Error reading configuration: Unsupported Config Type ""

panic: Error reading configuration: Unsupported Config Type ""

|

那么您没有正确设置环境变量FABRIC_CFG_PATH。configtxgen工具需要此变量才能找到configtx.yaml。 返回执行export FABRIC_CFG_PATH=$PWD/configtx/configtx.yaml,然后重新创建您的通道工件。

-

如果看到错误消息指出您仍然具有“active endpoints”,请清理您的Docker网络。 这将清除您以前的网络,并以全新环境开始:

您将看到一下信息:

1

2

|

WARNING! This will remove all networks not used by at least one container.

Are you sure you want to continue? [y/N]

|

选 y。

-

如果您看到类似下面的错误:

1

|

/bin/bash: ./scripts/createChannel.sh: /bin/bash^M: bad interpreter: No such file or directory

|

确保有问题的文件(在此示例中为createChannel.sh)为以Unix格式编码。 这很可能是由于未在Git配置中将core.autocrlf设置为false(查看Windows Extras)。 有几种解决方法。 如果你有例如vim编辑器,打开文件:

1

|

vim ./fabric-samples/test-network/scripts/createChannel.sh

|

然后通过执行以下vim命令来更改其格式:

-

如果您的orderer在创建时退出,或者您看到由于无法连接到排序服务创建通道命令失败, 请使用docker logs命令从排序节点读取日志。 你可能会看到以下消息:

1

|

PANI 007 [channel system-channel] config requires unsupported orderer capabilities: Orderer capability V2_0 is required but not supported: Orderer capability V2_0 is required but not supported

|

当您尝试使用Fabric 1.4.x版本docker镜像运行网络时,会发生这种情况。 测试网络需要使用Fabric 2.x版本运行。

如果您仍然发现错误,请在fabric-questions上共享您的日志 Hyperledger Rocket chat或StackOverflow。

将智能合约部署到通道

最终用户通过调用智能合约与区块链分类账进行交互。在 Hyperledger Fabric 中,智能合约部署在称为链代码的包中。想要验证交易或查询分类帐的组织需要在其peer上安装链代码。在加入通道的节点上安装链码后,通道成员可以将链码部署到通道中,并使用链码中的智能合约在通道账本上创建或更新资产。

使用称为 Fabric 链代码生命周期的过程将链代码部署到通道。Fabric 链代码生命周期允许多个组织在链代码用于创建交易之前就如何操作达成一致。例如,虽然背书策略指定哪些组织需要执行链代码来验证交易,但通道成员需要使用 Fabric 链代码生命周期来就链代码背书策略达成一致。有关如何在通道上部署和管理链代码的更深入概述,请参阅Fabric 链代码生命周期。

您可以使用本教程了解如何使用peer lifecycle chaincode 命令将链代码部署到 Fabric 测试网络的通道。了解命令后,您可以使用本教程中的步骤将您自己的链代码部署到测试网络,或将链代码部署到生产网络。在本教程中,您将部署编写您的第一个应用程序教程使用的 Fabcar 链代码。

**注意:**这些说明使用 v2.0 版本中引入的 Fabric 链代码生命周期。如果您想使用以前的生命周期来安装和实例化链码,请访问 fabric文档的 v1.4 版本。

启动网络

我们将从部署 Fabric 测试网络的实例开始。在开始之前,请确保您已经安装了先决条件并安装了示例、二进制文件和 Docker 映像。使用以下命令导航到fabric-samples存储库本地克隆中的测试网络目录:

1

|

cd fabric-samples/test-network

|

为了本教程,我们希望从已知的初始状态开始操作。以下命令将杀死任何活动的或陈旧的 docker 容器并删除以前生成的工件。

然后您可以使用以下命令启动测试网络:

1

|

./network.sh up createChannel

|

该createChannel命令创建一个以mychannel两个通道成员 Org1 和 Org2 命名的通道。该命令还将属于每个组织的peer节点加入通道。如果网络和通道创建成功,您可以在日志中看到以下消息:

1

|

========= Channel successfully joined ===========

|

我们现在可以使用 Peer CLI 通过以下步骤将 Fabcar 链代码部署到通道:

- 第一步:打包智能合约

- 第二步:安装链码包

- 第三步:批准链码定义

- 第四步:将链代码定义提交到通道

设置Logspout(可选)

此步骤不是必需的,但对于排查链代码非常有用。要监控智能合约的日志,管理员可以使用该logspout 工具查看一组 Docker 容器的聚合输出。该工具将来自不同 Docker 容器的输出流收集到一个地方,从而可以轻松地从单个窗口查看正在发生的情况。这可以帮助管理员在安装智能合约时或开发人员在调用智能合约时调试问题。因为一些容器纯粹是为了启动智能合约而创建的,并且只存在很短的时间,所以从您的网络中收集所有日志是有帮助的。

安装和配置 Logspout 的脚本monitordocker.sh已包含在commercial-paperFabric 样本的样本中。我们也将在本教程中使用相同的脚本。Logspout 工具会持续将日志流式传输到您的终端,因此您需要使用一个新的终端窗口。打开一个新终端并导航到test-network目录。

1

|

cd fabric-samples/test-network

|

您可以monitordocker.sh从任何目录运行脚本。为了便于使用,我们会将示例中的monitordocker.sh脚本复制到您的工作目录commercial-paper

1

2

3

|

cp ../commercial-paper/organization/digibank/configuration/cli/monitordocker.sh .

# if you're not sure where it is

find . -name monitordocker.sh

|

然后,您可以通过运行以下命令来启动 Logspout:

1

|

./monitordocker.sh fabric_test

|

您应该看到类似于以下内容的输出:

1

2

3

4

5

6

7

8

9

|

Starting monitoring on all containers on the network net_basic

Unable to find image 'gliderlabs/logspout:latest' locally

latest: Pulling from gliderlabs/logspout

4fe2ade4980c: Pull complete

decca452f519: Pull complete

ad60f6b6c009: Pull complete

Digest: sha256:374e06b17b004bddc5445525796b5f7adb8234d64c5c5d663095fccafb6e4c26

Status: Downloaded newer image for gliderlabs/logspout:latest

1f99d130f15cf01706eda3e1f040496ec885036d485cb6bcc0da4a567ad84361

|

一开始您不会看到任何日志,但是当我们部署我们的链代码时,这会发生变化。使此终端窗口变宽而字体变小可能会有所帮助。

打包智能合约

我们需要先打包链代码,然后才能将它安装到我们的对等节点上。如果您想安装用Go、Java或JavaScript编写的智能合约,则步骤会有所不同。

Go

在我们打包链码之前,我们需要安装链码依赖项。导航到包含 Fabcar 链代码的 Go 版本的文件夹。

1

|

cd fabric-samples/chaincode/fabcar/go

|

该示例使用 Go 模块来安装链代码依赖项。依赖项列在目录中的go.mod文件中fabcar/go。您应该花点时间检查一下这个文件。

1

2

3

4

5

6

|

$ cat go.mod

module github.com/hyperledger/fabric-samples/chaincode/fabcar/go

go 1.13

require github.com/hyperledger/fabric-contract-api-go v1.1.0

|

该go.mod文件将 Fabric 合约 API 导入到智能合约包中。你可以在文本编辑器中打开,看看智能合约开头fabcar.go是如何使用合约API来定义类型的:SmartContract

1

2

3

4

|

// SmartContract provides functions for managing a car

type SmartContract struct {

contractapi.Contract

}

|

然后该SmartContract类型用于为智能合约中定义的函数创建事务上下文,这些函数将数据读取和写入区块链分类账。

1

2

3

4

5

6

7

8

9

10

11

12

13

|

// CreateCar adds a new car to the world state with given details

func (s *SmartContract) CreateCar(ctx contractapi.TransactionContextInterface, carNumber string, make string, model string, colour string, owner string) error {

car := Car{

Make: make,

Model: model,

Colour: colour,

Owner: owner,

}

carAsBytes, _ := json.Marshal(car)

return ctx.GetStub().PutState(carNumber, carAsBytes)

}

|

您可以通过访问API 文档和智能合约处理主题了解有关 Go 合约 API 的更多信息。

fabcar/go要安装智能合约依赖项,请从目录运行以下命令。

1

|

GO111MODULE=on go mod vendor

|

如果命令成功,go 包将安装在一个vendor文件夹中。

现在我们有了我们的依赖,我们可以创建链代码包。导航回test-network文件夹中的工作目录,以便我们可以将链代码与其他网络工件打包在一起。

1

|

cd ../../../test-network

|

您可以使用peerCLI 以所需格式创建链代码包。peer二进制文件位于存储库的bin文件夹中。fabric-samples使用以下命令将这些二进制文件添加到您的 CLI 路径:

1

|

export PATH=${PWD}/../bin:$PATH

|

您还需要设置FABRIC_CFG_PATH指向存储库中的core.yaml文件fabric-samples:

1

|

export FABRIC_CFG_PATH=$PWD/../config/

|

要确认您能够使用peerCLI,请检查二进制文件的版本。二进制文件需要是版本2.0.0或更高版本才能运行本教程。

您现在可以使用peer lifecycle chaincode package命令创建链代码包:

1

|

peer lifecycle chaincode package fabcar.tar.gz --path ../chaincode/fabcar/go/ --lang golang --label fabcar_1

|

此命令将在您的当前目录中创建一个名为fabcar.tar.gz的包。该--lang标志用于指定链代码语言,该--path标志提供您的智能合约代码的位置。该路径必须是绝对路径或相对于您当前工作目录的路径。该--label标志用于指定链代码标签,该标签将在安装后标识您的链代码。建议您的标签包含链码名称和版本。

现在我们已经创建了链代码包,我们可以在测试网络的节点上安装链代码。

JavaScript

暂时不用

Java

暂时不用

安装链码包

在我们打包 Fabcar 智能合约后,我们可以在我们的节点上安装链代码。链代码需要安装在每个将认可交易的节点上。因为我们要将背书策略设置为需要来自 Org1 和 Org2 的背书,所以我们需要在两个组织运营的peer节点上安装链代码:

- peer0.org1.example.com

- peer0.org2.example.com

让我们先在 Org1 节点上安装链码。设置以下环境变量以 Org1 管理员用户操作peer 。将CORE_PEER_ADDRESS被设置为指向 Org1 的peer,peer0.org1.example.com。

1

2

3

4

5

|

export CORE_PEER_TLS_ENABLED=true

export CORE_PEER_LOCALMSPID="Org1MSP"

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org1.example.com/users/Admin@org1.example.com/msp

export CORE_PEER_ADDRESS=localhost:7051

|

发出peer lifecycle chaincode install命令以在peer节点上安装链代码:

1

|

peer lifecycle chaincode install fabcar.tar.gz

|

如果命令成功,peer将生成并返回包标识符。此包 ID 将用于在下一步中批准链代码。您应该看到类似于以下内容的输出:

1

2

|

2020-02-12 11:40:02.923 EST [cli.lifecycle.chaincode] submitInstallProposal -> INFO 001 Installed remotely: response:<status:200 payload:"\nIfabcar_1:69de748301770f6ef64b42aa6bb6cb291df20aa39542c3ef94008615704007f3\022\010fabcar_1" >

2020-02-12 11:40:02.925 EST [cli.lifecycle.chaincode] submitInstallProposal -> INFO 002 Chaincode code package identifier: fabcar_1:69de748301770f6ef64b42aa6bb6cb291df20aa39542c3ef94008615704007f3

|

我们现在可以在 Org2 节点上安装链码。设置以下环境变量以作为 Org2 管理员和在目标peer运行,peer0.org2.example.com.

1

2

3

4

5

|

export CORE_PEER_LOCALMSPID="Org2MSP"

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org2.example.com/users/Admin@org2.example.com/msp

export CORE_PEER_ADDRESS=localhost:9051

|

发出以下命令来安装链代码:

1

|

peer lifecycle chaincode install fabcar.tar.gz

|

链码是在安装链码时由peer构建的。如果智能合约代码有问题,安装命令将从链代码返回构建错误。

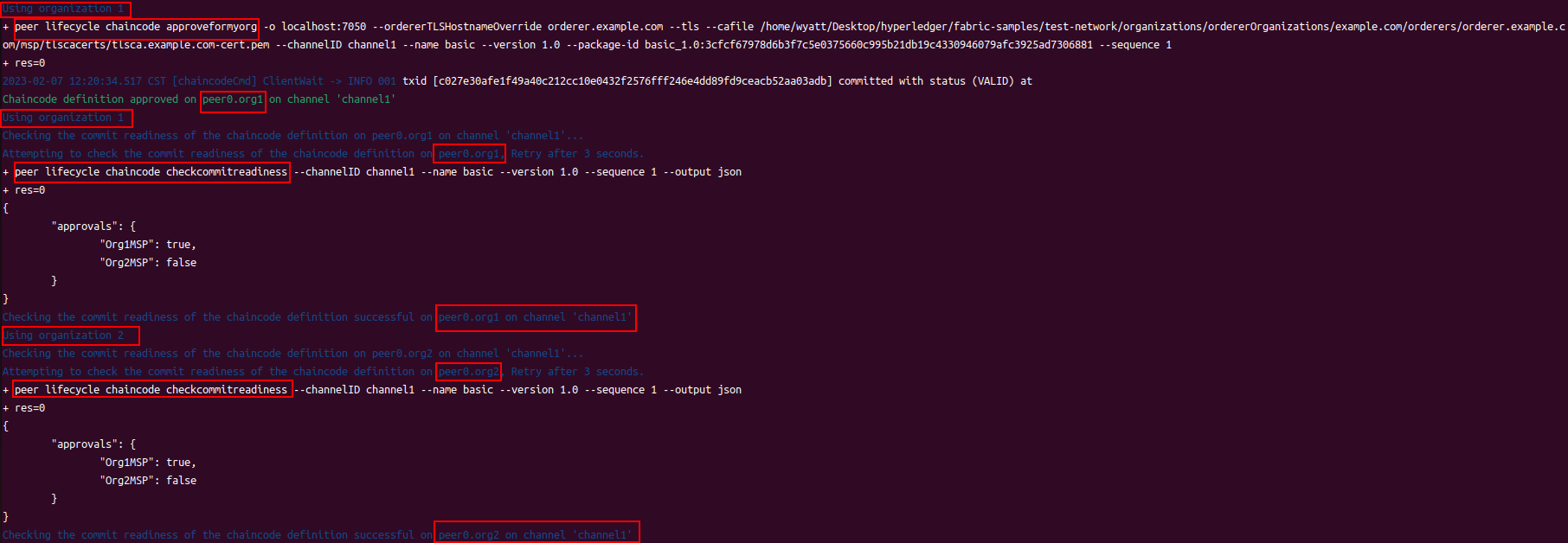

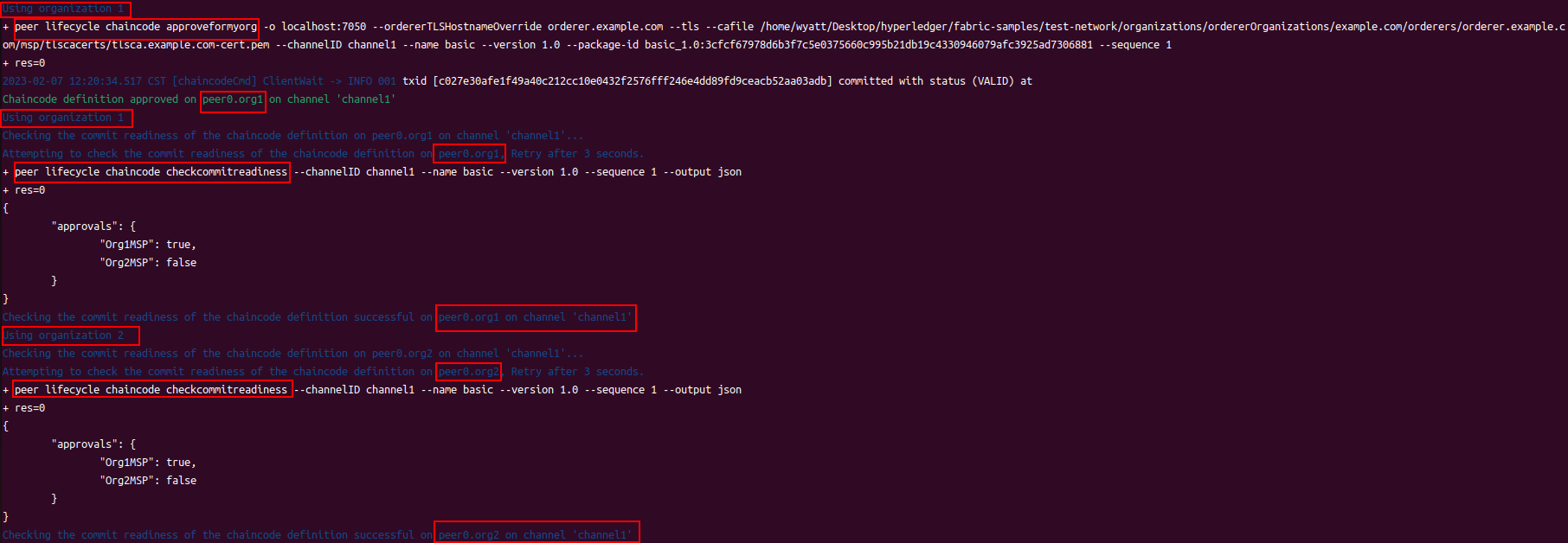

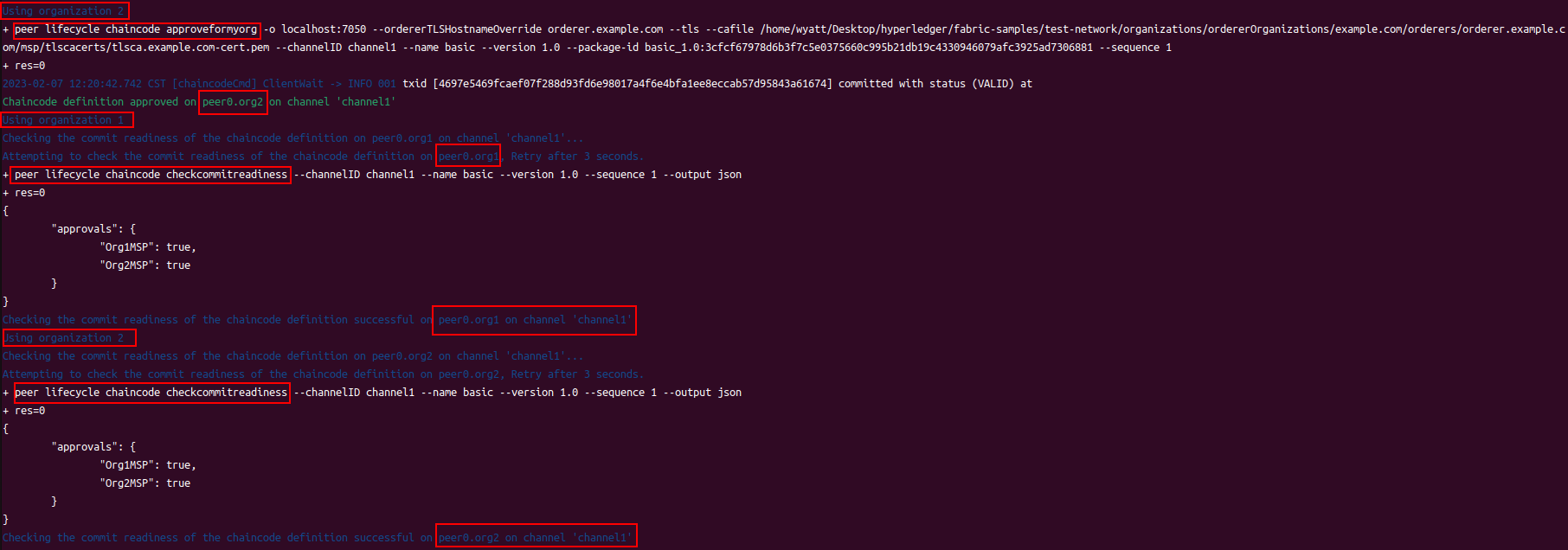

批准链码定义

安装链代码包后,您需要为您的组织批准链代码定义。该定义包括链代码治理的重要参数,例如名称、版本和链代码背书策略。

在部署之前需要批准链代码的一组通道成员由该Application/Channel/lifeycleEndorsement策略管理。默认情况下,此策略要求大多数通道成员需要批准链码才能在通道上使用。因为我们在通道上只有两个组织,并且 2 的多数是 2,所以我们需要批准 Fabcar 的链代码定义为 Org1 和 Org2。

如果一个组织已经在他们的peer上安装了链代码,他们需要在他们的组织批准的链代码定义中包含 packageID。包 ID 用于将安装在节点上的链代码与批准的链代码定义相关联,并允许组织使用链代码来背书交易。您可以使用peer lifecycle chaincode queryinstalled命令查询您的peer节点,从而找到链代码的包 ID。

1

|

peer lifecycle chaincode queryinstalled

|

包 ID 是链代码标签和链代码二进制文件的哈希值的组合。

Package ID = label : hash

每个peer都将生成相同的包 ID。您应该看到类似于以下内容的输出:

1

2

|

Installed chaincodes on peer:

Package ID: fabcar_1:69de748301770f6ef64b42aa6bb6cb291df20aa39542c3ef94008615704007f3, Label: fabcar_1

|

我们将在批准链代码时使用包 ID,因此让我们继续并将其保存为环境变量。将返回的包 ID 粘贴到下面的命令中。**注意:**所有用户的包 ID 都不相同,因此您需要使用上一步从命令窗口返回的包 ID 完成此步骤。peer lifecycle chaincode queryinstalled

1

|

export CC_PACKAGE_ID=fabcar_1:69de748301770f6ef64b42aa6bb6cb291df20aa39542c3ef94008615704007f3

|

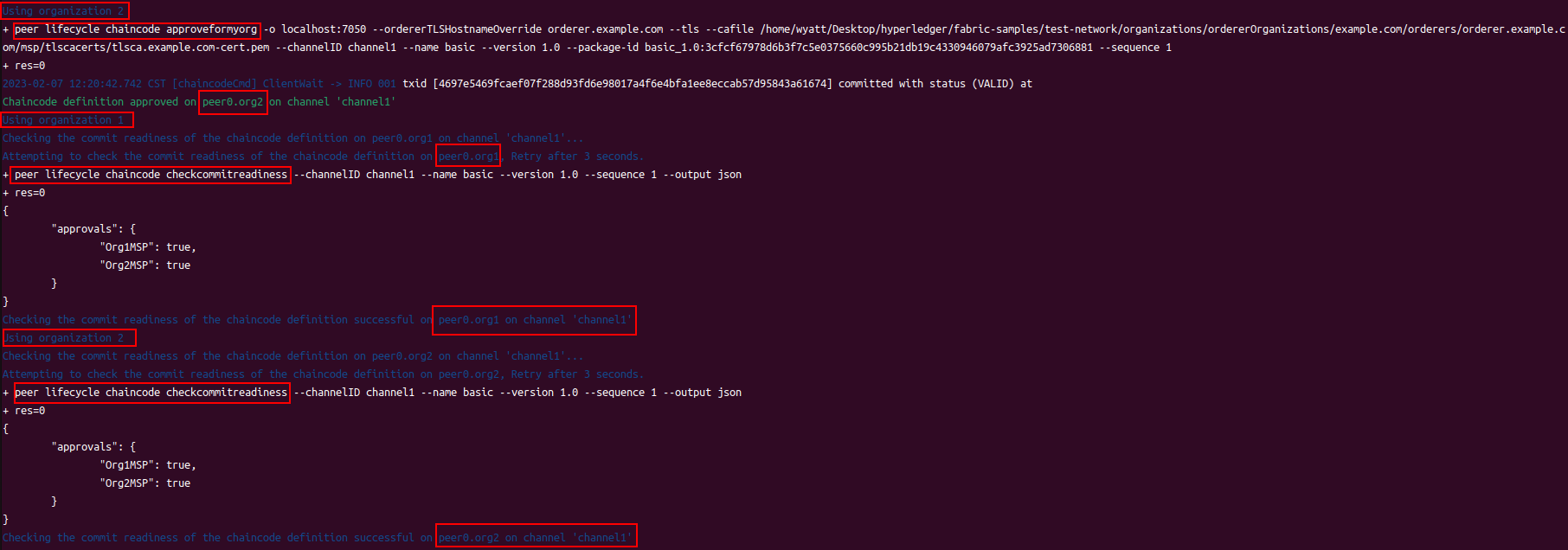

由于环境变量已设置为以 Org2 管理员身份运行 CLI,因此我们可以为 Org2 批准 Fabcar 的链代码定义。Chaincode 在组织级别获得批准的命令只需要一个peer节点。该批准被分发给该组织内其他peers通过gossip。使用peer lifecycle chaincode approveformyorg命令批准链代码定义:

1

|

peer lifecycle chaincode approveformyorg -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name fabcar --version 1.0 --package-id $CC_PACKAGE_ID --sequence 1 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem

|

上面的命令使用--package-id标志将包标识符包含在链码定义中。该--sequence参数是一个整数,用于跟踪定义或更新链代码的次数。因为链码是第一次部署到通道,所以序列号是 1。当 Fabcar 链码升级时,序列号将增加到 2。如果您使用的是 Fabric Chaincode Shim 提供的低级API,您可以将--init-required标志传递给上面的命令以请求执行 Init 函数来初始化链代码。链码的第一次调用需要以 Init 函数为目标并包含--isInit标志,然后您才能使用链码中的其他函数与账本进行交互。

我们--signature-policy可以--channel-config-policy为approveformyorg命令指定链代码背书策略。背书策略指定有多少属于不同通道成员的节点需要根据给定的链代码验证交易。因为我们没有设置策略,所以Fabcar的定义会使用默认的背书策略,即交易提交时需要得到在场的过半数通道成员的背书。这意味着如果在通道中添加或删除新组织,背书策略会自动更新以要求更多或更少的背书。在本教程中,默认策略将需要 2 中的多数,因此交易需要由来自 Org1 和 Org2 的peer节点背书。如果要指定自定义背书策略,可以使用背书策略操作指南以了解策略语法。

您需要使用具有管理员角色的身份来批准链代码定义。因此,该CORE_PEER_MSPCONFIGPATH变量需要指向包含管理员身份的 MSP 文件夹。您不能批准客户端用户的链代码定义。批准需要提交给订购服务,它将验证管理员签名,然后将批准分发给peer。

我们仍然需要为 Org1批准链码定义。设置以下环境变量以作为 Org1 管理员运行:

1

2

3

4

|

export CORE_PEER_LOCALMSPID="Org1MSP"

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org1.example.com/users/Admin@org1.example.com/msp

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt

export CORE_PEER_ADDRESS=localhost:7051

|

您现在可以为 Org1批准链代码定义。

1

|

peer lifecycle chaincode approveformyorg -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name fabcar --version 1.0 --package-id $CC_PACKAGE_ID --sequence 1 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem

|

我们现在拥有将 Fabcar 链代码部署到通道所需的大部分内容。虽然只有大多数组织需要批准链代码定义(使用默认策略),但所有组织都需要批准链代码定义才能在其peer上启动链代码。如果您在通道成员批准链码之前提交定义,组织将无法为交易背书。因此,建议所有通道成员在提交链代码定义之前批准链代码。

将链码定义提交到通道

在足够数量的组织批准链代码定义后,一个组织可以将链代码定义提交到通道。如果大多数通道成员批准了定义,则提交交易将成功,并且链代码定义中约定的参数将在通道上实现。

您可以使用peer lifecycle chaincode checkcommitreadiness命令来检查通道成员是否已批准相同的链代码定义。用于该checkcommitreadiness命令的标志与用于为您的组织批准链代码的标志相同。但是,您不需要包括--package-id标志。

1

|

peer lifecycle chaincode checkcommitreadiness --channelID mychannel --name fabcar --version 1.0 --sequence 1 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem --output json

|

该命令将生成一个 JSON 映射,如果通道成员批准了checkcommitreadiness命令中指定的参数,该映射就会显示:

1

2

3

4

5

6

|

{

"Approvals": {

"Org1MSP": true,

"Org2MSP": true

}

}

|

由于作为通道成员的两个组织都批准了相同的参数,因此链代码定义已准备好提交给通道。您可以使用peer lifecycle chaincode commit命令将链代码定义提交到通道。提交命令也需要由组织管理员提交。

1

|

peer lifecycle chaincode commit -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name fabcar --version 1.0 --sequence 1 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem --peerAddresses localhost:7051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt --peerAddresses localhost:9051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt

|

上面的交易使用--peerAddresses标记来自Org1的peer0.org1.example.com 和来自Org2的peer0.org2.example.com 。commit交易被提交给加入通道的peer节点,以查询链码定义是否被组织的peer批准。该命令需要来自足够数量组织的peer节点为目标,以满足部署链代码的策略。因为批准分布在每个组织内,所以您可以将属于通道成员的任何peer节点作为目标。

通道成员背书的链代码定义被提交给排序服务以添加到区块并分发到通道。然后通道上的节点验证是否有足够数量的组织批准了链码定义。peer lifecycle chaincode commit命令将在返回响应之前等待来自peer的验证。

您可以使用peer lifecycle chaincode querycommitted命令来确认链代码定义已提交到通道。

1

|

peer lifecycle chaincode querycommitted --channelID mychannel --name fabcar --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem

|

如果链码成功提交到通道,该querycommitted命令将返回链码定义的序列和版本:

1

2

|

Committed chaincode definition for chaincode 'fabcar' on channel 'mychannel':

Version: 1, Sequence: 1, Endorsement Plugin: escc, Validation Plugin: vscc, Approvals: [Org1MSP: true, Org2MSP: true]

|

调用链码

在将链代码定义提交到通道后,链代码将在加入安装链代码的通道的peer节点上启动。Fabcar 链代码现在已准备好供客户端应用程序调用。使用以下命令在分布式账本上创建一组初始汽车。请注意,invoke 命令需要以足够数量的peer节点为目标,以满足链代码背书策略。

1

|

peer chaincode invoke -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem -C mychannel -n fabcar --peerAddresses localhost:7051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt --peerAddresses localhost:9051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt -c '{"function":"initLedger","Args":[]}'

|

如果命令成功,您应该能够收到类似于以下内容的响应:

1

|

2020-02-12 18:22:20.576 EST [chaincodeCmd] chaincodeInvokeOrQuery -> INFO 001 Chaincode invoke successful. result: status:200

|

我们可以使用查询函数来读取由链代码创建的汽车集合:

1

|

peer chaincode query -C mychannel -n fabcar -c '{"Args":["queryAllCars"]}'

|

对查询的响应应该是以下汽车列表:

1

2

3

4

5

6

7

8

9

10

|

[{"Key":"CAR0","Record":{"make":"Toyota","model":"Prius","colour":"blue","owner":"Tomoko"}},

{"Key":"CAR1","Record":{"make":"Ford","model":"Mustang","colour":"red","owner":"Brad"}},

{"Key":"CAR2","Record":{"make":"Hyundai","model":"Tucson","colour":"green","owner":"Jin Soo"}},

{"Key":"CAR3","Record":{"make":"Volkswagen","model":"Passat","colour":"yellow","owner":"Max"}},

{"Key":"CAR4","Record":{"make":"Tesla","model":"S","colour":"black","owner":"Adriana"}},

{"Key":"CAR5","Record":{"make":"Peugeot","model":"205","colour":"purple","owner":"Michel"}},

{"Key":"CAR6","Record":{"make":"Chery","model":"S22L","colour":"white","owner":"Aarav"}},

{"Key":"CAR7","Record":{"make":"Fiat","model":"Punto","colour":"violet","owner":"Pari"}},

{"Key":"CAR8","Record":{"make":"Tata","model":"Nano","colour":"indigo","owner":"Valeria"}},

{"Key":"CAR9","Record":{"make":"Holden","model":"Barina","colour":"brown","owner":"Shotaro"}}]

|

升级智能合约

您可以使用相同的 Fabric 链码生命周期流程来升级已部署到通道的链码。通道成员可以通过安装新的链代码包来升级链代码,然后使用新的包 ID、新的链代码版本和序列号加一来批准链代码定义。将链码定义提交到通道后,可以使用新的链码。此过程允许通道成员在升级链代码时进行协调,并确保在将新链代码部署到通道之前有足够数量的通道成员准备好使用新链代码。

通道成员还可以使用升级过程来更改链代码背书策略。通过使用新背书策略批准链代码定义并将链代码定义提交到通道,通道成员可以更改管理链代码的背书策略,而无需安装新的链代码包。

为了提供升级我们刚刚部署的 Fabcar 链码的场景,我们假设 Org1 和 Org2 想要安装以另一种语言编写的链码版本。他们将使用 Fabric 链代码生命周期来更新链代码版本,并确保两个组织都已安装新的链代码,然后它才能在通道上激活。

我们假设 Org1 和 Org2 最初安装了 Fabcar 链代码的 GO 版本,但使用 JavaScript 编写的链代码会更舒服。第一步是打包 Fabcar 链代码的 JavaScript 版本。如果您在学习本教程时使用了 JavaScript 指令来打包链代码,则可以按照打包以Go或Java编写的链代码的步骤安装新的链代码二进制文件。

从test-network目录发出以下命令以安装链代码依赖项。

1

2

3

|

cd ../chaincode/fabcar/javascript

npm install

cd ../../../test-network

|

然后,您可以发出以下命令从test-network目录中打包 JavaScript 链代码。如果您关闭终端,我们将需要再次设置peer CLI 所需的环境变量。

1

2

3

4

|

export PATH=${PWD}/../bin:$PATH

export FABRIC_CFG_PATH=$PWD/../config/

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org1.example.com/users/Admin@org1.example.com/msp

peer lifecycle chaincode package fabcar_2.tar.gz --path ../chaincode/fabcar/javascript/ --lang node --label fabcar_2

|

运行以下命令以peerOrg1 管理员身份操作 CLI:

1

2

3

4

5

|

export CORE_PEER_TLS_ENABLED=true

export CORE_PEER_LOCALMSPID="Org1MSP"

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org1.example.com/users/Admin@org1.example.com/msp

export CORE_PEER_ADDRESS=localhost:7051

|

我们现在可以使用以下命令在 Org1 节点上安装新的链代码包。

1

|

peer lifecycle chaincode install fabcar_2.tar.gz

|

新的链代码包将创建一个新的包 ID。我们可以通过查询来找到新的包 ID。

1

|

peer lifecycle chaincode queryinstalled

|

该queryinstalled命令将返回已安装在您的对等方上的链码列表。

1

2

3

|

Installed chaincodes on peer:

Package ID: fabcar_1:69de748301770f6ef64b42aa6bb6cb291df20aa39542c3ef94008615704007f3, Label: fabcar_1

Package ID: fabcar_2:1d559f9fb3dd879601ee17047658c7e0c84eab732dca7c841102f20e42a9e7d4, Label: fabcar_2

|

您可以使用包标签找到新链代码的包 ID,并将其保存为新的环境变量。

1

|

export NEW_CC_PACKAGE_ID=fabcar_2:1d559f9fb3dd879601ee17047658c7e0c84eab732dca7c841102f20e42a9e7d4

|

Org1 现在可以批准新的链代码定义:

1

|

peer lifecycle chaincode approveformyorg -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name fabcar --version 2.0 --package-id $NEW_CC_PACKAGE_ID --sequence 2 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem

|

新的链码定义使用 JavaScript 链码包的包 ID 并更新链码版本。因为 Fabric 链代码生命周期使用序列参数来跟踪链代码升级,所以 Org1 还需要将序列号从 1 递增到 2。您可以使用peer lifecycle chaincode querycommitted命令来查找最后一个提交到通道的链代码的序列。

我们现在需要为 Org2 安装链码包并批准链码定义,以便升级链码。运行以下命令以Org2 管理员身份操作peer CLI:

1

2

3

4

5

|

export CORE_PEER_LOCALMSPID="Org2MSP"

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt

export CORE_PEER_TLS_ROOTCERT_FILE=${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt

export CORE_PEER_MSPCONFIGPATH=${PWD}/organizations/peerOrganizations/org2.example.com/users/Admin@org2.example.com/msp

export CORE_PEER_ADDRESS=localhost:9051

|

我们现在可以使用以下命令在 Org2 的peer节点上安装新的链代码包。

1

|

peer lifecycle chaincode install fabcar_2.tar.gz

|

您现在可以为Org2批准新链代码定义。

1

|

peer lifecycle chaincode approveformyorg -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name fabcar --version 2.0 --package-id $NEW_CC_PACKAGE_ID --sequence 2 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem

|

使用peer lifecycle chaincode checkcommitreadiness命令检查序列为 2 的链码定义是否已准备好提交到通道:

1

|

peer lifecycle chaincode checkcommitreadiness --channelID mychannel --name fabcar --version 2.0 --sequence 2 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem --output json

|

如果命令返回以下 JSON,则链代码已准备好升级:

1

2

3

4

5

6

|

{

"Approvals": {

"Org1MSP": true,

"Org2MSP": true

}

}

|

提交新的链代码定义后,链代码将在通道上升级。在此之前,之前的链代码将继续在两个组织的peer节点上运行。Org2 可以使用以下命令升级链码:

1

|

peer lifecycle chaincode commit -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name fabcar --version 2.0 --sequence 2 --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem --peerAddresses localhost:7051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt --peerAddresses localhost:9051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt

|

成功的提交事务将立即启动新的链代码。如果链代码定义更改了背书策略,则新策略将生效。

您可以使用docker ps命令来验证新链代码是否已在您的对等节点上启动:

1

2

3

4

5

6

7

|

$docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

197a4b70a392 dev-peer0.org1.example.com-fabcar_2-1d559f9fb3dd879601ee17047658c7e0c84eab732dca7c841102f20e42a9e7d4-d305a4e8b4f7c0bc9aedc84c4a3439daed03caedfbce6483058250915d64dd23 "docker-entrypoint.s…" 2 minutes ago Up 2 minutes dev-peer0.org1.example.com-fabcar_2-1d559f9fb3dd879601ee17047658c7e0c84eab732dca7c841102f20e42a9e7d4

b7e4dbfd4ea0 dev-peer0.org2.example.com-fabcar_2-1d559f9fb3dd879601ee17047658c7e0c84eab732dca7c841102f20e42a9e7d4-9de9cd456213232033c0cf8317cbf2d5abef5aee2529be9176fc0e980f0f7190 "docker-entrypoint.s…" 2 minutes ago Up 2 minutes dev-peer0.org2.example.com-fabcar_2-1d559f9fb3dd879601ee17047658c7e0c84eab732dca7c841102f20e42a9e7d4

8b6e9abaef8d hyperledger/fabric-peer:latest "peer node start" About an hour ago Up About an hour 0.0.0.0:7051->7051/tcp peer0.org1.example.com

429dae4757ba hyperledger/fabric-peer:latest "peer node start" About an hour ago Up About an hour 7051/tcp, 0.0.0.0:9051->9051/tcp peer0.org2.example.com

7de5d19400e6 hyperledger/fabric-orderer:latest "orderer" About an hour ago Up About an hour 0.0.0.0:7050->7050/tcp orderer.example.com

|

如果您使用了该--init-required标志,则需要先调用 Init 函数,然后才能使用升级后的链码。因为我们没有请求执行 Init,所以我们可以通过创建新汽车来测试我们新的 JavaScript 链码:

1

|

peer chaincode invoke -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --tls --cafile ${PWD}/organizations/ordererOrganizations/example.com/orderers/orderer.example.com/msp/tlscacerts/tlsca.example.com-cert.pem -C mychannel -n fabcar --peerAddresses localhost:7051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org1.example.com/peers/peer0.org1.example.com/tls/ca.crt --peerAddresses localhost:9051 --tlsRootCertFiles ${PWD}/organizations/peerOrganizations/org2.example.com/peers/peer0.org2.example.com/tls/ca.crt -c '{"function":"createCar","Args":["CAR11","Honda","Accord","Black","Tom"]}'

|

您可以再次查询分类账上的所有汽车以查看新车:

1

|

peer chaincode query -C mychannel -n fabcar -c '{"Args":["queryAllCars"]}'

|

您应该从 JavaScript 链代码中看到以下结果:

1

2

3

4

5

6

7

8

9

10

11

|

[{"Key":"CAR0","Record":{"make":"Toyota","model":"Prius","colour":"blue","owner":"Tomoko"}},

{"Key":"CAR1","Record":{"make":"Ford","model":"Mustang","colour":"red","owner":"Brad"}},

{"Key":"CAR11","Record":{"color":"Black","docType":"car","make":"Honda","model":"Accord","owner":"Tom"}},

{"Key":"CAR2","Record":{"make":"Hyundai","model":"Tucson","colour":"green","owner":"Jin Soo"}},

{"Key":"CAR3","Record":{"make":"Volkswagen","model":"Passat","colour":"yellow","owner":"Max"}},

{"Key":"CAR4","Record":{"make":"Tesla","model":"S","colour":"black","owner":"Adriana"}},

{"Key":"CAR5","Record":{"make":"Peugeot","model":"205","colour":"purple","owner":"Michel"}},

{"Key":"CAR6","Record":{"make":"Chery","model":"S22L","colour":"white","owner":"Aarav"}},

{"Key":"CAR7","Record":{"make":"Fiat","model":"Punto","colour":"violet","owner":"Pari"}},

{"Key":"CAR8","Record":{"make":"Tata","model":"Nano","colour":"indigo","owner":"Valeria"}},

{"Key":"CAR9","Record":{"make":"Holden","model":"Barina","colour":"brown","owner":"Shotaro"}}]

|

清理

当您使用完链码后,您还可以使用以下命令删除 Logspout 工具。

1

2

|

docker stop logspout

docker rm logspout

|

然后,您可以通过从test-network目录中发出以下命令来关闭测试网络:

下一步

编写智能合约并将其部署到通道后,您可以使用 Fabric SDK 提供的 API 从客户端应用程序调用智能合约。这允许用户与区块链分类账上的资产进行交互。要开始使用 Fabric SDK,请参阅编写您的第一个应用程序教程。

故障排除

该组织不同意链码

问题:当我尝试向通道提交新的链码定义时,命令失败并出现以下错误:peer lifecycle chaincode commit

1

|

Error: failed to create signed transaction: proposal response was not successful, error code 500, msg failed to invoke backing implementation of 'CommitChaincodeDefinition': chaincode definition not agreed to by this org (Org1MSP)

|

解决方案:您可以尝试通过使用命令peer lifecycle chaincode checkcommitreadiness检查哪些通道成员已批准您尝试提交的链代码定义来解决此错误。如果任何组织对链代码定义的任何参数使用了不同的值,提交事务将失败。peer lifecycle chaincode checkcommitreadiness将显示哪些组织不批准您尝试提交的链码定义

1

2

3

4

5

6

|

{

"approvals": {

"Org1MSP": false,

"Org2MSP": true

}

}

|

调用失败

问题:peer lifecycle chaincode commit交易成功,但当我第一次尝试调用链代码时,它失败并出现以下错误:``

1

|

Error: endorsement failure during invoke. response: status:500 message:"make sure the chaincode fabcar has been successfully defined on channel mychannel and try again: chaincode definition for 'fabcar' exists, but chaincode is not installed"

|

解决方案:您批准链代码定义时可能没有设置正确--package-id。因此,提交到通道的链代码定义未与您安装的链代码包相关联,并且链代码未在您的peer节点上启动。如果你正在运行基于 docker 的网络,你可以使用docker ps命令来检查你的链代码是否正在运行:

1

2

3

4

5

|

docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

7fe1ae0a69fa hyperledger/fabric-orderer:latest "orderer" 5 minutes ago Up 4 minutes 0.0.0.0:7050->7050/tcp orderer.example.com

2b9c684bd07e hyperledger/fabric-peer:latest "peer node start" 5 minutes ago Up 4 minutes 0.0.0.0:7051->7051/tcp peer0.org1.example.com

39a3e41b2573 hyperledger/fabric-peer:latest "peer node start" 5 minutes ago Up 4 minutes 7051/tcp, 0.0.0.0:9051->9051/tcp peer0.org2.example.com

|

如果您没有看到列出任何链代码容器,请使用命令peer lifecycle chaincode approveformyorg 证明链码定义使用了正确的package ID。

背书政策失败

问题:当我尝试将链代码定义提交到通道时,交易失败并出现以下错误:

1

2

|

2020-04-07 20:08:23.306 EDT [chaincodeCmd] ClientWait -> INFO 001 txid [5f569e50ae58efa6261c4ad93180d49ac85ec29a07b58f576405b826a8213aeb] committed with status (ENDORSEMENT_POLICY_FAILURE) at localhost:7051

Error: transaction invalidated with status (ENDORSEMENT_POLICY_FAILURE)

|

解决方案:此错误是提交事务未收集到足够的背书以满足生命周期背书策略的结果。此问题可能是由于您的交易没有针对足够数量的同行来满足政策。这也可能是某些同行组织未在其文件中Endorsement:包含默认策略引用/Channel/Application/Endorsement的configtx.yaml

1

2

3

4

5

6

7

8

9

10

11

12

|

Readers:

Type: Signature

Rule: "OR('Org2MSP.admin', 'Org2MSP.peer', 'Org2MSP.client')"

Writers:

Type: Signature

Rule: "OR('Org2MSP.admin', 'Org2MSP.client')"

Admins:

Type: Signature

Rule: "OR('Org2MSP.admin')"

Endorsement:

Type: Signature

Rule: "OR('Org2MSP.peer')"

|

当您启用 Fabric 链代码生命周期V2_0时,除了将您的通道升级到该功能之外,您还需要使用新的 Fabric 2.0 通道策略。您的频道需要包含新/Channel/Application/LifecycleEndorsement政策/Channel/Application/Endorsement:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

Policies:

Readers:

Type: ImplicitMeta

Rule: "ANY Readers"

Writers:

Type: ImplicitMeta

Rule: "ANY Writers"

Admins:

Type: ImplicitMeta

Rule: "MAJORITY Admins"

LifecycleEndorsement:

Type: ImplicitMeta

Rule: "MAJORITY Endorsement"

Endorsement:

Type: ImplicitMeta

Rule: "MAJORITY Endorsement"

|

如果您不在通道配置中包含新通道策略,则在为您的组织批准链代码定义时会出现以下错误:

1

|

Error: proposal failed with status: 500 - failed to invoke backing implementation of 'ApproveChaincodeDefinitionForMyOrg': could not set defaults for chaincode definition in channel mychannel: policy '/Channel/Application/Endorsement' must be defined for channel 'mychannel' before chaincode operations can be attempted

|

编写你的第一个应用

本教程将介绍Fabric应用程序如何与已部署的区块链网络交互。 该教程使用Fabric SDKs构建的示例程序——详细阐述在 应用 专题中——调用一个智能合约, 该合约使用智能合约API——详细阐述在 智能合约处理 中——查询和更新账本。 我们还将使用我们的示例程序和已部署的证书颁发机构来生成X.509证书, 应用程序需要这些证书才能与许可性的区块链交互。

关于 FabCar

FabCar例子演示了如何查询保存在账本上的Car(我们业务对象例子),以及如何更新账本(向账本添加新的Car)。 它包含以下两个组件:

- 示例应用程序:调用区块链网络,调用智能合约中实现的交易。

- 智能合约:实现了涉及与账本交互的交易。

我们将按照以下三个步骤进行:

1. 搭建开发环境。 我们的应用程序需要和网络交互,所以我们需要一个智能合约和应用程序使用的基础网络。

2. 浏览一个示例智能合约。 我们将查看示例智能合约 Fabcar 来学习他们的交易,还有应用程序是怎么使用他们来进行查询和更新账本的。

3. 使用示例应用程序和智能合约交互。 我们的应用程序将使用 FabCar 智能合约来查询和更新账本上的汽车资产。我们将进入到应用程序的代码和他们创建的交易,包括查询一辆汽车,查询一批汽车和创建一辆新车。

在完成这个教程之后,你将基本理解一个应用是如何通过编程关联智能合约来和 Fabric 网络上的多个节点的账本的进行交互的。

准备工作

除了Fabric的标准 准备阶段 之外,本教程还利用了Node.js对应的Hyperledger Fabric SDK。 有关最新的预备知识列表,请参阅Node.js SDK README 。

1

|

sudo apt install build-essential

|

设置区块链网络

如果你已经学习了 使用Fabric的测试网络 而且已经运行起来了一个网络,本教程将在启动一个新网络之前关闭正在运行的网络。

启动网络

这个教程演示了 Javascript 版本的 FabCar 智能合约和应用程序,但是 fabric-samples 仓库也包含 Go、Java 和 TypeScript 版本的样例。想尝试 Go、Java 或者 TypeScript 版本,改变下边的 ./startFabric.sh 的 javascript 参数为 go、 java 或者 typescript,然后跟着介绍写到终端中。

进入你克隆到本地的 fabric-samples 仓库的 fabcar 子目录。

1

|

cd fabric-samples/fabcar

|

使用 startFabric.sh 脚本启动网络。

此命令将部署两个peer节点和一个排序节点以部署Fabric测试网络。 我们将使用证书颁发机构(Fabric-CA)启动测试网络,而不是使用cryptogen工具。 我们将使用这些CA的其中一个来创建证书以及一些key, 这些加密资料将在之后的步骤中被我们的应用程序使用。startFabric.sh 脚本还将部署和初始化在 mychannel 通道上的 FabCar智能合约的Go版本,然后调用智能合约来把初始数据存储在帐本上。

示例应用

FabCar的第一个组件:示例应用程序,适用于以下几种语言:

在本教程中,我们将阐释用 javascript 为node.js编写的示例。

从 fabric-samples/fabcar 目录,进入到 javascript 文件夹。

该目录包含使用Node.js对应的Fabric SDK 开发的示例程序。运行以下命令安装应用程序依赖项。 这大约需要1分钟完成:

这个指令将安装应用程序的主要依赖,这些依赖定义在 package.json 中。其中最重要的是 fabric-network 类;它使得应用程序可以使用身份、钱包和连接到通道的网关,以及提交交易和等待通知。本教程也将使用 fabric-ca-client 类来注册用户以及他们的授权证书,生成一个 fabric-network 在后边会用到的合法身份。

完成 npm install ,运行应用程序所需要的一切就准备好了。让我们来看一眼教程中使用的示例 JavaScript 应用文件:

你会看到下边的文件:

1

2

|

enrollAdmin.js node_modules package.json registerUser.js

invoke.js package-lock.json query.js wallet

|

里边也有一些其他编程语言的文件,比如在 fabcar/java 目录中。当你使用过 JavaScript 示例之后,你可以看一下它们,主要的内容都是一样的。

登记管理员用户

下边会执行和证书授权服务器的通讯。在运行下边的程序时,打开一个新终端,并运行 docker logs -f ca_org1 来查看 CA 的日志流,会很有帮助。

当我们创建网络的时候,一个管理员用户( admin)被证书授权服务器(CA)创建成了 注册员 。我们第一步要使用 enroll.js 程序为 admin 生成私钥、公钥和 x.509 证书。这个程序使用一个 证书签名请求 (CSR)——先在本地生成公钥和私钥,然后把公钥发送到 CA ,CA 会发布会一个让应用程序使用的证书。这三个证书会保存在钱包中,以便于我们以管理员的身份使用 CA 。

我们登记一个 admin 用户:

这个命令将 CA 管理员的证书保存在 wallet 目录。 您可以在 wallet/admin.id 文件中找到管理员的证书和私钥。

注册和登记应用程序用户

既然我们的 admin 是用来与CA一起工作的。 我们也已经在钱包中有了管理员的凭据, 那么我们可以创建一个新的应用程序用户,它将被用于与区块链交互。 运行以下命令注册和记录一个名为 appUser 的新用户:

与admin注册类似,该程序使用CSR注册 appUser 并将其凭证与 admin 凭证一起存储在钱包中。 现在,我们有了两个独立用户的身份—— admin 和 appUser ——它们可以被我们的应用程序使用。

查询账本

区块链网络中的每个节点都拥有一个 账本 的副本,应用程序可以通过执行智能合约查询账本上最新的数据来实现来查询账本,并将查询结果返回给应用程序。

这里是一个查询工作如何进行的简单说明:

最常用的查询是查寻账本中询当前的值,也就是 世界状态 。世界状态是一个键值对的集合,应用程序可以根据一个键或者多个键来查询数据。而且,当键值对是以 JSON 值模式组织的时候,世界状态可以通过配置使用数据库(如 CouchDB )来支持富查询。这对于查询所有资产来匹配特定的键的值是很有用的,比如查询一个人的所有汽车。

首先,我们来运行我们的 query.js 程序来返回账本上所有汽车的侦听。这个程序使用我们的第二个身份——user1——来操作账本。

输入结果应该类似下边:

1

2

3

4

5

6

7

8

9

10

11

12

|

Wallet path: ...fabric-samples/fabcar/javascript/wallet

Transaction has been evaluated, result is:

[{"Key":"CAR0","Record":{"color":"blue","docType":"car","make":"Toyota","model":"Prius","owner":"Tomoko"}},

{"Key":"CAR1","Record":{"color":"red","docType":"car","make":"Ford","model":"Mustang","owner":"Brad"}},

{"Key":"CAR2","Record":{"color":"green","docType":"car","make":"Hyundai","model":"Tucson","owner":"Jin Soo"}},

{"Key":"CAR3","Record":{"color":"yellow","docType":"car","make":"Volkswagen","model":"Passat","owner":"Max"}},

{"Key":"CAR4","Record":{"color":"black","docType":"car","make":"Tesla","model":"S","owner":"Adriana"}},

{"Key":"CAR5","Record":{"color":"purple","docType":"car","make":"Peugeot","model":"205","owner":"Michel"}},

{"Key":"CAR6","Record":{"color":"white","docType":"car","make":"Chery","model":"S22L","owner":"Aarav"}},

{"Key":"CAR7","Record":{"color":"violet","docType":"car","make":"Fiat","model":"Punto","owner":"Pari"}},

{"Key":"CAR8","Record":{"color":"indigo","docType":"car","make":"Tata","model":"Nano","owner":"Valeria"}},

{"Key":"CAR9","Record":{"color":"brown","docType":"car","make":"Holden","model":"Barina","owner":"Shotaro"}}]

|

让我们仔细看看 query.js 程序如何使用 Fabric Node SDK 提供的API与我们的Fabric网络交互。 使用一个编辑器(比如, atom 或 visual studio)打开 query.js 。

应用程序首先从 fabric-network 模块 引入两个key类:Wallets 和 Gateway 到scope中。 这些类将用于定位钱包中的 appUser 身份, 并使用它连接到网络:

1

|

const { Gateway, Wallets } = require('fabric-network');

|

首先,程序使用Wallet类从我们的文件系统获取应用程序用户。

1

|

const identity = await wallet.get('appUser');

|

一旦程序有了身份标识,它便会使用Gateway类连接到我们的网络。

1

2

|

const gateway = new Gateway();

await gateway.connect(ccpPath, { wallet, identity: 'appUser', discovery: { enabled: true, asLocalhost: true } });

|

ccpPath 描述了连接配置文件的路径, 我们的应用程序将使用该配置文件连接到我们的网络。 连接配置文件从 fabric-samples/test-network 目录中被加载进来, 并解析为JSON文件:

1

|

const ccpPath = path.resolve(__dirname, '..', '..', 'test-network','organizations','peerOrganizations','org1.example.com', 'connection-org1.json');

|

如果你想了解更多关于连接配置文件的结构,和它是怎么定义网络的,请查阅 连接配置文件主题 。

一个网络可以被差分成很多通道,代码中下一个很重要的一行是将应用程序连接到网络中特定的通道 mychannel 上:

1

|

const network = await gateway.getNetwork('mychannel');

|

在这个通道中,我们可以通过 FabCar 智能合约来和账本进行交互:

1

|

const contract = network.getContract('fabcar');

|

在 fabcar 中有许多不同的 交易 ,我们的应用程序先使用 queryAllCars 交易来查询账本世界状态的值:

1

|

const result = await contract.evaluateTransaction('queryAllCars');

|

evaluateTransaction 方法代表了一种区块链网络中和智能合约最简单的交互。它只是根据配置文件中的定义连接一个节点,然后向节点发送请求,请求内容将在节点中执行。智能合约查询节点账本上的所有汽车,然后把结果返回给应用程序。这次交互没有导致账本的更新。

FabCar智能合约

FabCar智能合约示例有以下几种语言版本:

让我们来看看用JavaScript编写的FabCar智能合约中的交易。 打开一个新终端,并导航到 fabric-samples 仓库里 JavaScript版本的FabCar智能合约:

1

|

cd fabric-samples/chaincode/fabcar/javascript/lib

|

在文本编辑器中打开 fabcar.js 文件。

看看我们的智能合约是如何使用 Contract 类定义的

1

|

class FabCar extends Contract {...

|

在这个类结构中,你将看到定义了以下交易: initLedger, queryCar, queryAllCars, createCar 和 changeCarOwner 。例如:

1

2

|

async queryCar(ctx, carNumber) {...}

async queryAllCars(ctx) {...}

|

让我们更进一步看一下 queryAllCars ,看一下它是怎么和账本交互的。

1

2

3

4

5

6

|

async queryAllCars(ctx) {

const startKey = '';

const endKey = '';

const iterator = await ctx.stub.getStateByRange(startKey, endKey);

|

这段代码展示了如何使用 getStateByRange 在一个key范围内从账本中检索所有的汽车。 给出的空startKey和endKey将被解释为从起始到结束的所有key。 另一个例子是,如果您使用 startKey = 'CAR0', endKey = 'CAR999' , 那么 getStateByRange 将以字典顺序检索在CAR0和CAR999之间key的汽车。 其余代码遍历查询结果,并将结果封装为JSON,以供示例应用程序使用。

下面展示了应用程序如何调用智能合约中的不同交易。每一个交易都使用一组 API 比如 getStateByRange 来和账本进行交互。了解更多 API 请阅读 detail.

你可以看到我们的 queryAllCars 交易,还有另一个叫做 createCar 。我们稍后将在教程中使用他们来更新账本和添加新的区块。

但是在那之前,返回到应用程序中的 query.js 程序,更改 evaluateTransaction 的请求来查询 CAR4 。 query 程序现在看起来应该是这个样子:

1

|

const result = await contract.evaluateTransaction('queryCar', 'CAR4');

|

保存程序,然后返回到 fabcar/javascript 目录。现在,再次运行 query 程序:

你应该会看到如下:

1

2

3

|

Wallet path: ...fabric-samples/fabcar/javascript/wallet

Transaction has been evaluated, result is:

{"color":"black","docType":"car","make":"Tesla","model":"S","owner":"Adriana"}

|

如果你回头去看一下 queryAllCars 的交易结果,你会看到 CAR4 是 Adriana 的黑色 Tesla model S,也就是这里返回的结果。

我们可以使用 queryCar 交易来查询任意汽车,使用它的键 (比如 CAR0 )得到车辆的制造商、型号、颜色和车主等相关信息。

很棒。现在你应该已经了解了智能合约中基础的查询交易,也手动修改了查询程序中的参数。

更新账本

现在我们已经完成一些账本的查询和添加了一些代码,我们已经准备好更新账本了。有很多的更新操作我们可以做,但是我们从创建一个 新 车开始。

从一个应用程序的角度来说,更新一个账本很简单。应用程序向区块链网络提交一个交易,当交易被验证和提交后,应用程序会收到一个交易成功的提醒。但是在底层,区块链网络中各组件中不同的 共识 程序协同工作,来保证账本的每一个更新提案都是合法的,而且有一个大家一致认可的顺序。

上图中,我们可以看到完成这项工作的主要组件。同时,多个节点中每一个节点都拥有一份账本的副本,并可选的拥有一份智能合约的副本,网络中也有一个排序服务。排序服务保证网络中交易的一致性;它也将连接到网络中不同的应用程序的交易以定义好的顺序生成区块。

我们对账本的的第一个更新是创建一辆新车。我们有一个单独的程序叫做 invoke.js ,用来更新账本。和查询一样,使用一个编辑器打开程序定位到我们构建和提交交易到网络的代码段:

1

|

await contract.submitTransaction('createCar', 'CAR12', 'Honda', 'Accord', 'Black', 'Tom');

|

看一下应用程序如何调用智能合约的交易 createCar 来创建一量车主为 Tom 的黑色 Honda Accord 汽车。我们使用 CAR12 作为这里的键,这也说明了我们不必使用连续的键。

保存并运行程序:

如果执行成功,你将看到类似输出:

1

2

|

Wallet path: ...fabric-samples/fabcar/javascript/wallet

Transaction has been submitted

|

注意 inovke 程序是怎样使用 submitTransaction API 和区块链网络交互的,而不是 evaluateTransaction 。

1

|

await contract.submitTransaction('createCar', 'CAR12', 'Honda', 'Accord', 'Black', 'Tom');

|

submitTransaction 比 evaluateTransaction 更加复杂。除了跟一个单独的 peer 进行互动外,SDK 会将 submitTransaction 提案发送给在区块链网络中的每个需要的组织的 peer。其中的每个 peer 将会使用这个提案来执行被请求的智能合约,以此来产生一个建议的回复,它会为这个回复签名并将其返回给 SDK。SDK 搜集所有签过名的交易反馈到一个单独的交易中,这个交易会被发送给排序节点。排序节点从每个应用程序那里搜集并将交易排序,然后打包进一个交易的区块中。接下来它会将这些区块分发给网络中的每个 peer,在那里每笔交易会被验证并提交。最后,SDK 会被通知,这允许它能够将控制返回给应用程序。

submitTransaction 也包含一个监听者,它会检查来确保交易被验证并提交到账本中。应用程序应该使用一个提交监听者,或者使用像 submitTransaction 这样的 API 来给你做这件事情。如果不做这个,你的交易就可能没有被成功地排序、验证以及提交到账本。

应用程序中的这些工作由 submitTransaction 完成!应用程序、智能合约、节点和排序服务一起工作来保证网络中账本一致性的程序被称为共识,它的详细解释在这里 section 。

为了查看这个被写入账本的交易,返回到 query.js 并将参数 CAR4 更改为 CAR12 。

就是说,将:

1

|

const result = await contract.evaluateTransaction('queryCar', 'CAR4');

|

改为:

1

|

const result = await contract.evaluateTransaction('queryCar', 'CAR12');

|

再次保存,然后查询:

应该返回这些:

1

2

3

|

Wallet path: ...fabric-samples/fabcar/javascript/wallet

Transaction has been evaluated, result is:

{"color":"Black","docType":"car","make":"Honda","model":"Accord","owner":"Tom"}

|

恭喜。你创建了一辆汽车并验证了它记录在账本上!

现在我们已经完成了,我们假设 Tom 很大方,想把他的 Honda Accord 送给一个叫 Dave 的人。

为了完成这个,返回到 invoke.js 然后利用输入的参数,将智能合约的交易从 createCar 改为 changeCarOwner :

1

|

await contract.submitTransaction('changeCarOwner', 'CAR12', 'Dave');

|

第一个参数 CAR12 表示将要易主的车。第二个参数 Dave 表示车的新主人。

再次保存并执行程序:

现在我们来再次查询账本,以确定 Dave 和 CAR12 键已经关联起来了:

将返回如下结果:

1

2

3

|

Wallet path: ...fabric-samples/fabcar/javascript/wallet

Transaction has been evaluated, result is:

{"color":"Black","docType":"car","make":"Honda","model":"Accord","owner":"Dave"}

|

CAR12 的主人已经从 Tom 变成了 Dave。

在真实世界中的一个应用程序里,智能合约应该有一些访问控制逻辑。比如,只有某些有权限的用户能够创建新车,并且只有车辆的拥有者才能够将车辆交换给其他人。

清除数据

当你完成FabCar示例的尝试后,您就可以使用 networkDown.sh 脚本关闭测试网络。

该命令将关闭我们创建的网络的CA、peer节点和排序节点。 它还将删除保存在 wallet 目录中的 admin 和 appUser 加密资料。 请注意,帐本上的所有数据都将丢失。 如果您想再次学习本教程,您将会以初始状态的形式启动网络。

总结

现在我们完成了一些查询和更新,你应该已经比较了解如何通过智能合约和区块链网络进行交互来查询和更新账本。我们已经看过了查询和更新的基本角智能合约、API 和 SDK ,你也应该对如何在其他的商业场景和操作中使用不同应用有了一些认识。

其他资源

就像我们在介绍中说的,我们有一整套文章在 开发应用 包含了关于智能合约、程序和数据设计的更多信息,一个更深入的使用 商业票据的教程 和大量应用开发的相关资料。

商业票据教程

本教程将向您展示如何安装和使用商业票据样例应用程序和智能合约。该主题是以任务为导向的, 因此它更侧重的是流程而不是概念。如果您想更深入地了解这些概念,可以阅读开发应用主题。

在本教程中,MagnetoCorp 和 DigiBank 这两个组织使用 Hyperledger Fabric 区块链网络 PaperNet 相互交易商业票据。

一旦搭建了一个基本的网络,您就将扮演 MagnetoCorp 的员工 Isabella,她将代表公司发行商业票据。然后,您将转换角色,担任 DigiBank 的员工 Balaji,他将购买此商业票据,持有一段时间,然后向 MagnetoCorp 赎回该商业票据,以获取小额利润。

您将扮演开发人员,最终用户和管理员,这些角色位于不同组织中,都将执行以下步骤,这些步骤旨在帮助您了解作为两个不同组织独立工作,但要根据Hyperledger Fabric 网络中双方共同商定的规则来进行协作是什么感觉。

本教程已经在 MacOS 和 Ubuntu 上进行了测试,应该可以在其他 Linux 发行版上运行。Windows版本的教程正在开发中。

准备阶段

在开始之前,您必须安装本教程所需的一些必备工具。我们将必备工具控制在最低限度,以便您能快速开始。

您必须安装以下软件:

- Node, Node.js SDK的README文档包含准备阶段中 对应最新版本的清单。

您会发现安装以下软件很有帮助:

您可能会发现,随着您在应用程序和智能合约开发方面的经验越来越丰富,安装以下软件会很有帮助。首次运行教程时无需安装这些:

下载示例

商业票据教程是fabric-samples仓库中的示例之一。 在开始本教程之前, 确保您已经按照说明安装了Fabric 准备阶段必备工具 并下载示例、二进制文件和Docker映像。 当您完成后,您便克隆了包含教程脚本、 智能合约和应用程序文件的 fabric-samples 仓库。

下载

下载 fabric-samples GitHub仓库到您的本地机器。

下载后,可随意查看fabric-samples的目录结构:

1

2

3

4

5

6

7

8

9

|

$ cd fabric-samples

$ ls

CODEOWNERS SECURITY.md first-network

CODE_OF_CONDUCT.md chaincode high-throughput

CONTRIBUTING.md chaincode-docker-devmode interest_rate_swaps

LICENSE ci off_chain_data

MAINTAINERS.md commercial-paper test-network

README.md fabcar

|

注意 commercial-paper 目录,我们的示例就在这里!

现在您已经完成了教程的第一个阶段!随着您继续操作,您将为不同用户和组件打开多个命令窗口。例如:

- 为了显示来自您的网络的peer节点、排序服务节点和CA日志输出。

- 作为MagnetoCorp组织和DigiBank组织的管理员, 审批同意链码。

- 代表Isabella和Balaji运行应用程序, 他们将使用智能合约彼此交易商业票据。

当您应该从特定命令窗口运行一项命令时,我们将详细说明这一点。例如:

这表示您应该在 Isabella 的窗口中执行 ls 命令。

创建网络

本教程将使用Fabric测试网络部署智能合约。 测试网络由两个peer组织和一个排序服务组织组成。 两个组织各自操作一个peer节点, 而排序服务组织操作单个Raft排序服务节点。 我们还将使用测试网络创建一个名为mychannel的单一通道, 两个peer组织都将是该通道的成员。

The Hyperledger Fabric 基础网络的组成部分包括一个节点及该节点的账本数据库,一个排序服务和一个证书授权中心(CA)。以上每个组件都在一个 Docker 容器中运行。

The Hyperledger Fabric 基础网络的组成部分包括一个节点及该节点的账本数据库,一个排序服务和一个证书授权中心(CA)。以上每个组件都在一个 Docker 容器中运行。

每个组织运行自己的证书颁发机构。 两个peer节点、状态数据库、排序服务节点 和每个组织CA都在各自的Docker容器中运行。 在生产环境中,组织通常使用与其他系统共享的现有CA; 它们不是专用于Fabric网络的。

测试网络的两个组织允许我们以两个独立的组织形式, 操作不同的peer节点与一个区块链帐本交互。 在本教程中,我们将作为DigiBank操作测试网络中的Org1 以及作为MagnetoCorp操作Org2。

您可以启动测试网络, 并使用商业票据目录中提供的脚本创建通道。 进入到fabric-samples中的commercial-paper目录:

1

|

cd fabric-samples/commercial-paper

|

然后使用脚本启动测试网络:

当脚本运行时,您将看到部署测试网络的日志。 当脚本完成后,您可以使用docker ps命令 查看Fabric节点在您的本地机器上的运行情况:

1

2

3

4

5

6

7

8

9

10

11

|

$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

a86f50ca1907 hyperledger/fabric-peer:latest "peer node start" About a minute ago Up About a minute 7051/tcp, 0.0.0.0:9051->9051/tcp peer0.org2.example.com

77d0fcaee61b hyperledger/fabric-peer:latest "peer node start" About a minute ago Up About a minute 0.0.0.0:7051->7051/tcp peer0.org1.example.com

7eb5f64bfe5f hyperledger/fabric-couchdb "tini -- /docker-ent…" About a minute ago Up About a minute 4369/tcp, 9100/tcp, 0.0.0.0:5984->5984/tcp couchdb0

2438df719f57 hyperledger/fabric-couchdb "tini -- /docker-ent…" About a minute ago Up About a minute 4369/tcp, 9100/tcp, 0.0.0.0:7984->5984/tcp couchdb1

03373d116c5a hyperledger/fabric-orderer:latest "orderer" About a minute ago Up About a minute 0.0.0.0:7050->7050/tcp orderer.example.com

6b4d87f65909 hyperledger/fabric-ca:latest "sh -c 'fabric-ca-se…" About a minute ago Up About a minute 7054/tcp, 0.0.0.0:8054->8054/tcp ca_org2

7b01f5454832 hyperledger/fabric-ca:latest "sh -c 'fabric-ca-se…" About a minute ago Up About a minute 7054/tcp, 0.0.0.0:9054->9054/tcp ca_orderer

87aef6062f23 hyperledger/fabric-ca:latest "sh -c 'fabric-ca-se…" About a minute ago Up About a minute 0.0.0.0:7054->7054/tcp ca_org1

|

看看您是否可以将这些容器映射到基本网络上(可能需要横向移动才能找到信息):

- Org1的peer,

peer0.org1.example.com, 在容器a86f50ca1907上运行

- Org2的peer,

peer0.org2.example.com, 在容器77d0fcaee61b上运行

- Org1的peer对应的CouchDB数据库,

couchdb0, 在容器7eb5f64bfe5f上运行

- Org2的peer对应的CouchDB数据库,

couchdb1, 在容器2438df719f57上运行

- 排序服务节点,

orderer.example.com, 在容器03373d116c5a上运行

- Org1的CA,

ca_org1, 在容器87aef6062f23上运行

- Org2的CA,

ca_org2, 在容器6b4d87f65909上运行

- 排序服务Org的CA,

ca_orderer, 在容器7b01f5454832上运行

所有这些容器构成了被称作 fabric_test 的 docker 网络。您可以使用 docker network 命令查看该网络:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

|

$ docker network inspect fabric_test

[

{

"Name": "fabric_test",

"Id": "f4c9712139311004b8f7acc14e9f90170c5dcfd8cdd06303c7b074624b44dc9f",

"Created": "2020-04-28T22:45:38.525016Z",

"Containers": {

"03373d116c5abf2ca94f6f00df98bb74f89037f511d6490de4a217ed8b6fbcd0": {

"Name": "orderer.example.com",

"EndpointID": "0eed871a2aaf9a5dbcf7896aa3c0f53cc61f57b3417d36c56747033fd9f81972",

"MacAddress": "02:42:c0:a8:70:05",

"IPv4Address": "192.168.112.5/20",

"IPv6Address": ""

},

"2438df719f57a597de592cfc76db30013adfdcfa0cec5b375f6b7259f67baff8": {

"Name": "couchdb1",

"EndpointID": "52527fb450a7c80ea509cb571d18e2196a95c630d0f41913de8ed5abbd68993d",

"MacAddress": "02:42:c0:a8:70:06",

"IPv4Address": "192.168.112.6/20",

"IPv6Address": ""

},

"6b4d87f65909afd335d7acfe6d79308d6e4b27441b25a829379516e4c7335b88": {

"Name": "ca_org2",

"EndpointID": "1cc322a995880d76e1dd1f37ddf9c43f86997156124d4ecbb0eba9f833218407",

"MacAddress": "02:42:c0:a8:70:04",

"IPv4Address": "192.168.112.4/20",

"IPv6Address": ""

},

"77d0fcaee61b8fff43d33331073ab9ce36561a90370b9ef3f77c663c8434e642": {

"Name": "peer0.org1.example.com",

"EndpointID": "05d0d34569eee412e28313ba7ee06875a68408257dc47e64c0f4f5ef4a9dc491",

"MacAddress": "02:42:c0:a8:70:08",

"IPv4Address": "192.168.112.8/20",

"IPv6Address": ""

},

"7b01f5454832984fcd9650f05b4affce97319f661710705e6381dfb76cd99fdb": {

"Name": "ca_orderer",

"EndpointID": "057390288a424f49d6e9d6f788049b1e18aa28bccd56d860b2be8ceb8173ef74",

"MacAddress": "02:42:c0:a8:70:02",

"IPv4Address": "192.168.112.2/20",

"IPv6Address": ""

},

"7eb5f64bfe5f20701aae8a6660815c4e3a81c3834b71f9e59a62fb99bed1afc7": {

"Name": "couchdb0",

"EndpointID": "bfe740be15ec9dab7baf3806964e6b1f0b67032ce1b7ae26ac7844a1b422ddc4",

"MacAddress": "02:42:c0:a8:70:07",

"IPv4Address": "192.168.112.7/20",

"IPv6Address": ""

},

"87aef6062f2324889074cda80fec8fe014d844e10085827f380a91eea4ccdd74": {

"Name": "ca_org1",

"EndpointID": "a740090d33ca94dd7c6aaf14a79e1cb35109b549ee291c80195beccc901b16b7",

"MacAddress": "02:42:c0:a8:70:03",

"IPv4Address": "192.168.112.3/20",

"IPv6Address": ""

},

"a86f50ca19079f59552e8674932edd02f7f9af93ded14db3b4c404fd6b1abe9c": {

"Name": "peer0.org2.example.com",

"EndpointID": "6e56772b4783b1879a06f86901786fed1c307966b72475ce4631405ba8bca79a",

"MacAddress": "02:42:c0:a8:70:09",

"IPv4Address": "192.168.112.9/20",

"IPv6Address": ""

}

},

"Options": {},

"Labels": {}

}

]

|

看看这八个容器如何在作为单个 Docker 网络一部分的同时使用不同的 IP 地址。(为了清晰起见,我们对输出进行了缩写。)

由于我们是以DigiBank和MagnetoCorp的身份来操作测试网络的, peer0.org1.example.com将属于DigiBank组织, 而peer0.org2.example.com将由MagnetoCorp操作。 现在测试网络已经启动并运行, 从现在开始我们可以将我们的网络称为PaperNet。

回顾一下: 您已经从 GitHub 下载了 Hyperledger Fabric 示例仓库,并且已经在本地机器上运行了基本的网络。现在让我们开始扮演 MagnetoCorp 的角色来交易商业票据。

以MagentoCorp身份管理网络

商业票据教程允许您通过为DigiBank和MagnetoCorp 提供两个单独的文件夹来充当两个组织。 这两个文件夹包含每个组织的智能合约和客户端应用程序文件。 由于这两个组织在商业票据交易中有不同的角色, 所以每个组织的应用程序文件也不同。 在fabric-samples仓库下打开一个新窗口, 并使用以下命令切换到MagnetoCorp目录:

1

|

cd commercial-paper/organization/magnetocorp

|

我们要做的第一件事就是以 MagnetoCorp 的角色监控 PaperNet 网络中的组件。管理员可以使用 logspout 工具 。该工具可以将不同输出流采集到一个地方,从而在一个窗口中就可以轻松看到正在发生的事情。比如,对于正在安装智能合约的管理员或者正在调用智能合约的开发人员来说,这个工具确实很有帮助。

在MagnetoCorp目录下,运行下列命令以运行monitordocker.sh脚本, 并为运行在fabric_test上的与PaperNet相关联的容器 启动logspout工具:

1

2

3

4

5

6

7

8

|

(magnetocorp admin)$ ./configuration/cli/monitordocker.sh fabric_test

...

latest: Pulling from gliderlabs/logspout

4fe2ade4980c: Pull complete

decca452f519: Pull complete

(...)

Starting monitoring on all containers on the network fabric_test

b7f3586e5d0233de5a454df369b8eadab0613886fc9877529587345fc01a3582

|

注意,如果 monitordocker.sh 中的默认端口已经在使用,您可以传入一个端口号。

1

|

(magnetocorp admin)$ ./monitordocker.sh fabric_test <port_number>

|

现在,这个窗口将为本教程剩余部分显示Docker容器的日志输出, 那么继续并打开另一个命令窗口。 我们要做的下一件事是 检查MagnetoCorp将用于发行商业票据的智能合约。

检查商业票据智能合约

issue, buy 和 redeem 是 PaperNet 智能合约的三个核心功能。应用程序使用这些功能来提交交易,相应地,在账本上会发行、购买和赎回商业票据。我们接下来的任务就是检查这个智能合约。

打开一个新的终端窗口来代表 MagnetoCorp 开发人员。

1

|

cd commercial-paper/organization/magnetocorp

|

然后,您可以使用您选择的编辑器(本教程中的VS Code) 在contract目录中查看智能合约:

1

|

(magnetocorp developer)$ code contract

|

在这个文件夹的 lib 目录下,您将看到 papercontract.js 文件,其中包含了商业票据智能合约!

一个示例代码编辑器在

一个示例代码编辑器在 papercontract.js 文件中展示商业票据智能合约

papercontract.js 是一个在 Node.js 环境中运行的 JavaScript 程序。注意下面的关键程序行:

-

const { Contract, Context } = require('fabric-contract-api');

这个语句引入了两个关键的 Hyperledger Fabric 类:Contract 和 Context,它们被智能合约广泛使用。您可以在 fabric-shim JSDOCS 中了解到这些类的更多信息。

-

class CommercialPaperContract extends Contract {

这里基于内置的 Fabric Contract 类定义了智能合约类 CommercialPaperContract 。实现了 issue, buy 和 redeem 商业票据关键交易的方法被定义在该类中。

-

async issue(ctx, issuer, paperNumber, issueDateTime, maturityDateTime...) {

这个方法为 PaperNet 定义了商业票据 issue 交易。传入的参数用于创建新的商业票据。

找到并检查智能合约内的 buy 和 redeem 交易。

-

let paper = CommercialPaper.createInstance(issuer, paperNumber, issueDateTime...);

在 issue 交易内部,这个语句根据提供的交易输入使用 CommercialPaper 类在内存中创建了一个新的商业票据。检查 buy 和 redeem 交易看如何类似地使用该类。

-

await ctx.paperList.addPaper(paper);

这个语句使用 ctx.paperList **在账本上添加了新的商业票据,**其中 ctx.paperList 是PaperList 类的一个实例,当智能合约上下文 CommercialPaperContext 被初始化时,就会创建出一个 ctx.paperList。再次检查 buy 和 redeem 方法,以了解这些方法是如何使用这一类的。

-

return paper;

该语句返回一个二进制缓冲区,作为来自 issue 交易的响应,供智能合约的调用者处理。

欢迎检查 contract 目录下的其他文件来理解智能合约是如何工作的,请仔细阅读智能合约处理主题中 papercontract.js 是如何设计的。

将智能合约部署到通道

在应用程序调用papercontract之前, 必须将它安装到测试网络中合适的peer节点上, 然后在通道上使用 Fabric链码生命周期定义它。 Fabric链码生命周期允许多个组织在链码被部署到通道之前同意链码的参数。 因此,我们需要以MagnetoCorp和DigiBank的管理员的身份来安装和审批同意链码。

MagnetoCorp 的管理员将

MagnetoCorp 的管理员将 papercontract 的一个副本安装在 MagnetoCorp 的节点上。

智能合约是应用开发的重点,它被包含在一个名为链码的 Hyperledger Fabric 构件中。在一个链码中可以定义一个或多个智能合约,安装链码就使得 PaperNet 中的不同组织可以使用其中的智能合约。这意味着只有管理员需要关注链码;其他人都只需关注智能合约。

以MagentoCorp身份安装和批准智能合约

我们将首先以MagnetoCorp管理员的身份安装并同意智能合约。 确保您正在magnetocorp文件夹里操作, 或使用以下命令浏览至该文件夹:

1

|

cd commercial-paper/organization/magnetocorp

|

MagnetoCorp管理员可以通过使用peerCLI与PaperNet交互。 然而,管理员需要在其命令窗口中设置某些环境变量, 以使用正确的peer二进制文件集, 向MagnetoCorp的peer节点的地址发送命令和使用正确的加密资料对请求进行签名。

您可以使用示例提供的脚本在命令窗口中设置环境变量。 在magnetocorp目录中执行如下命令:

您将在窗口中看到被打印出来的环境变量的完整列表。 我们现在可以使用这个命令窗口来以 MagnetoCorp管理员的身份与PaperNet交互。

第一步是安装papercontract智能合约。 可以使用peer lifecycle chaincode package命令将智能合约打包成链码。 在MagnetoCorp管理员的命令窗口中, 执行如下命令创建链码包:

1

|

(magnetocorp admin)$ peer lifecycle chaincode package cp.tar.gz --lang node --path ./contract --label cp_0

|

MagnetoCorp管理员现在可以使用peer lifecycle chaincode install命令 在MagnetoCorp的peer节点上安装链码:

1

|

(magnetocorp admin)$ peer lifecycle chaincode install cp.tar.gz

|

在安装了链码包后, 您会在您的终端上看到类似如下的消息:

1

2

|

2020-01-30 18:32:33.762 EST [cli.lifecycle.chaincode] submitInstallProposal -> INFO 001 Installed remotely: response:<status:200 payload:"\nEcp_0:ffda93e26b183e231b7e9d5051e1ee7ca47fbf24f00a8376ec54120b1a2a335c\022\004cp_0" >

2020-01-30 18:32:33.762 EST [cli.lifecycle.chaincode] submitInstallProposal -> INFO 002 Chaincode code package identifier: cp_0:ffda93e26b183e231b7e9d5051e1ee7ca47fbf24f00a8376ec54120b1a2a335c

|

因为MagnetoCorp管理员已经设置了CORE_PEER_ADDRESS=localhost:9051 来将peer0.org2.example.com作为指令的目标, 所以INFO 001 Installed remotely...表示 papercontract已被成功安装在此peer节点上。

在安装智能合约之后,我们需要以MagnetoCorp的管理员身份 同意papercontract的链码定义。 第一步是找到我们安装在我们的peer上的链码的packageID。 我们可以使用peer lifecycle chaincode queryinstalled 命令查询packageID:

1

|

peer lifecycle chaincode queryinstalled

|

该命令将返回与安装命令相同的包标识符。 您应该会看到类似如下的输出:

1

2

|

Installed chaincodes on peer:

Package ID: cp_0:ffda93e26b183e231b7e9d5051e1ee7ca47fbf24f00a8376ec54120b1a2a335c, Label: cp_0

|

在下一步中,我们将需要package ID, 因此我们将其保存为一个环境变量。 对于所有用户,package ID可能不相同, 因此您需要使用从命令窗口返回的package ID来完成这个步骤。

1

|

export PACKAGE_ID=cp_0:ffda93e26b183e231b7e9d5051e1ee7ca47fbf24f00a8376ec54120b1a2a335c

|

管理员现在可以使用peer lifecycle chaincode approveformyorg命令 为MagnetoCorp组织同意链码定义:

1

|

(magnetocorp admin)$ peer lifecycle chaincode approveformyorg --orderer localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name papercontract -v 0 --package-id $PACKAGE_ID --sequence 1 --tls --cafile $ORDERER_CA

|

为了使用链码定义,通道成员需要同意的最重要的链码参数之一 是链码背书策略。 背书策略描述了在确定交易有效之前必须背书(执行和签署)的组织集合。 通过不指定--policy标志而同意papercontract链码, MagnetoCorp管理员将同意使用通道的默认Endorsement策略, 这在mychannel测试通道的实例下 要求通道上的大多数组织来背书交易。 所有的交易,无论有效还是无效,都将被记录在 区块链账本上, 但只有有效的交易才会更新世界状态。

以DigiBank身份安装和批准智能合约

基于mychannel的LifecycleEndorsement策略, Fabric链码生命周期将要求通道上的大多数组织在将链码提交到通道之前同意链码的定义。 这意味着我们需要以MagnetoCorp和DigiBank的身份同意papernet链码, 以达成所需的多数即2/2的要求。 在fabric-samples文件夹下打开一个新的终端窗口, 并浏览到包含DigiBank智能合约和应用程序文件的文件夹:

1

|

(digibank admin)$ cd commercial-paper/organization/digibank/

|

使用DigiBank文件夹中的脚本设置环境变量, 这将允许您作为DigiBank管理员操作:

我们现在可以以DigiBank的管理员身份安装和同意papercontract。 执行如下命令打包链码:

1

|

(digibank admin)$ peer lifecycle chaincode package cp.tar.gz --lang node --path ./contract --label cp_0

|

管理员现在可以在DigiBank的peer节点上安装链码:

1

|

(digibank admin)$ peer lifecycle chaincode install cp.tar.gz

|

然后我们需要查询并保存刚刚安装的 链码的packageID:

1

|

(digibank admin)$ peer lifecycle chaincode queryinstalled

|

将package ID保存为环境变量。 使用从控制台返回的package ID完成此步骤。

1

|

export PACKAGE_ID=cp_0:ffda93e26b183e231b7e9d5051e1ee7ca47fbf24f00a8376ec54120b1a2a335c

|

Digibank管理员现在可以同意papercontract的链码定义:

1

|

(digibank admin)$ peer lifecycle chaincode approveformyorg --orderer localhost:7050 --ordererTLSHostnameOverride orderer.example.com --channelID mychannel --name papercontract -v 0 --package-id $PACKAGE_ID --sequence 1 --tls --cafile $ORDERER_CA

|

将链码定义提交到通道

现在,DigiBank和MagnetoCorp都同意了papernet链码, 我们有了我们需要的大多数(2/2)组织的条件来提交链码定义到通道。 一旦在通道上成功定义了链码, 通道上的客户端应用程序就可以调用 papercontract链码中的CommercialPaper智能合约。 由于任何一个机构都可以提交链码到通道, 我们将继续以DigiBank管理员的身份操作:

在DigiBank管理员将

在DigiBank管理员将papercontract链码的定义提交到通道后,将创建一个新的Docker链码容器,以便在PaperNet的两个peer节点上运行papercontract

DigiBank管理员使用peer lifecycle chaincode commit命令 将papercontract的链码定义提交到mychannel:

1

|

(digibank admin)$ peer lifecycle chaincode commit -o localhost:7050 --ordererTLSHostnameOverride orderer.example.com --peerAddresses localhost:7051 --tlsRootCertFiles ${PEER0_ORG1_CA} --peerAddresses localhost:9051 --tlsRootCertFiles ${PEER0_ORG2_CA} --channelID mychannel --name papercontract -v 0 --sequence 1 --tls --cafile $ORDERER_CA --waitForEvent

|

链码容器将在链码定义提交到通道后启动。 您可以使用docker ps命令在两个peer节点上 看到papercontract容器的启动。

1

2

3

4

5

|

(digibank admin)$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

d4ba9dc9c55f dev-peer0.org1.example.com-cp_0-ebef35e7f1f25eea1dcc6fcad5019477cd7f434c6a5dcaf4e81744e282903535-05cf67c20543ee1c24cf7dfe74abce99785374db15b3bc1de2da372700c25608 "docker-entrypoint.s…" 30 seconds ago Up 28 seconds dev-peer0.org1.example.com-cp_0-ebef35e7f1f25eea1dcc6fcad5019477cd7f434c6a5dcaf4e81744e282903535

a944c0f8b6d6 dev-peer0.org2.example.com-cp_0-1487670371e56d107b5e980ce7f66172c89251ab21d484c7f988c02912ddeaec-1a147b6fd2a8bd2ae12db824fad8d08a811c30cc70bc5b6bc49a2cbebc2e71ee "docker-entrypoint.s…" 31 seconds ago Up 28 seconds dev-peer0.org2.example.com-cp_0-1487670371e56d107b5e980ce7f66172c89251ab21d484c7f988c02912ddeaec

|

注意,容器的命名指出了启动它的peer节点, 以及它正在运行**papercontract版本**的实际情况。

现在我们已经将papercontract链代码部署到通道, 我们可以使用MagnetoCorp应用程序来发行商业票据。 让我们花点时间检查一下应用程序的结构。

应用结构

包含在 papercontract 中的智能合约由 MagnetoCorp 的应用程序 issue.js 调用。Isabella 使用该程序向发行商业票据 00001 的账本提交一项交易。让我么来快速检验一下 issue 应用是怎么工作的。

gateway允许应用程序专注于交易的生成、提交和响应。它协调不同网络组件之间的交易提案、排序和通知处理。

gateway允许应用程序专注于交易的生成、提交和响应。它协调不同网络组件之间的交易提案、排序和通知处理。