PGM-Explainer建立了一个概率图模型,为GNN提供实例级解释。

-

论文标题:PGM-Explainer: Probabilistic Graphical Model Explanations for Graph Neural Networks

PGM-Explainer实验

实验目的

研究PGM-Explainer的有效性

实验方案

合成数据集的节点分类

与其他解释器做对比实验

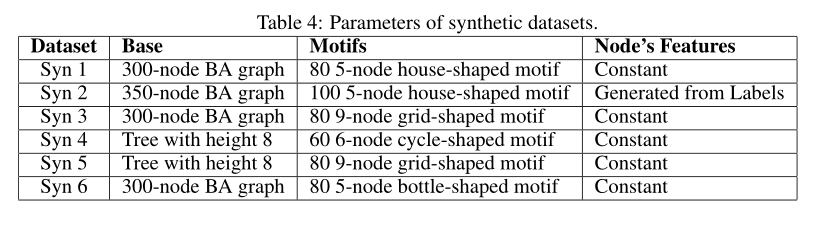

使用六个合成数据集。

每个输入图都是一个基础图和一组 motifs 的组合。

ground-truth:与被预测节点处于同一 motif 中的节点。

由于ground-truth的解释是清楚的,我们使用准确度作为评估标准

真实数据集的节点分类

与其他解释器做对比实验

使用比特币账户数据集。

解释中未对目标进行评级或对目标进行负面评级的任何帐户都将被视为\“错误帐户\”。

我们基于精度而不是准确性来评估解释,解释的精确度是通过将\“没有错误的帐户\”除以该解释中的帐户总数来计算的。

真实数据集的图分类

与其他解释器做对比实验

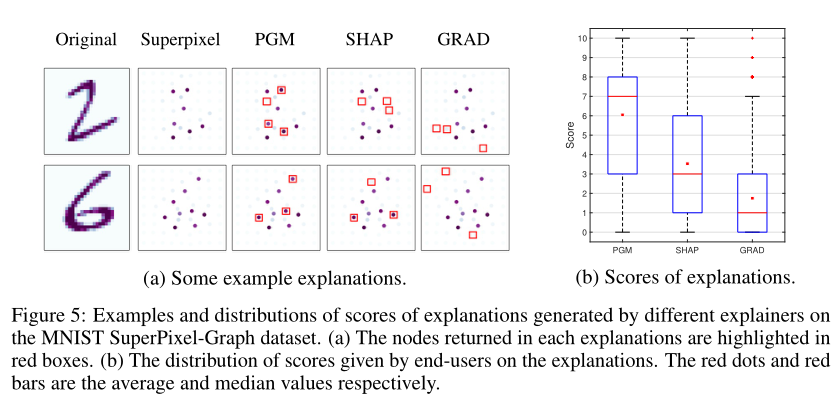

使用MNIST SuperPixel-Graph数据集。

在这个数据集中,原始的MNIST图像被转换成使用超像素的图形,超像素代表图像中均匀强度的小区域。在给定的图形中,每个节点代表原始图像中的一个超像素,而节点的特征是超像素的强度和位置。

我们随机选择了48个GNN预测正确的图表。然后使用PGM-Explainer、Shap和Grad生成相应的解释。

由于本实验无法获得基本事实的解释,因此我们采用人的主观测试来评估解释的结果。

实验结果

在合成数据集上,PGM-Explainer的性能优于其他解释方法

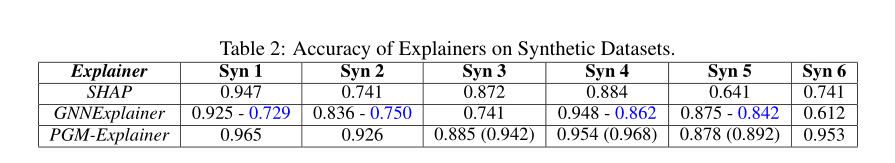

表2显示了不同解释器对合成数据集的解释准确性

可以看出,PGM-Explainer的性能优于其他解释方法,特别是在数据集2和6上。

在真实数据集上,PGM-Explainer的性能明显优于其他解释方法

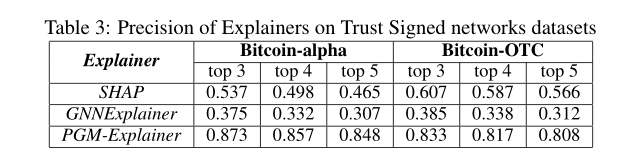

表3显示了不同解释器对真实数据集的解释精度

可以看出,PGM-Explainer的性能明显优于其他解释方法。

(a)每个解释中返回的节点以红色方框突出显示。(b)最终用户对解释的评分分布情况。红点和红条分别是平均值和中值。

从图5(b)中分数的分布来看,PGM-Explainer的解释被评价得比其他方法高得多。这意味着PGM-Explainer生成的解释中的节点更直观,对GNN的预测可能比其他解释方法更重要

数据集

合成数据集

真实数据集

-

比特币账户数据集(Trust weighted signed networks Bitcoin-Alpha and Bitcoin-OTC datasets)

以上数据集由3783个账户和5881个账户组成的网络,分别在名为Bitcoin-Alpha和Bitcoin-OTC的平台上交易比特币。在每个网络中,成员对其他成员的评分为-10(总不信任)到+10(总信任)。根据这些评分给每个账户贴上值得信任或不值得信任的标签。

ground-truth:没有对目标节点进行评价或对目标进行负面评价的账户都被算作 “错误账户”。

-

MNIST SuperPixel-Graph数据集

其每个样本是对应于手写数字MNIST数据集中的图像样本的图。

总结

本实验在六个合成数据集和两个真实数据集上证明了PGM-Explainer的有效性。

2021.8.23 by YI