本文转载自:极客兔兔

Web框架 - Gee

大部分时候,我们需要实现一个 Web 应用,第一反应是应该使用哪个框架。不同的框架设计理念和提供的功能有很大的差别。比如 Python 语言的 django和flask,前者大而全,后者小而美。Go语言/golang 也是如此,新框架层出不穷,比如Beego,Gin,Iris等。那为什么不直接使用标准库,而必须使用框架呢?在设计一个框架之前,我们需要回答框架核心为我们解决了什么问题。只有理解了这一点,才能想明白我们需要在框架中实现什么功能。

我们先看看标准库net/http如何处理一个请求。

1

2

3

4

5

6

7

8

9

|

func main() {

http.HandleFunc("/", handler)

http.HandleFunc("/count", counter)

log.Fatal(http.ListenAndServe("localhost:8000", nil))

}

func handler(w http.ResponseWriter, r *http.Request) {

fmt.Fprintf(w, "URL.Path = %q\n", r.URL.Path)

}

|

net/http提供了基础的Web功能,即监听端口,映射静态路由,解析HTTP报文。一些Web开发中简单的需求并不支持,需要手工实现。

- 动态路由:例如

hello/:name,hello/*这类的规则。

- 鉴权:没有分组/统一鉴权的能力,需要在每个路由映射的handler中实现。

- 模板:没有统一简化的HTML机制。

- …

当我们离开框架,使用基础库时,需要频繁手工处理的地方,就是框架的价值所在。但并不是每一个频繁处理的地方都适合在框架中完成。Python有一个很著名的Web框架,名叫bottle,整个框架由bottle.py一个文件构成,共4400行,可以说是一个微框架。那么理解这个微框架提供的特性,可以帮助我们理解框架的核心能力。

- 路由(Routing):将请求映射到函数,支持动态路由。例如

'/hello/:name。

- 模板(Templates):使用内置模板引擎提供模板渲染机制。

- 工具集(Utilites):提供对 cookies,headers 等处理机制。

- 插件(Plugin):Bottle本身功能有限,但提供了插件机制。可以选择安装到全局,也可以只针对某几个路由生效。

- …

Gee 框架

这个教程将使用 Go 语言实现一个简单的 Web 框架,起名叫做Gee,geektutu.com的前三个字母。我第一次接触的 Go 语言的 Web 框架是Gin,Gin的代码总共是14K,其中测试代码9K,也就是说实际代码量只有5K。Gin也是我非常喜欢的一个框架,与Python中的Flask很像,小而美。

7天实现Gee框架这个教程的很多设计,包括源码,参考了Gin,大家可以看到很多Gin的影子。

时间关系,同时为了尽可能地简洁明了,这个框架中的很多部分实现的功能都很简单,但是尽可能地体现一个框架核心的设计原则。例如Router的设计,虽然支持的动态路由规则有限,但为了性能考虑匹配算法是用Trie树实现的,Router最重要的指标之一便是性能。

http.Handler

- 简单介绍

net/http库以及http.Handler接口。

- 搭建

Gee框架的雏形,代码约50行。

标准库启动Web服务

Go语言内置了 net/http库,封装了网络编程的基础接口,Gee框架是基于net/http的,接下来通过一个例子简单介绍net/http库的使用。

day1-http-base/base1/main.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

package main

import (

"fmt"

"log"

"net/http"

)

func main() {

http.HandleFunc("/", indexHandler)

http.HandleFunc("/hello", helloHandler)

log.Fatal(http.ListenAndServe(":9999", nil))

}

// handler echoes r.URL.Path

func indexHandler(w http.ResponseWriter, req *http.Request) {

fmt.Fprintf(w, "URL.Path = %q\n", req.URL.Path)

}

// handler echoes r.URL.Header

func helloHandler(w http.ResponseWriter, req *http.Request) {

for k, v := range req.Header {

fmt.Fprintf(w, "Header[%q] = %q\n", k, v)

}

}

|

我们设置了2个路由,/和/hello,分别绑定 indexHandler 和 helloHandler ,根据不同的HTTP请求会调用不同的处理函数。

- 访问

/,响应是URL.Path = /

- 访问

/hello,响应是请求头(header)中的键值对信息。

用 curl 这个工具测试一下,将会得到如下的结果。

1

2

3

4

5

|

$ curl http://localhost:9999/

URL.Path = "/"

$ curl http://localhost:9999/hello

Header["Accept"] = ["*/*"]

Header["User-Agent"] = ["curl/7.54.0"]

|

main 函数的最后一行,是用来启动 Web 服务的,第一个参数是地址,:9999表示在 9999 端口监听。而第二个参数则代表处理所有的HTTP请求的实例,nil 代表使用标准库中的实例处理。第二个参数,则是我们基于net/http标准库实现Web框架的入口。

实现http.Handler接口

1

2

3

4

5

6

7

|

package http

type Handler interface {

ServeHTTP(w ResponseWriter, r *Request)

}

func ListenAndServe(address string, h Handler) error

|

第二个参数的类型是什么呢?通过查看net/http的源码可以发现,Handler是一个接口,需要实现方法 ServeHTTP ,也就是说,只要传入任何实现了 ServerHTTP 接口的实例,所有的HTTP请求,就都交给了该实例处理了。马上来试一试吧。

day1-http-base/base2/main.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

package main

import (

"fmt"

"log"

"net/http"

)

// Engine is the uni handler for all requests

type Engine struct{}

func (engine *Engine) ServeHTTP(w http.ResponseWriter, req *http.Request) {

switch req.URL.Path {

case "/":

fmt.Fprintf(w, "URL.Path = %q\n", req.URL.Path)

case "/hello":

for k, v := range req.Header {

fmt.Fprintf(w, "Header[%q] = %q\n", k, v)

}

default:

fmt.Fprintf(w, "404 NOT FOUND: %s\n", req.URL)

}

}

func main() {

engine := new(Engine)

log.Fatal(http.ListenAndServe(":9999", engine))

}

|

- 我们定义了一个空的结构体

Engine,实现了方法ServeHTTP。这个方法有2个参数,第二个参数是 Request ,该对象包含了该HTTP请求的所有的信息,比如请求地址、Header和Body等信息;第一个参数是 ResponseWriter ,利用 ResponseWriter 可以构造针对该请求的响应。

- 在 main 函数中,我们给 ListenAndServe 方法的第二个参数传入了刚才创建的

engine实例。至此,我们走出了实现Web框架的第一步,即,将所有的HTTP请求转向了我们自己的处理逻辑。还记得吗,在实现Engine之前,我们调用 http.HandleFunc 实现了路由和Handler的映射,也就是只能针对具体的路由写处理逻辑。比如/hello。但是在实现Engine之后,我们拦截了所有的HTTP请求,拥有了统一的控制入口。在这里我们可以自由定义路由映射的规则,也可以统一添加一些处理逻辑,例如日志、异常处理等。

- 代码的运行结果与之前的是一致的。

Gee框架的雏形

我们接下来重新组织上面的代码,搭建出整个框架的雏形。

最终的代码目录结构是这样的。

1

2

3

4

5

|

gee/

|--gee.go

|--go.mod

main.go

go.mod

|

go.mod

day1-http-base/base3/go.mod

1

2

3

4

5

6

7

|

module example

go 1.13

require gee v0.0.0

replace gee => ./gee

|

- 在

go.mod 中使用 replace 将 gee 指向 ./gee

从 go 1.11 版本开始,引用相对路径的 package 需要使用上述方式。

main.go

day1-http-base/base3/main.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

package main

import (

"fmt"

"net/http"

"gee"

)

func main() {

r := gee.New()

r.GET("/", func(w http.ResponseWriter, req *http.Request) {

fmt.Fprintf(w, "URL.Path = %q\n", req.URL.Path)

})

r.GET("/hello", func(w http.ResponseWriter, req *http.Request) {

for k, v := range req.Header {

fmt.Fprintf(w, "Header[%q] = %q\n", k, v)

}

})

r.Run(":9999")

}

|

看到这里,如果你使用过gin框架的话,肯定会觉得无比的亲切。gee框架的设计以及API均参考了gin。使用New()创建 gee 的实例,使用 GET()方法添加路由,最后使用Run()启动Web服务。这里的路由,只是静态路由,不支持/hello/:name这样的动态路由,动态路由我们将在下一次实现。

gee.go

day1-http-base/base3/gee/gee.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

|

package gee

import (

"fmt"

"net/http"

)

// HandlerFunc defines the request handler used by gee

type HandlerFunc func(http.ResponseWriter, *http.Request)

// Engine implement the interface of ServeHTTP

type Engine struct {

router map[string]HandlerFunc

}

// New is the constructor of gee.Engine

func New() *Engine {

return &Engine{router: make(map[string]HandlerFunc)}

}

func (engine *Engine) addRoute(method string, pattern string, handler HandlerFunc) {

key := method + "-" + pattern

engine.router[key] = handler

}

// GET defines the method to add GET request

func (engine *Engine) GET(pattern string, handler HandlerFunc) {

engine.addRoute("GET", pattern, handler)

}

// POST defines the method to add POST request

func (engine *Engine) POST(pattern string, handler HandlerFunc) {

engine.addRoute("POST", pattern, handler)

}

// Run defines the method to start a http server

func (engine *Engine) Run(addr string) (err error) {

return http.ListenAndServe(addr, engine)

}

func (engine *Engine) ServeHTTP(w http.ResponseWriter, req *http.Request) {

key := req.Method + "-" + req.URL.Path

if handler, ok := engine.router[key]; ok {

handler(w, req)

} else {

fmt.Fprintf(w, "404 NOT FOUND: %s\n", req.URL)

}

}

|

那么gee.go就是重头戏了。我们重点介绍一下这部分的实现。

- 首先定义了类型

HandlerFunc,这是提供给框架用户的,用来定义路由映射的处理方法。我们在Engine中,添加了一张路由映射表router,key 由请求方法和静态路由地址构成,例如GET-/、GET-/hello、POST-/hello,这样针对相同的路由,如果请求方法不同,可以映射不同的处理方法(Handler),value 是用户映射的处理方法。

- 当用户调用

(*Engine).GET()方法时,会将路由和处理方法注册到映射表 router 中,(*Engine).Run()方法,是 ListenAndServe 的包装。

Engine实现的 ServeHTTP 方法的作用就是,解析请求的路径,查找路由映射表,如果查到,就执行注册的处理方法。如果查不到,就返回 404 NOT FOUND 。

执行go run main.go,再用 curl 工具访问,结果与最开始的一致。

1

2

3

4

5

6

7

|

$ curl http://localhost:9999/

URL.Path = "/"

$ curl http://localhost:9999/hello

Header["Accept"] = ["*/*"]

Header["User-Agent"] = ["curl/7.54.0"]

curl http://localhost:9999/world

404 NOT FOUND: /world

|

至此,整个Gee框架的原型已经出来了。实现了路由映射表,提供了用户注册静态路由的方法,包装了启动服务的函数。当然,到目前为止,我们还没有实现比net/http标准库更强大的能力,不用担心,很快就可以将动态路由、中间件等功能添加上去了。

上下文Context

- 将

路由(router)独立出来,方便之后增强。

- 设计

上下文(Context),封装 Request 和 Response ,提供对 JSON、HTML 等返回类型的支持。

- 动手写 Gee 框架的第二天,框架代码140行,新增代码约90行

使用效果

为了展示第二天的成果,我们先来看一看实际使用时的效果。

day2-context/main.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

func main() {

r := gee.New()

r.GET("/", func(c *gee.Context) {

c.HTML(http.StatusOK, "<h1>Hello Gee</h1>")

})

r.GET("/hello", func(c *gee.Context) {

// expect /hello?name=geektutu

c.String(http.StatusOK, "hello %s, you're at %s\n", c.Query("name"), c.Path)

})

r.POST("/login", func(c *gee.Context) {

c.JSON(http.StatusOK, gee.H{

"username": c.PostForm("username"),

"password": c.PostForm("password"),

})

})

r.Run(":9999")

}

|

Handler的参数变成成了gee.Context,提供了查询Query/PostForm参数的功能。gee.Context封装了HTML/String/JSON函数,能够快速构造HTTP响应。

设计Context

必要性

- 对Web服务来说,无非是根据请求

*http.Request,构造响应http.ResponseWriter。但是这两个对象提供的接口粒度太细,比如我们要构造一个完整的响应,需要考虑消息头(Header)和消息体(Body),而 Header 包含了状态码(StatusCode),消息类型(ContentType)等几乎每次请求都需要设置的信息。因此,如果不进行有效的封装,那么框架的用户将需要写大量重复,繁杂的代码,而且容易出错。针对常用场景,能够高效地构造出 HTTP 响应是一个好的框架必须考虑的点。

用返回 JSON 数据作比较,感受下封装前后的差距。

封装前

1

2

3

4

5

6

7

8

9

10

|

obj = map[string]interface{}{

"name": "geektutu",

"password": "1234",

}

w.Header().Set("Content-Type", "application/json")

w.WriteHeader(http.StatusOK)

encoder := json.NewEncoder(w)

if err := encoder.Encode(obj); err != nil {

http.Error(w, err.Error(), 500)

}

|

VS 封装后:

1

2

3

4

|

c.JSON(http.StatusOK, gee.H{

"username": c.PostForm("username"),

"password": c.PostForm("password"),

})

|

- 针对使用场景,封装

*http.Request和http.ResponseWriter的方法,简化相关接口的调用,只是设计 Context 的原因之一。对于框架来说,还需要支撑额外的功能。例如,将来解析动态路由/hello/:name,参数:name的值放在哪呢?再比如,框架需要支持中间件,那中间件产生的信息放在哪呢?Context 随着每一个请求的出现而产生,请求的结束而销毁,和当前请求强相关的信息都应由 Context 承载。因此,设计 Context 结构,扩展性和复杂性留在了内部,而对外简化了接口。路由的处理函数,以及将要实现的中间件,参数都统一使用 Context 实例, Context 就像一次会话的百宝箱,可以找到任何东西。

具体实现

day2-context/gee/context.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

|

type H map[string]interface{}

type Context struct {

// origin objects

Writer http.ResponseWriter

Req *http.Request

// request info

Path string

Method string

// response info

StatusCode int

}

func newContext(w http.ResponseWriter, req *http.Request) *Context {

return &Context{

Writer: w,

Req: req,

Path: req.URL.Path,

Method: req.Method,

}

}

func (c *Context) PostForm(key string) string {

return c.Req.FormValue(key)

}

func (c *Context) Query(key string) string {

return c.Req.URL.Query().Get(key)

}

func (c *Context) Status(code int) {

c.StatusCode = code

c.Writer.WriteHeader(code)

}

func (c *Context) SetHeader(key string, value string) {

c.Writer.Header().Set(key, value)

}

func (c *Context) String(code int, format string, values ...interface{}) {

c.SetHeader("Content-Type", "text/plain")

c.Status(code)

c.Writer.Write([]byte(fmt.Sprintf(format, values...)))

}

func (c *Context) JSON(code int, obj interface{}) {

c.SetHeader("Content-Type", "application/json")

c.Status(code)

encoder := json.NewEncoder(c.Writer)

if err := encoder.Encode(obj); err != nil {

http.Error(c.Writer, err.Error(), 500)

}

}

func (c *Context) Data(code int, data []byte) {

c.Status(code)

c.Writer.Write(data)

}

func (c *Context) HTML(code int, html string) {

c.SetHeader("Content-Type", "text/html")

c.Status(code)

c.Writer.Write([]byte(html))

}

|

- 代码最开头,给

map[string]interface{}起了一个别名gee.H,构建JSON数据时,显得更简洁。

Context目前只包含了http.ResponseWriter和*http.Request,另外提供了对 Method 和 Path 这两个常用属性的直接访问。- 提供了访问

Query和PostForm参数的方法。

- 提供了快速构造

String/Data/JSON/HTML响应的方法。

路由(Router)

我们将和路由相关的方法和结构提取了出来,放到了一个新的文件中router.go,方便我们下一次对 router 的功能进行增强,例如提供动态路由的支持。 router 的 handle 方法作了一个细微的调整,即 handler 的参数,变成了 Context。

day2-context/gee/router.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

type router struct {

handlers map[string]HandlerFunc

}

func newRouter() *router {

return &router{handlers: make(map[string]HandlerFunc)}

}

func (r *router) addRoute(method string, pattern string, handler HandlerFunc) {

log.Printf("Route %4s - %s", method, pattern)

key := method + "-" + pattern

r.handlers[key] = handler

}

func (r *router) handle(c *Context) {

key := c.Method + "-" + c.Path

if handler, ok := r.handlers[key]; ok {

handler(c)

} else {

c.String(http.StatusNotFound, "404 NOT FOUND: %s\n", c.Path)

}

}

|

框架入口

day2-context/gee/gee.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

|

// HandlerFunc defines the request handler used by gee

type HandlerFunc func(*Context)

// Engine implement the interface of ServeHTTP

type Engine struct {

router *router

}

// New is the constructor of gee.Engine

func New() *Engine {

return &Engine{router: newRouter()}

}

func (engine *Engine) addRoute(method string, pattern string, handler HandlerFunc) {

engine.router.addRoute(method, pattern, handler)

}

// GET defines the method to add GET request

func (engine *Engine) GET(pattern string, handler HandlerFunc) {

engine.addRoute("GET", pattern, handler)

}

// POST defines the method to add POST request

func (engine *Engine) POST(pattern string, handler HandlerFunc) {

engine.addRoute("POST", pattern, handler)

}

// Run defines the method to start a http server

func (engine *Engine) Run(addr string) (err error) {

return http.ListenAndServe(addr, engine)

}

func (engine *Engine) ServeHTTP(w http.ResponseWriter, req *http.Request) {

c := newContext(w, req)

engine.router.handle(c)

}

|

将router相关的代码独立后,gee.go简单了不少。最重要的还是通过实现了 ServeHTTP 接口,接管了所有的 HTTP 请求。相比第一天的代码,这个方法也有细微的调整,在调用 router.handle 之前,构造了一个 Context 对象。这个对象目前还非常简单,仅仅是包装了原来的两个参数,之后我们会慢慢地给Context插上翅膀。

如何使用,main.go一开始就已经亮相了。运行go run main.go,借助 curl ,一起看一看今天的成果吧。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

$ curl -i http://localhost:9999/

HTTP/1.1 200 OK

Date: Mon, 12 Aug 2019 16:52:52 GMT

Content-Length: 18

Content-Type: text/html; charset=utf-8

<h1>Hello Gee</h1>

$ curl "http://localhost:9999/hello?name=geektutu"

hello geektutu, you're at /hello

$ curl "http://localhost:9999/login" -X POST -d 'username=geektutu&password=1234'

{"password":"1234","username":"geektutu"}

$ curl "http://localhost:9999/xxx"

404 NOT FOUND: /xxx

|

前缀树路由Router

- 使用 Trie 树实现动态路由(dynamic route)解析。

- 支持两种模式

:name和*filepath,代码约150行。

Trie 树简介

之前,我们用了一个非常简单的map结构存储了路由表,使用map存储键值对,索引非常高效,但是有一个弊端,键值对的存储的方式,只能用来索引静态路由。那如果我们想支持类似于/hello/:name这样的动态路由怎么办呢?所谓动态路由,即一条路由规则可以匹配某一类型而非某一条固定的路由。例如/hello/:name,可以匹配/hello/geektutu、hello/jack等。

动态路由有很多种实现方式,支持的规则、性能等有很大的差异。例如开源的路由实现gorouter支持在路由规则中嵌入正则表达式,例如/p/[0-9A-Za-z]+,即路径中的参数仅匹配数字和字母;另一个开源实现httprouter就不支持正则表达式。著名的Web开源框架gin 在早期的版本,并没有实现自己的路由,而是直接使用了httprouter,后来不知道什么原因,放弃了httprouter,自己实现了一个版本。

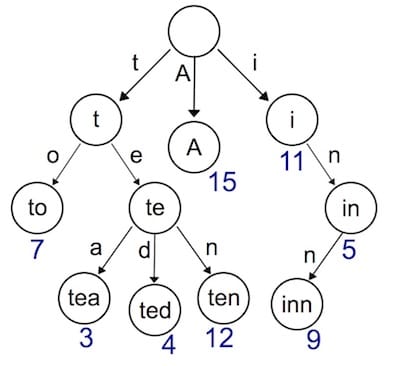

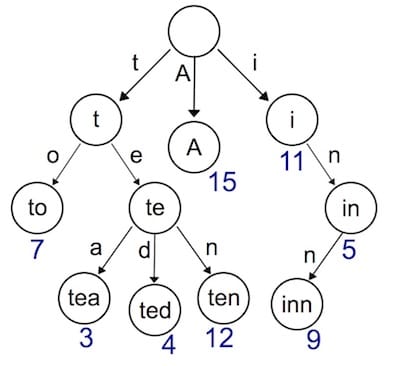

实现动态路由最常用的数据结构,被称为前缀树(Trie树)。看到名字你大概也能知道前缀树长啥样了:每一个节点的所有的子节点都拥有相同的前缀。这种结构非常适用于路由匹配,比如我们定义了如下路由规则:

- /:lang/doc

- /:lang/tutorial

- /:lang/intro

- /about

- /p/blog

- /p/related

我们用前缀树来表示,是这样的。

HTTP请求的路径恰好是由/分隔的多段构成的,因此,每一段可以作为前缀树的一个节点。我们通过树结构查询,如果中间某一层的节点都不满足条件,那么就说明没有匹配到的路由,查询结束。

接下来实现的动态路由具备以下两个功能。

- 参数匹配

:,例如 /p/:lang/doc,可以匹配 /p/c/doc 和 /p/go/doc。

- 通配

*,例如 /static/*filepath,可以匹配/static/fav.ico,也可以匹配/static/js/jQuery.js,这种模式常用于静态服务器,能够递归地匹配子路径。

Trie 树实现

首先需要设计树节点上应该存储的信息

day3-router/gee/trie.go

1

2

3

4

5

6

|

type node struct {

pattern string // 待匹配路由,例如 /p/:lang

part string // 路由中的一部分,例如 :lang

children []*node // 子节点,例如 [doc, tutorial, intro]

isWild bool // 是否精确匹配,part 含有 : 或 * 时为true (是否为通配)

}

|

与普通的树不同,为了实现动态路由匹配,加上了isWild这个参数。即当我们匹配 /p/go/doc/这个路由时,第一层节点,p精准匹配到了p,第二层节点,go模糊匹配到:lang,那么将会把lang这个参数赋值为go,继续下一层匹配。我们将匹配的逻辑,包装为一个辅助函数。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

// 第一个匹配成功的节点,用于插入 (在当前节点的子节点中查找第一个匹配成功的节点)

func (n *node) matchChild(part string) *node {

for _, child := range n.children {

if child.part == part || child.isWild {

return child

}

}

return nil

}

// 所有匹配成功的节点,用于查找 (返回所有匹配成功的子节点)

func (n *node) matchChildren(part string) []*node {

nodes := make([]*node, 0)

for _, child := range n.children {

if child.part == part || child.isWild {

nodes = append(nodes, child)

}

}

return nodes

}

|

对于路由来说,最重要的当然是注册与匹配了。开发服务时,注册路由规则,映射handler;访问时,匹配路由规则,查找到对应的handler。因此,Trie 树需要支持节点的插入与查询。插入功能很简单,递归查找每一层的节点,如果没有匹配到当前part的节点,则新建一个,有一点需要注意,/p/:lang/doc只有在第三层节点,即doc节点,pattern才会设置为/p/:lang/doc。p和:lang节点的pattern属性皆为空。因此,当匹配结束时,我们可以使用n.pattern == ""来判断路由规则是否匹配成功。例如,/p/python虽能成功匹配到:lang,但:lang的pattern值为空,因此匹配失败。查询功能,同样也是递归查询每一层的节点,退出规则是,匹配到了*,匹配失败,或者匹配到了第len(parts)层节点。

insert 方法用于向路由树中插入新的路由。它接受三个参数:待插入的路由字符串 pattern、路由字符串拆分后的部分数组 parts、以及当前处理的部分在数组中的索引 height。在方法中,首先检查当前处理的部分是否是最后一个部分,如果是,则将当前节点的 pattern 字段设置为待插入的路由字符串,并返回。如果不是最后一个部分,则从当前节点的子节点中查找是否存在与当前部分匹配的节点。如果不存在,则创建一个新的节点并将其加入当前节点的子节点列表中。然后递归调用 insert 方法,处理下一个部分。search 方法用于在路由树中搜索与给定路由匹配的节点。它接受两个参数:路由字符串拆分后的部分数组 parts、以及当前处理的部分在数组中的索引 height。在方法中,首先检查是否已经处理完所有部分,或者当前节点的 part 字段以 “*” 开头。如果是,则判断当前节点是否具有有效的路由字符串,如果有,则返回当前节点;否则返回 nil。如果尚未处理完所有部分,则从当前节点的子节点中查找与当前部分匹配的节点,并递归调用 search 方法。如果找到了匹配的节点,则返回该节点;否则继续搜索其他子节点。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

|

func (n *node) insert(pattern string, parts []string, height int) {

if len(parts) == height {

n.pattern = pattern

return

}

part := parts[height]

child := n.matchChild(part)

if child == nil {

child = &node{part: part, isWild: part[0] == ':' || part[0] == '*'}

n.children = append(n.children, child)

}

child.insert(pattern, parts, height+1)

}

func (n *node) search(parts []string, height int) *node {

if len(parts) == height || strings.HasPrefix(n.part, "*") {

if n.pattern == "" {

return nil

}

return n

}

part := parts[height]

children := n.matchChildren(part)

for _, child := range children {

result := child.search(parts, height+1)

if result != nil {

return result

}

}

return nil

}

|

Router

Trie 树的插入与查找都成功实现了,接下来我们将 Trie 树应用到路由中去。我们使用 roots 来存储每种请求方式的Trie 树根节点。使用 handlers 存储每种请求方式的 HandlerFunc 。getRoute 函数中,还解析了:和*两种匹配符的参数,返回一个 map 。例如/p/go/doc匹配到/p/:lang/doc,解析结果为:{lang: "go"},/static/css/geektutu.css匹配到/static/*filepath,解析结果为{filepath: "css/geektutu.css"}。

day3-router/gee/router.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

|

type router struct {

roots map[string]*node // 存储不同 HTTP 方法对应的路由树根节点

handlers map[string]HandlerFunc // 存储路由处理函数

}

// roots key eg, roots['GET'] roots['POST']

// handlers key eg, handlers['GET-/p/:lang/doc'], handlers['POST-/p/book']

// 创建路由器实例

func newRouter() *router {

return &router{

roots: make(map[string]*node),

handlers: make(map[string]HandlerFunc),

}

}

// Only one * is allowed

// 解析路由字符串,将其拆分成各个部分,返回一个部分数组

func parsePattern(pattern string) []string {

vs := strings.Split(pattern, "/")

parts := make([]string, 0)

for _, item := range vs {

if item != "" {

parts = append(parts, item)

if item[0] == '*' { // 遇到首字符为通配符

break

}

}

}

return parts

}

// 向路由器中添加路由

func (r *router) addRoute(method string, pattern string, handler HandlerFunc) {

parts := parsePattern(pattern)

key := method + "-" + pattern

_, ok := r.roots[method]

if !ok {

r.roots[method] = &node{}

}

r.roots[method].insert(pattern, parts, 0)

r.handlers[key] = handler

}

// 根据给定的 HTTP 方法和路径查找匹配的路由

func (r *router) getRoute(method string, path string) (*node, map[string]string) {

searchParts := parsePattern(path)

params := make(map[string]string)

root, ok := r.roots[method]

if !ok {

return nil, nil

}

n := root.search(searchParts, 0)

if n != nil {

parts := parsePattern(n.pattern)

for index, part := range parts {

if part[0] == ':' {

params[part[1:]] = searchParts[index]

}

if part[0] == '*' && len(part) > 1 {

params[part[1:]] = strings.Join(searchParts[index:], "/")

break

}

}

return n, params

}

return nil, nil

}

|

Context与handle的变化

在 HandlerFunc 中,希望能够访问到解析的参数,因此,需要对 Context 对象增加一个属性和方法,来提供对路由参数的访问。我们将解析后的参数存储到Params中,通过c.Param("lang")的方式获取到对应的值。

day3-router/gee/context.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

type Context struct {

// origin objects

Writer http.ResponseWriter

Req *http.Request

// request info

Path string

Method string

Params map[string]string

// response info

StatusCode int

}

func (c *Context) Param(key string) string {

value, _ := c.Params[key]

return value

}

|

day3-router/gee/router.go

1

2

3

4

5

6

7

8

9

10

|

func (r *router) handle(c *Context) {

n, params := r.getRoute(c.Method, c.Path)

if n != nil {

c.Params = params

key := c.Method + "-" + n.pattern

r.handlers[key](c) // 从字典中获取对应的处理函数,并执行该处理函数,传入上下文对象 c 作为参数

} else {

c.String(http.StatusNotFound, "404 NOT FOUND: %s\n", c.Path)

}

}

|

router.go的变化比较小,比较重要的一点是,在调用匹配到的handler前,将解析出来的路由参数赋值给了c.Params。这样就能够在handler中,通过Context对象访问到具体的值了。

单元测试

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

|

func newTestRouter() *router {

r := newRouter()

r.addRoute("GET", "/", nil)

r.addRoute("GET", "/hello/:name", nil)

r.addRoute("GET", "/hello/b/c", nil)

r.addRoute("GET", "/hi/:name", nil)

r.addRoute("GET", "/assets/*filepath", nil)

return r

}

func TestParsePattern(t *testing.T) {

ok := reflect.DeepEqual(parsePattern("/p/:name"), []string{"p", ":name"})

ok = ok && reflect.DeepEqual(parsePattern("/p/*"), []string{"p", "*"})

ok = ok && reflect.DeepEqual(parsePattern("/p/*name/*"), []string{"p", "*name"})

if !ok {

t.Fatal("test parsePattern failed")

}

}

func TestGetRoute(t *testing.T) {

r := newTestRouter()

n, ps := r.getRoute("GET", "/hello/geektutu")

if n == nil {

t.Fatal("nil shouldn't be returned")

}

if n.pattern != "/hello/:name" {

t.Fatal("should match /hello/:name")

}

if ps["name"] != "geektutu" {

t.Fatal("name should be equal to 'geektutu'")

}

fmt.Printf("matched path: %s, params['name']: %s\n", n.pattern, ps["name"])

}

|

使用Demo

看看框架使用的样例吧。

day3-router/main.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

func main() {

r := gee.New()

r.GET("/", func(c *gee.Context) {

c.HTML(http.StatusOK, "<h1>Hello Gee</h1>")

})

r.GET("/hello", func(c *gee.Context) {

// expect /hello?name=geektutu

c.String(http.StatusOK, "hello %s, you're at %s\n", c.Query("name"), c.Path)

})

r.GET("/hello/:name", func(c *gee.Context) {

// expect /hello/geektutu

c.String(http.StatusOK, "hello %s, you're at %s\n", c.Param("name"), c.Path)

})

r.GET("/assets/*filepath", func(c *gee.Context) {

c.JSON(http.StatusOK, gee.H{"filepath": c.Param("filepath")})

})

r.Run(":9999")

}

|

使用curl工具,测试结果。

1

2

3

4

5

|

$ curl "http://localhost:9999/hello/geektutu"

hello geektutu, you're at /hello/geektutu

$ curl "http://localhost:9999/assets/css/geektutu.css"

{"filepath":"css/geektutu.css"}

|

路由分组控制Group

- 实现路由分组控制(Route Group Control),代码约50行

分组的意义

分组控制(Group Control)是 Web 框架应提供的基础功能之一。所谓分组,是指路由的分组。如果没有路由分组,我们需要针对每一个路由进行控制。但是真实的业务场景中,往往某一组路由需要相似的处理。例如:

- 以

/post开头的路由匿名可访问。

- 以

/admin开头的路由需要鉴权。

- 以

/api开头的路由是 RESTful 接口,可以对接第三方平台,需要三方平台鉴权。

大部分情况下的路由分组,是以相同的前缀来区分的。因此,我们今天实现的分组控制也是以前缀来区分,并且支持分组的嵌套。例如/post是一个分组,/post/a和/post/b可以是该分组下的子分组。作用在/post分组上的中间件(middleware),也都会作用在子分组,子分组还可以应用自己特有的中间件。

中间件可以给框架提供无限的扩展能力,应用在分组上,可以使得分组控制的收益更为明显,而不是共享相同的路由前缀这么简单。例如/admin的分组,可以应用鉴权中间件;/分组应用日志中间件,/是默认的最顶层的分组,也就意味着给所有的路由,即整个框架增加了记录日志的能力。

提供扩展能力支持中间件的内容,我们将在下一节当中介绍。

分组嵌套

一个 Group 对象需要具备哪些属性呢?首先是前缀(prefix),比如/,或者/api;要支持分组嵌套,那么需要知道当前分组的父亲(parent)是谁;当然了,按照我们一开始的分析,中间件是应用在分组上的,那还需要存储应用在该分组上的中间件(middlewares)。还记得,我们之前调用函数(*Engine).addRoute()来映射所有的路由规则和 Handler 。如果Group对象需要直接映射路由规则的话,比如我们想在使用框架时,这么调用:

1

2

3

4

5

|

r := gee.New()

v1 := r.Group("/v1")

v1.GET("/", func(c *gee.Context) {

c.HTML(http.StatusOK, "<h1>Hello Gee</h1>")

})

|

那么Group对象,还需要有访问Router的能力,为了方便,我们可以在Group中,保存一个指针,指向Engine,整个框架的所有资源都是由Engine统一协调的,那么就可以通过Engine间接地访问各种接口了。

所以,最后的 Group 的定义是这样的:

day4-group/gee/gee.go

1

2

3

4

5

6

|

type RouterGroup struct {

prefix string

middlewares []HandlerFunc // support middleware

parent *RouterGroup // support nesting

engine *Engine // all groups share a Engine instance

}

|

我们还可以进一步地抽象,将Engine作为最顶层的分组,也就是说Engine拥有RouterGroup所有的能力。

1

2

3

4

5

|

type Engine struct {

*RouterGroup

router *router

groups []*RouterGroup // store all groups

}

|

那我们就可以将和路由有关的函数,都交给RouterGroup实现了。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

|

// New is the constructor of gee.Engine

func New() *Engine {

engine := &Engine{router: newRouter()}

engine.RouterGroup = &RouterGroup{engine: engine}

engine.groups = []*RouterGroup{engine.RouterGroup}

return engine

}

// Group is defined to create a new RouterGroup

// remember all groups share the same Engine instance

func (group *RouterGroup) Group(prefix string) *RouterGroup {

engine := group.engine

newGroup := &RouterGroup{

prefix: group.prefix + prefix,

parent: group,

engine: engine,

}

engine.groups = append(engine.groups, newGroup)

return newGroup

}

func (group *RouterGroup) addRoute(method string, comp string, handler HandlerFunc) {

pattern := group.prefix + comp

log.Printf("Route %4s - %s", method, pattern)

group.engine.router.addRoute(method, pattern, handler)

}

// GET defines the method to add GET request

func (group *RouterGroup) GET(pattern string, handler HandlerFunc) {

group.addRoute("GET", pattern, handler)

}

// POST defines the method to add POST request

func (group *RouterGroup) POST(pattern string, handler HandlerFunc) {

group.addRoute("POST", pattern, handler)

}

|

可以仔细观察下addRoute函数,调用了group.engine.router.addRoute来实现了路由的映射。由于Engine从某种意义上继承了RouterGroup的所有属性和方法,因为 (*Engine).engine 是指向自己的。这样实现,我们既可以像原来一样添加路由,也可以通过分组添加路由。

使用 Demo

测试框架的Demo就可以这样写了:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

|

func main() {

r := gee.New()

r.GET("/index", func(c *gee.Context) {

c.HTML(http.StatusOK, "<h1>Index Page</h1>")

})

v1 := r.Group("/v1")

{

v1.GET("/", func(c *gee.Context) {

c.HTML(http.StatusOK, "<h1>Hello Gee</h1>")

})

v1.GET("/hello", func(c *gee.Context) {

// expect /hello?name=geektutu

c.String(http.StatusOK, "hello %s, you're at %s\n", c.Query("name"), c.Path)

})

}

v2 := r.Group("/v2")

{

v2.GET("/hello/:name", func(c *gee.Context) {

// expect /hello/geektutu

c.String(http.StatusOK, "hello %s, you're at %s\n", c.Param("name"), c.Path)

})

v2.POST("/login", func(c *gee.Context) {

c.JSON(http.StatusOK, gee.H{

"username": c.PostForm("username"),

"password": c.PostForm("password"),

})

})

}

r.Run(":9999")

}

|

通过 curl 简单测试:

1

2

3

4

5

|

$ curl "http://localhost:9999/v1/hello?name=geektutu"

hello geektutu, you're at /v1/hello

$ curl "http://localhost:9999/v2/hello/geektutu"

hello geektutu, you're at /v2/hello/geektutu

|

中间件Middleware

- 设计并实现 Web 框架的中间件(Middlewares)机制。

- 实现通用的

Logger中间件,能够记录请求到响应所花费的时间,代码约50行

中间件是什么

中间件(middlewares),简单说,就是非业务的技术类组件。Web 框架本身不可能去理解所有的业务,因而不可能实现所有的功能。因此,框架需要有一个插口,允许用户自己定义功能,嵌入到框架中,仿佛这个功能是框架原生支持的一样。因此,对中间件而言,需要考虑2个比较关键的点:

- 插入点在哪?使用框架的人并不关心底层逻辑的具体实现,如果插入点太底层,中间件逻辑就会非常复杂。如果插入点离用户太近,那和用户直接定义一组函数,每次在 Handler 中手工调用没有多大的优势了。

- 中间件的输入是什么?中间件的输入,决定了扩展能力。暴露的参数太少,用户发挥空间有限。

那对于一个 Web 框架而言,中间件应该设计成什么样呢?接下来的实现,基本参考了 Gin 框架。

中间件设计

Gee 的中间件的定义与路由映射的 Handler 一致,处理的输入是Context对象。插入点是框架接收到请求初始化Context对象后,允许用户使用自己定义的中间件做一些额外的处理,例如记录日志等,以及对Context进行二次加工。另外通过调用(*Context).Next()函数,中间件可等待用户自己定义的 Handler处理结束后,再做一些额外的操作,例如计算本次处理所用时间等。即 Gee 的中间件支持用户在请求被处理的前后,做一些额外的操作。举个例子,我们希望最终能够支持如下定义的中间件,c.Next()表示等待执行其他的中间件或用户的Handler:

day4-group/gee/logger.go

1

2

3

4

5

6

7

8

9

10

|

func Logger() HandlerFunc {

return func(c *Context) {

// Start timer

t := time.Now()

// Process request

c.Next()

// Calculate resolution time

log.Printf("[%d] %s in %v", c.StatusCode, c.Req.RequestURI, time.Since(t))

}

}

|

另外,支持设置多个中间件,依次进行调用。

我们上一篇文章路由分组控制 Group Control中讲到,中间件是应用在RouterGroup上的,应用在最顶层的 Group,相当于作用于全局,所有的请求都会被中间件处理。那为什么不作用在每一条路由规则上呢?作用在某条路由规则,那还不如用户直接在 Handler 中调用直观。只作用在某条路由规则的功能通用性太差,不适合定义为中间件。

我们之前的框架设计是这样的,当接收到请求后,匹配路由,该请求的所有信息都保存在Context中。中间件也不例外,接收到请求后,应查找所有应作用于该路由的中间件,保存在Context中,依次进行调用。为什么依次调用后,还需要在Context中保存呢?因为在设计中,中间件不仅作用在处理流程前,也可以作用在处理流程后,即在用户定义的 Handler 处理完毕后,还可以执行剩下的操作。

为此,我们给Context添加了2个参数,定义了Next方法:

day4-group/gee/context.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

|

type Context struct {

// origin objects

Writer http.ResponseWriter

Req *http.Request

// request info

Path string

Method string

Params map[string]string

// response info

StatusCode int

// middleware

handlers []HandlerFunc

index int

}

func newContext(w http.ResponseWriter, req *http.Request) *Context {

return &Context{

Path: req.URL.Path,

Method: req.Method,

Req: req,

Writer: w,

index: -1,

}

}

func (c *Context) Next() {

c.index++

s := len(c.handlers)

for ; c.index < s; c.index++ {

c.handlers[c.index](c)

}

}

func (c *Context) Fail(code int, err string) {

c.index = len(c.handlers)

c.JSON(code, H{"message": err})

}

|

index是记录当前执行到第几个中间件,当在中间件中调用Next方法时,控制权交给了下一个中间件,直到调用到最后一个中间件,然后再从后往前,调用每个中间件在Next方法之后定义的部分。如果我们将用户在映射路由时定义的Handler添加到c.handlers列表中,结果会怎么样呢?想必你已经猜到了。

1

2

3

4

5

6

7

8

9

10

|

func A(c *Context) {

part1

c.Next()

part2

}

func B(c *Context) {

part3

c.Next()

part4

}

|

假设我们应用了中间件 A 和 B,和路由映射的 Handler。c.handlers是这样的[A, B, Handler],c.index初始化为-1。调用c.Next(),接下来的流程是这样的:

- c.index++,c.index 变为 0

- 0 < 3,调用 c.handlers[0],即 A

- 执行 part1,调用 c.Next()

- c.index++,c.index 变为 1

- 1 < 3,调用 c.handlers[1],即 B

- 执行 part3,调用 c.Next()

- c.index++,c.index 变为 2

- 2 < 3,调用 c.handlers[2],即Handler

- Handler 调用完毕,返回到 B 中的 part4,执行 part4

- part4 执行完毕,返回到 A 中的 part2,执行 part2

- part2 执行完毕,结束。

一句话说清楚重点,最终的顺序是part1 -> part3 -> Handler -> part 4 -> part2。恰恰满足了我们对中间件的要求,接下来看调用部分的代码,就能全部串起来了。

代码实现

- 定义

Use函数,将中间件应用到某个 Group 。

day4-group/gee/gee.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

// Use is defined to add middleware to the group

func (group *RouterGroup) Use(middlewares ...HandlerFunc) {

group.middlewares = append(group.middlewares, middlewares...)

}

func (engine *Engine) ServeHTTP(w http.ResponseWriter, req *http.Request) {

var middlewares []HandlerFunc

for _, group := range engine.groups {

if strings.HasPrefix(req.URL.Path, group.prefix) {

middlewares = append(middlewares, group.middlewares...)

}

}

c := newContext(w, req)

c.handlers = middlewares

engine.router.handle(c)

}

|

ServeHTTP 函数也有变化,当我们接收到一个具体请求时,要判断该请求适用于哪些中间件,在这里我们简单通过 URL 的前缀来判断。得到中间件列表后,赋值给 c.handlers。

day4-group/gee/router.go

- handle 函数中,将从路由匹配得到的 Handler 添加到

c.handlers列表中,执行c.Next()。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

func (r *router) handle(c *Context) {

n, params := r.getRoute(c.Method, c.Path)

if n != nil {

key := c.Method + "-" + n.pattern

c.Params = params

c.handlers = append(c.handlers, r.handlers[key])

} else {

c.handlers = append(c.handlers, func(c *Context) {

c.String(http.StatusNotFound, "404 NOT FOUND: %s\n", c.Path)

})

}

c.Next()

}

|

使用 Demo

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

func onlyForV2() gee.HandlerFunc {

return func(c *gee.Context) {

// Start timer

t := time.Now()

// if a server error occurred

c.Fail(500, "Internal Server Error")

// Calculate resolution time

log.Printf("[%d] %s in %v for group v2", c.StatusCode, c.Req.RequestURI, time.Since(t))

}

}

func main() {

r := gee.New()

r.Use(gee.Logger()) // global midlleware

r.GET("/", func(c *gee.Context) {

c.HTML(http.StatusOK, "<h1>Hello Gee</h1>")

})

v2 := r.Group("/v2")

v2.Use(onlyForV2()) // v2 group middleware

{

v2.GET("/hello/:name", func(c *gee.Context) {

// expect /hello/geektutu

c.String(http.StatusOK, "hello %s, you're at %s\n", c.Param("name"), c.Path)

})

}

r.Run(":9999")

}

|

gee.Logger()即我们一开始就介绍的中间件,我们将这个中间件和框架代码放在了一起,作为框架默认提供的中间件。在这个例子中,我们将gee.Logger()应用在了全局,所有的路由都会应用该中间件。onlyForV2()是用来测试功能的,仅在v2对应的 Group 中应用了。

接下来使用 curl 测试,可以看到,v2 Group 2个中间件都生效了。

1

2

3

4

5

6

7

8

9

|

$ curl http://localhost:9999/

>>> log

2019/08/17 01:37:38 [200] / in 3.14µs

(2) global + group middleware

$ curl http://localhost:9999/v2/hello/geektutu

>>> log

2019/08/17 01:38:48 [200] /v2/hello/geektutu in 61.467µs for group v2

2019/08/17 01:38:48 [200] /v2/hello/geektutu in 281µs

|

模板Template

- 实现静态资源服务(Static Resource)。

- 支持HTML模板渲染。

服务端渲染

现在越来越流行前后端分离的开发模式,即 Web 后端提供 RESTful 接口,返回结构化的数据(通常为 JSON 或者 XML)。前端使用 AJAX 技术请求到所需的数据,利用 JavaScript 进行渲染。Vue/React 等前端框架持续火热,这种开发模式前后端解耦,优势非常突出。后端童鞋专心解决资源利用,并发,数据库等问题,只需要考虑数据如何生成;前端童鞋专注于界面设计实现,只需要考虑拿到数据后如何渲染即可。使用 JSP 写过网站的童鞋,应该能感受到前后端耦合的痛苦。JSP 的表现力肯定是远不如 Vue/React 等专业做前端渲染的框架的。而且前后端分离在当前还有另外一个不可忽视的优势。因为后端只关注于数据,接口返回值是结构化的,与前端解耦。同一套后端服务能够同时支撑小程序、移动APP、PC端 Web 页面,以及对外提供的接口。随着前端工程化的不断地发展,Webpack,gulp 等工具层出不穷,前端技术越来越自成体系了。

但前后分离的一大问题在于,页面是在客户端渲染的,比如浏览器,这对于爬虫并不友好。Google 爬虫已经能够爬取渲染后的网页,但是短期内爬取服务端直接渲染的 HTML 页面仍是主流。

今天的内容便是介绍 Web 框架如何支持服务端渲染的场景。

静态文件(Serve Static Files)

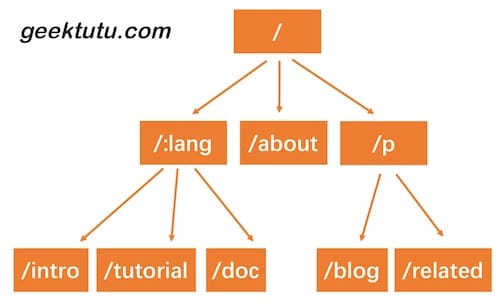

网页的三剑客,JavaScript、CSS 和 HTML。要做到服务端渲染,第一步便是要支持 JS、CSS 等静态文件。还记得我们之前设计动态路由的时候,支持通配符*匹配多级子路径。比如路由规则/assets/*filepath,可以匹配/assets/开头的所有的地址。例如/assets/js/geektutu.js,匹配后,参数filepath就赋值为js/geektutu.js。

那如果我么将所有的静态文件放在/usr/web目录下,那么filepath的值即是该目录下文件的相对地址。映射到真实的文件后,将文件返回,静态服务器就实现了。

找到文件后,如何返回这一步,net/http库已经实现了。因此,gee 框架要做的,仅仅是解析请求的地址,映射到服务器上文件的真实地址,交给http.FileServer处理就好了。

day6-template/gee/gee.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

// create static handler

func (group *RouterGroup) createStaticHandler(relativePath string, fs http.FileSystem) HandlerFunc {

absolutePath := path.Join(group.prefix, relativePath)

fileServer := http.StripPrefix(absolutePath, http.FileServer(fs))

return func(c *Context) {

file := c.Param("filepath")

// Check if file exists and/or if we have permission to access it

if _, err := fs.Open(file); err != nil {

c.Status(http.StatusNotFound)

return

}

fileServer.ServeHTTP(c.Writer, c.Req)

}

}

// serve static files

func (group *RouterGroup) Static(relativePath string, root string) {

handler := group.createStaticHandler(relativePath, http.Dir(root))

urlPattern := path.Join(relativePath, "/*filepath")

// Register GET handlers

group.GET(urlPattern, handler)

}

|

我们给RouterGroup添加了2个方法,Static这个方法是暴露给用户的。用户可以将磁盘上的某个文件夹root映射到路由relativePath。例如:

1

2

3

4

|

r := gee.New()

r.Static("/assets", "/usr/geektutu/blog/static")

// 或相对路径 r.Static("/assets", "./static")

r.Run(":9999")

|

用户访问localhost:9999/assets/js/geektutu.js,最终返回/usr/geektutu/blog/static/js/geektutu.js。

HTML 模板渲染

Go语言内置了text/template和html/template2个模板标准库,其中html/template为 HTML 提供了较为完整的支持。包括普通变量渲染、列表渲染、对象渲染等。gee 框架的模板渲染直接使用了html/template提供的能力。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

type Engine struct {

*RouterGroup

router *router

groups []*RouterGroup // store all groups

htmlTemplates *template.Template // for html render

funcMap template.FuncMap // for html render

}

func (engine *Engine) SetFuncMap(funcMap template.FuncMap) {

engine.funcMap = funcMap

}

func (engine *Engine) LoadHTMLGlob(pattern string) {

engine.htmlTemplates = template.Must(template.New("").Funcs(engine.funcMap).ParseGlob(pattern))

}

|

首先为 Engine 示例添加了 *template.Template 和 template.FuncMap对象,前者将所有的模板加载进内存,后者是所有的自定义模板渲染函数。

另外,给用户分别提供了设置自定义渲染函数funcMap和加载模板的方法。

接下来,对原来的 (*Context).HTML()方法做了些小修改,使之支持根据模板文件名选择模板进行渲染。

day6-template/gee/context.go

1

2

3

4

5

6

7

8

9

10

11

12

13

|

type Context struct {

// ...

// engine pointer

engine *Engine

}

func (c *Context) HTML(code int, name string, data interface{}) {

c.SetHeader("Content-Type", "text/html")

c.Status(code)

if err := c.engine.htmlTemplates.ExecuteTemplate(c.Writer, name, data); err != nil {

c.Fail(500, err.Error())

}

}

|

我们在 Context 中添加了成员变量 engine *Engine,这样就能够通过 Context 访问 Engine 中的 HTML 模板。实例化 Context 时,还需要给 c.engine 赋值。

day6-template/gee/gee.go

1

2

3

4

5

6

7

|

func (engine *Engine) ServeHTTP(w http.ResponseWriter, req *http.Request) {

// ...

c := newContext(w, req)

c.handlers = middlewares

c.engine = engine

engine.router.handle(c)

}

|

使用Demo

最终的目录结构

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

---gee/

---static/

|---css/

|---geektutu.css

|---file1.txt

---templates/

|---arr.tmpl

|---css.tmpl

|---custom_func.tmpl

---main.go

<!-- day6-template/templates/css.tmpl -->

<html>

<link rel="stylesheet" href="/assets/css/geektutu.css">

<p>geektutu.css is loaded</p>

</html>

|

day6-template/main.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

type student struct {

Name string

Age int8

}

func FormatAsDate(t time.Time) string {

year, month, day := t.Date()

return fmt.Sprintf("%d-%02d-%02d", year, month, day)

}

func main() {

r := gee.New()

r.Use(gee.Logger())

r.SetFuncMap(template.FuncMap{

"FormatAsDate": FormatAsDate,

})

r.LoadHTMLGlob("templates/*")

r.Static("/assets", "./static")

stu1 := &student{Name: "Geektutu", Age: 20}

stu2 := &student{Name: "Jack", Age: 22}

r.GET("/", func(c *gee.Context) {

c.HTML(http.StatusOK, "css.tmpl", nil)

})

r.GET("/students", func(c *gee.Context) {

c.HTML(http.StatusOK, "arr.tmpl", gee.H{

"title": "gee",

"stuArr": [2]*student{stu1, stu2},

})

})

r.GET("/date", func(c *gee.Context) {

c.HTML(http.StatusOK, "custom_func.tmpl", gee.H{

"title": "gee",

"now": time.Date(2019, 8, 17, 0, 0, 0, 0, time.UTC),

})

})

r.Run(":9999")

}

|

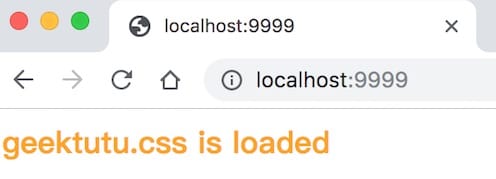

访问下主页,模板正常渲染,CSS 静态文件加载成功。

错误处理

panic

Go 语言中,比较常见的错误处理方法是返回 error,由调用者决定后续如何处理。但是如果是无法恢复的错误,可以手动触发 panic,当然如果在程序运行过程中出现了类似于数组越界的错误,panic 也会被触发。panic 会中止当前执行的程序,退出。

下面是主动触发的例子:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

// hello.go

func main() {

fmt.Println("before panic")

panic("crash")

fmt.Println("after panic")

}

$ go run hello.go

before panic

panic: crash

goroutine 1 [running]:

main.main()

~/go_demo/hello/hello.go:7 +0x95

exit status 2

|

下面是数组越界触发的 panic

1

2

3

4

5

6

7

|

// hello.go

func main() {

arr := []int{1, 2, 3}

fmt.Println(arr[4])

}

$ go run hello.go

panic: runtime error: index out of range [4] with length 3

|

defer

panic 会导致程序被中止,但是在退出前,会先处理完当前协程上已经defer 的任务,执行完成后再退出。效果类似于 java 语言的 try...catch。

1

2

3

4

5

6

7

8

9

10

11

12

|

// hello.go

func main() {

defer func() {

fmt.Println("defer func")

}()

arr := []int{1, 2, 3}

fmt.Println(arr[4])

}

$ go run hello.go

defer func

panic: runtime error: index out of range [4] with length 3

|

可以 defer 多个任务,在同一个函数中 defer 多个任务,会逆序执行。即先执行最后 defer 的任务。

在这里,defer 的任务执行完成之后,panic 还会继续被抛出,导致程序非正常结束。

recover

Go 语言还提供了 recover 函数,可以避免因为 panic 发生而导致整个程序终止,recover 函数只在 defer 中生效。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

// hello.go

func test_recover() {

defer func() {

fmt.Println("defer func")

if err := recover(); err != nil {

fmt.Println("recover success")

}

}()

arr := []int{1, 2, 3}

fmt.Println(arr[4])

fmt.Println("after panic")

}

func main() {

test_recover()

fmt.Println("after recover")

}

$ go run hello.go

defer func

recover success

after recover

|

我们可以看到,recover 捕获了 panic,程序正常结束。test_recover() 中的 after panic 没有打印,这是正确的,当 panic 被触发时,控制权就被交给了 defer 。就像在 java 中,try代码块中发生了异常,控制权交给了 catch,接下来执行 catch 代码块中的代码。而在 main() 中打印了 after recover,说明程序已经恢复正常,继续往下执行直到结束。

Gee 的错误处理机制

对一个 Web 框架而言,错误处理机制是非常必要的。可能是框架本身没有完备的测试,导致在某些情况下出现空指针异常等情况。也有可能用户不正确的参数,触发了某些异常,例如数组越界,空指针等。如果因为这些原因导致系统宕机,必然是不可接受的。

我们在上一节实现的框架并没有加入异常处理机制,如果代码中存在会触发 panic 的 BUG,很容易宕掉。

例如下面的代码:

1

2

3

4

5

6

7

8

|

func main() {

r := gee.New()

r.GET("/panic", func(c *gee.Context) {

names := []string{"geektutu"}

c.String(http.StatusOK, names[100])

})

r.Run(":9999")

}

|

在上面的代码中,我们为 gee 注册了路由 /panic,而这个路由的处理函数内部存在数组越界 names[100],如果访问 localhost:9999/panic,Web 服务就会宕掉。

今天,我们将在 gee 中添加一个非常简单的错误处理机制,即在此类错误发生时,向用户返回 Internal Server Error,并且在日志中打印必要的错误信息,方便进行错误定位。

我们之前实现了中间件机制,错误处理也可以作为一个中间件,增强 gee 框架的能力。

新增文件 gee/recovery.go,在这个文件中实现中间件 Recovery。

1

2

3

4

5

6

7

8

9

10

11

12

13

|

func Recovery() HandlerFunc {

return func(c *Context) {

defer func() {

if err := recover(); err != nil {

message := fmt.Sprintf("%s", err)

log.Printf("%s\n\n", trace(message))

c.Fail(http.StatusInternalServerError, "Internal Server Error")

}

}()

c.Next()

}

}

|

Recovery 的实现非常简单,使用 defer 挂载上错误恢复的函数,在这个函数中调用 recover(),捕获 panic,并且将堆栈信息打印在日志中,向用户返回 Internal Server Error。

你可能注意到,这里有一个 trace() 函数,这个函数是用来获取触发 panic 的堆栈信息,完整代码如下:

day7-panic-recover/gee/recovery.go

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

|

package gee

import (

"fmt"

"log"

"net/http"

"runtime"

"strings"

)

// print stack trace for debug

func trace(message string) string {

var pcs [32]uintptr

n := runtime.Callers(3, pcs[:]) // skip first 3 caller

var str strings.Builder

str.WriteString(message + "\nTraceback:")

for _, pc := range pcs[:n] {

fn := runtime.FuncForPC(pc)

file, line := fn.FileLine(pc)

str.WriteString(fmt.Sprintf("\n\t%s:%d", file, line))

}

return str.String()

}

func Recovery() HandlerFunc {

return func(c *Context) {

defer func() {

if err := recover(); err != nil {

message := fmt.Sprintf("%s", err)

log.Printf("%s\n\n", trace(message))

c.Fail(http.StatusInternalServerError, "Internal Server Error")

}

}()

c.Next()

}

}

|

在 trace() 中,调用了 runtime.Callers(3, pcs[:]),Callers 用来返回调用栈的程序计数器, 第 0 个 Caller 是 Callers 本身,第 1 个是上一层 trace,第 2 个是再上一层的 defer func。因此,为了日志简洁一点,我们跳过了前 3 个 Caller。

接下来,通过 runtime.FuncForPC(pc) 获取对应的函数,在通过 fn.FileLine(pc) 获取到调用该函数的文件名和行号,打印在日志中。

至此,gee 框架的错误处理机制就完成了。

使用 Demo

day7-panic-recover/main.go

1

2

3

4

5

6

7

8

9

10

11

12

13

|

func main() {

r := gee.Default()

r.GET("/", func(c *gee.Context) {

c.String(http.StatusOK, "Hello Geektutu\n")

})

// index out of range for testing Recovery()

r.GET("/panic", func(c *gee.Context) {

names := []string{"geektutu"}

c.String(http.StatusOK, names[100])

})

r.Run(":9999")

}

|

day7-panic-recover/gee.go

1

2

3

4

5

6

|

// Default use Logger() & Recovery middlewares

func Default() *Engine {

engine := New()

engine.Use(Logger(), Recovery())

return engine

}

|

接下来进行测试,先访问主页,访问一个有BUG的 /panic,服务正常返回。接下来我们再一次成功访问了主页,说明服务完全运转正常。

1

2

3

4

5

6

|

$ curl "http://localhost:9999"

Hello Geektutu

$ curl "http://localhost:9999/panic"

{"message":"Internal Server Error"}

$ curl "http://localhost:9999"

Hello Geektutu

|

我们可以在后台日志中看到如下内容,引发错误的原因和堆栈信息都被打印了出来,通过日志,我们可以很容易地知道,在day7-panic-recover/main.go:47 的地方出现了 index out of range 错误。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

2020/01/09 01:00:10 Route GET - /

2020/01/09 01:00:10 Route GET - /panic

2020/01/09 01:00:22 [200] / in 25.364µs

2020/01/09 01:00:32 runtime error: index out of range

Traceback:

/usr/local/Cellar/go/1.12.5/libexec/src/runtime/panic.go:523

/usr/local/Cellar/go/1.12.5/libexec/src/runtime/panic.go:44

/tmp/7days-golang/day7-panic-recover/main.go:47

/tmp/7days-golang/day7-panic-recover/gee/context.go:41

/tmp/7days-golang/day7-panic-recover/gee/recovery.go:37

/tmp/7days-golang/day7-panic-recover/gee/context.go:41

/tmp/7days-golang/day7-panic-recover/gee/logger.go:15

/tmp/7days-golang/day7-panic-recover/gee/context.go:41

/tmp/7days-golang/day7-panic-recover/gee/router.go:99

/tmp/7days-golang/day7-panic-recover/gee/gee.go:130

/usr/local/Cellar/go/1.12.5/libexec/src/net/http/server.go:2775

/usr/local/Cellar/go/1.12.5/libexec/src/net/http/server.go:1879

/usr/local/Cellar/go/1.12.5/libexec/src/runtime/asm_amd64.s:1338

2020/01/09 01:00:32 [500] /panic in 395.846µs

2020/01/09 01:00:38 [200] / in 6.985µs

|

参考

分布式缓存 - GeeCache

谈谈分布式缓存

第一次请求时将一些耗时操作的结果暂存,以后遇到相同的请求,直接返回暂存的数据。我想这是大部分童鞋对于缓存的理解。在计算机系统中,缓存无处不在,比如我们访问一个网页,网页和引用的 JS/CSS 等静态文件,根据不同的策略,会缓存在浏览器本地或是 CDN 服务器,那在第二次访问的时候,就会觉得网页加载的速度快了不少;比如微博的点赞的数量,不可能每个人每次访问,都从数据库中查找所有点赞的记录再统计,数据库的操作是很耗时的,很难支持那么大的流量,所以一般点赞这类数据是缓存在 Redis 服务集群中的。

商业世界里,现金为王;架构世界里,缓存为王。

缓存中最简单的莫过于存储在内存中的键值对缓存了。说到键值对,很容易想到的是字典(dict)类型,Go 语言中称之为 map。那直接创建一个 map,每次有新数据就往 map 中插入不就好了,这不就是键值对缓存么?这样做有什么问题呢?

1)内存不够了怎么办?

那就随机删掉几条数据好了。随机删掉好呢?还是按照时间顺序好呢?或者是有没有其他更好的淘汰策略呢?不同数据的访问频率是不一样的,优先删除访问频率低的数据是不是更好呢?数据的访问频率可能随着时间变化,那优先删除最近最少访问的数据可能是一个更好的选择。我们需要实现一个合理的淘汰策略。

2)并发写入冲突了怎么办?

对缓存的访问,一般不可能是串行的。map 是没有并发保护的,应对并发的场景,修改操作(包括新增,更新和删除)需要加锁。

3)单机性能不够怎么办?

单台计算机的资源是有限的,计算、存储等都是有限的。随着业务量和访问量的增加,单台机器很容易遇到瓶颈。如果利用多台计算机的资源,并行处理提高性能就要缓存应用能够支持分布式,这称为水平扩展(scale horizontally)。与水平扩展相对应的是垂直扩展(scale vertically),即通过增加单个节点的计算、存储、带宽等,来提高系统的性能,硬件的成本和性能并非呈线性关系,大部分情况下,分布式系统是一个更优的选择。

4)…

关于 GeeCache

设计一个分布式缓存系统,需要考虑资源控制、淘汰策略、并发、分布式节点通信等各个方面的问题。而且,针对不同的应用场景,还需要在不同的特性之间权衡,例如,是否需要支持缓存更新?还是假定缓存在淘汰之前是不允许改变的。不同的权衡对应着不同的实现。

groupcache 是 Go 语言版的 memcached,目的是在某些特定场合替代 memcached。groupcache 的作者也是 memcached 的作者。无论是了解单机缓存还是分布式缓存,深入学习这个库的实现都是非常有意义的。

GeeCache 基本上模仿了 groupcache 的实现,为了将代码量限制在 500 行左右(groupcache 约 3000 行),裁剪了部分功能。但总体实现上,还是与 groupcache 非常接近的。支持特性有:

- 单机缓存和基于 HTTP 的分布式缓存

- 最近最少访问(Least Recently Used, LRU) 缓存策略

- 使用 Go 锁机制防止缓存击穿

- 使用一致性哈希选择节点,实现负载均衡

- 使用 protobuf 优化节点间二进制通信

- …

LRU 缓存淘汰策略

- 介绍常用的三种缓存淘汰(失效)算法:FIFO,LFU 和 LRU

- 实现 LRU 缓存淘汰算法,代码约80行

FIFO/LFU/LRU 算法简介

GeeCache 的缓存全部存储在内存中,内存是有限的,因此不可能无限制地添加数据。假定我们设置缓存能够使用的内存大小为 N,那么在某一个时间点,添加了某一条缓存记录之后,占用内存超过了 N,这个时候就需要从缓存中移除一条或多条数据了。那移除谁呢?我们肯定希望尽可能移除“没用”的数据,那如何判定数据“有用”还是“没用”呢?

FIFO(First In First Out)

先进先出,也就是淘汰缓存中最老(最早添加)的记录。FIFO 认为,最早添加的记录,其不再被使用的可能性比刚添加的可能性大。这种算法的实现也非常简单,创建一个队列,新增记录添加到队尾,每次内存不够时,淘汰队首。但是很多场景下,部分记录虽然是最早添加但也最常被访问,而不得不因为呆的时间太长而被淘汰。这类数据会被频繁地添加进缓存,又被淘汰出去,导致缓存命中率降低。

LFU(Least Frequently Used)

最少使用,也就是淘汰缓存中访问频率最低的记录。LFU 认为,如果数据过去被访问多次,那么将来被访问的频率也更高。LFU 的实现需要维护一个按照访问次数排序的队列,每次访问,访问次数加1,队列重新排序,淘汰时选择访问次数最少的即可。LFU 算法的命中率是比较高的,但缺点也非常明显,维护每个记录的访问次数,对内存的消耗是很高的;另外,如果数据的访问模式发生变化,LFU 需要较长的时间去适应,也就是说 LFU 算法受历史数据的影响比较大。例如某个数据历史上访问次数奇高,但在某个时间点之后几乎不再被访问,但因为历史访问次数过高,而迟迟不能被淘汰。

LRU(Least Recently Used)

最近最少使用,相对于仅考虑时间因素的 FIFO 和仅考虑访问频率的 LFU,LRU 算法可以认为是相对平衡的一种淘汰算法。LRU 认为,如果数据最近被访问过,那么将来被访问的概率也会更高。LRU 算法的实现非常简单,维护一个队列,如果某条记录被访问了,则移动到队尾,那么队首则是最近最少访问的数据,淘汰该条记录即可。

LRU 算法实现

核心数据结构

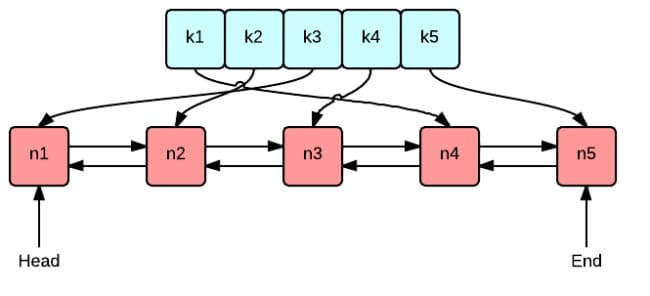

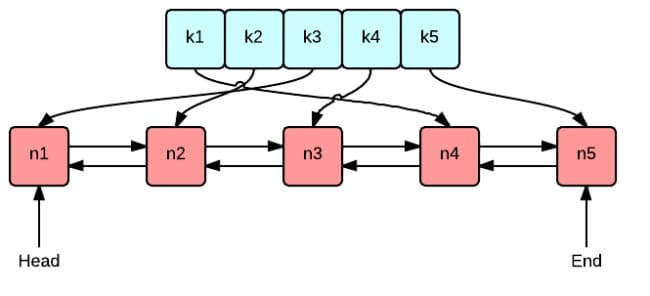

这张图很好地表示了 LRU 算法最核心的 2 个数据结构

- 绿色的是字典(map),存储键和值的映射关系。这样根据某个键(key)查找对应的值(value)的复杂是

O(1),在字典中插入一条记录的复杂度也是O(1)。

- 红色的是双向链表(double linked list)实现的队列。将所有的值放到双向链表中,这样,当访问到某个值时,将其移动到队尾的复杂度是

O(1),在队尾新增一条记录以及删除一条记录的复杂度均为O(1)。

接下来我们创建一个包含字典和双向链表的结构体类型 Cache,方便实现后续的增删查改操作。

day1-lru/geecache/lru/lru.go - github

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

package lru

import "container/list"

// Cache is a LRU cache. It is not safe for concurrent access.

type Cache struct {

maxBytes int64

nbytes int64

ll *list.List

cache map[string]*list.Element

// optional and executed when an entry is purged.

OnEvicted func(key string, value Value)

}

type entry struct {

key string

value Value

}

// Value use Len to count how many bytes it takes

type Value interface {

Len() int

}

|

- 在这里我们直接使用 Go 语言标准库实现的双向链表

list.List。

- 字典的定义是

map[string]*list.Element,键是字符串,值是双向链表中对应节点的指针。

maxBytes 是允许使用的最大内存,nbytes 是当前已使用的内存,OnEvicted 是某条记录被移除时的回调函数,可以为 nil。- 键值对

entry 是双向链表节点的数据类型,在链表中仍保存每个值对应的 key 的好处在于,淘汰队首节点时,需要用 key 从字典中删除对应的映射。

- 为了通用性,我们允许值是实现了

Value 接口的任意类型,该接口只包含了一个方法 Len() int,用于返回值所占用的内存大小。

方便实例化 Cache,实现 New() 函数:

1

2

3

4

5

6

7

8

9

|

// New is the Constructor of Cache

func New(maxBytes int64, onEvicted func(string, Value)) *Cache {

return &Cache{

maxBytes: maxBytes,

ll: list.New(),

cache: make(map[string]*list.Element),

OnEvicted: onEvicted,

}

}

|

查找功能

查找主要有 2 个步骤,第一步是从字典中找到对应的双向链表的节点,第二步,将该节点移动到队尾。

1

2

3

4

5

6

7

8

9

|

// Get look ups a key's value

func (c *Cache) Get(key string) (value Value, ok bool) {

if ele, ok := c.cache[key]; ok {

c.ll.MoveToFront(ele)

kv := ele.Value.(*entry)

return kv.value, true

}

return

}

|

- 如果键对应的链表节点存在,则将对应节点移动到队尾,并返回查找到的值。

c.ll.MoveToFront(ele),即将链表中的节点 ele 移动到队尾(双向链表作为队列,队首队尾是相对的,在这里约定 front 为队尾)

删除

这里的删除,实际上是缓存淘汰。即移除最近最少访问的节点(队首)

1

2

3

4

5

6

7

8

9

10

11

12

13

|

// RemoveOldest removes the oldest item

func (c *Cache) RemoveOldest() {

ele := c.ll.Back()

if ele != nil {

c.ll.Remove(ele)

kv := ele.Value.(*entry)

delete(c.cache, kv.key)

c.nbytes -= int64(len(kv.key)) + int64(kv.value.Len())

if c.OnEvicted != nil {

c.OnEvicted(kv.key, kv.value)

}

}

}

|

c.ll.Back() 取到队首节点,从链表中删除。delete(c.cache, kv.key),从字典中 c.cache 删除该节点的映射关系。- 更新当前所用的内存

c.nbytes。

- 如果回调函数

OnEvicted 不为 nil,则调用回调函数。

新增/修改

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

// Add adds a value to the cache.

func (c *Cache) Add(key string, value Value) {

if ele, ok := c.cache[key]; ok {

c.ll.MoveToFront(ele)

kv := ele.Value.(*entry)

c.nbytes += int64(value.Len()) - int64(kv.value.Len())

kv.value = value

} else {

ele := c.ll.PushFront(&entry{key, value})

c.cache[key] = ele

c.nbytes += int64(len(key)) + int64(value.Len())

}

for c.maxBytes != 0 && c.maxBytes < c.nbytes {

c.RemoveOldest()

}

}

|

- 如果键存在,则更新对应节点的值,并将该节点移到队尾。

- 不存在则是新增场景,首先队尾添加新节点

&entry{key, value}, 并字典中添加 key 和节点的映射关系。

- 更新

c.nbytes,如果超过了设定的最大值 c.maxBytes,则移除最少访问的节点。

最后,为了方便测试,我们实现 Len() 用来获取添加了多少条数据。

1

2

3

4

|

// Len the number of cache entries

func (c *Cache) Len() int {

return c.ll.Len()

}

|

测试

例如,我们可以尝试添加几条数据,测试 Get 方法

day1-lru/geecache/lru/lru_test.go - github

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

type String string

func (d String) Len() int {

return len(d)

}

func TestGet(t *testing.T) {

lru := New(int64(0), nil)

lru.Add("key1", String("1234"))

if v, ok := lru.Get("key1"); !ok || string(v.(String)) != "1234" {

t.Fatalf("cache hit key1=1234 failed")

}

if _, ok := lru.Get("key2"); ok {

t.Fatalf("cache miss key2 failed")

}

}

|

测试,当使用内存超过了设定值时,是否会触发“无用”节点的移除:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

func TestRemoveoldest(t *testing.T) {

k1, k2, k3 := "key1", "key2", "k3"

v1, v2, v3 := "value1", "value2", "v3"

cap := len(k1 + k2 + v1 + v2)

lru := New(int64(cap), nil)

lru.Add(k1, String(v1))

lru.Add(k2, String(v2))

lru.Add(k3, String(v3))

if _, ok := lru.Get("key1"); ok || lru.Len() != 2 {

t.Fatalf("Removeoldest key1 failed")

}

}

|

测试回调函数能否被调用:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

func TestOnEvicted(t *testing.T) {

keys := make([]string, 0)

callback := func(key string, value Value) {

keys = append(keys, key)

}

lru := New(int64(10), callback)

lru.Add("key1", String("123456"))

lru.Add("k2", String("k2"))

lru.Add("k3", String("k3"))

lru.Add("k4", String("k4"))

expect := []string{"key1", "k2"}

if !reflect.DeepEqual(expect, keys) {

t.Fatalf("Call OnEvicted failed, expect keys equals to %s", expect)

}

}

|

单机并发缓存

- 介绍 sync.Mutex 互斥锁的使用,并实现 LRU 缓存的并发控制。

- 实现 GeeCache 核心数据结构 Group,缓存不存在时,调用回调函数获取源数据,代码约150行

sync.Mutex

多个协程(goroutine)同时读写同一个变量,在并发度较高的情况下,会发生冲突。确保一次只有一个协程(goroutine)可以访问该变量以避免冲突,这称之为互斥,互斥锁可以解决这个问题。

sync.Mutex 是一个互斥锁,可以由不同的协程加锁和解锁。

sync.Mutex 是 Go 语言标准库提供的一个互斥锁,当一个协程(goroutine)获得了这个锁的拥有权后,其它请求锁的协程(goroutine) 就会阻塞在 Lock() 方法的调用上,直到调用 Unlock() 锁被释放。

接下来举一个简单的例子,假设有10个并发的协程打印了同一个数字100,为了避免重复打印,实现了printOnce(num int) 函数,使用集合 set 记录已打印过的数字,如果数字已打印过,则不再打印。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

var set = make(map[int]bool, 0)

func printOnce(num int) {

if _, exist := set[num]; !exist {

fmt.Println(num)

}

set[num] = true

}

func main() {

for i := 0; i < 10; i++ {

go printOnce(100)

}

time.Sleep(time.Second)

}

|

我们运行 go run . 会发生什么情况呢?

有时候打印 2 次,有时候打印 4 次,有时候还会触发 panic,因为对同一个数据结构set的访问冲突了。接下来用互斥锁的Lock()和Unlock() 方法将冲突的部分包裹起来:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

var m sync.Mutex

var set = make(map[int]bool, 0)

func printOnce(num int) {

m.Lock()

if _, exist := set[num]; !exist {

fmt.Println(num)

}

set[num] = true

m.Unlock()

}

func main() {

for i := 0; i < 10; i++ {

go printOnce(100)

}

time.Sleep(time.Second)

}

$ go run .

100

|

相同的数字只会被打印一次。当一个协程调用了 Lock() 方法时,其他协程被阻塞了,直到Unlock()调用将锁释放。因此被包裹部分的代码就能够避免冲突,实现互斥。

Unlock()释放锁还有另外一种写法:

1

2

3

4

5

6

7

8

|

func printOnce(num int) {

m.Lock()

defer m.Unlock()

if _, exist := set[num]; !exist {

fmt.Println(num)

}

set[num] = true

}

|

支持并发读写

上一篇文章 GeeCache 第一天 实现了 LRU 缓存淘汰策略。接下来我们使用 sync.Mutex 封装 LRU 的几个方法,使之支持并发的读写。在这之前,我们抽象了一个只读数据结构 ByteView 用来表示缓存值,是 GeeCache 主要的数据结构之一。

day2-single-node/geecache/byteview.go - github

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

package geecache

// A ByteView holds an immutable view of bytes.

type ByteView struct {

b []byte

}

// Len returns the view's length

func (v ByteView) Len() int {

return len(v.b)

}

// ByteSlice returns a copy of the data as a byte slice.

func (v ByteView) ByteSlice() []byte {

return cloneBytes(v.b)

}

// String returns the data as a string, making a copy if necessary.

func (v ByteView) String() string {

return string(v.b)

}

func cloneBytes(b []byte) []byte {

c := make([]byte, len(b))

copy(c, b)

return c

}

|

- ByteView 只有一个数据成员,

b []byte,b 将会存储真实的缓存值。选择 byte 类型是为了能够支持任意的数据类型的存储,例如字符串、图片等。

- 实现

Len() int 方法,我们在 lru.Cache 的实现中,要求被缓存对象必须实现 Value 接口,即 Len() int 方法,返回其所占的内存大小。

b 是只读的,使用 ByteSlice() 方法返回一个拷贝,防止缓存值被外部程序修改。

接下来就可以为 lru.Cache 添加并发特性了。

day2-single-node/geecache/cache.go - github

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

|

package geecache

import (

"geecache/lru"

"sync"

)

type cache struct {

mu sync.Mutex

lru *lru.Cache

cacheBytes int64

}

func (c *cache) add(key string, value ByteView) {

c.mu.Lock()

defer c.mu.Unlock()

if c.lru == nil {

c.lru = lru.New(c.cacheBytes, nil)

}

c.lru.Add(key, value)

}

func (c *cache) get(key string) (value ByteView, ok bool) {

c.mu.Lock()

defer c.mu.Unlock()

if c.lru == nil {

return

}

if v, ok := c.lru.Get(key); ok {

return v.(ByteView), ok

}

return

}

|

cache.go 的实现非常简单,实例化 lru,封装 get 和 add 方法,并添加互斥锁 mu。- 在

add 方法中,判断了 c.lru 是否为 nil,如果等于 nil 再创建实例。这种方法称之为延迟初始化(Lazy Initialization),一个对象的延迟初始化意味着该对象的创建将会延迟至第一次使用该对象时。主要用于提高性能,并减少程序内存要求。

主体结构 Group

Group 是 GeeCache 最核心的数据结构,负责与用户的交互,并且控制缓存值存储和获取的流程。

1

2

3

4

5

6

|

是

接收 key --> 检查是否被缓存 -----> 返回缓存值 ⑴

| 否 是

|-----> 是否应当从远程节点获取 -----> 与远程节点交互 --> 返回缓存值 ⑵

| 否

|-----> 调用`回调函数`,获取值并添加到缓存 --> 返回缓存值 ⑶

|

我们将在 geecache.go 中实现主体结构 Group,那么 GeeCache 的代码结构的雏形已经形成了。

1

2

3

4

5

6

|

geecache/

|--lru/

|--lru.go // lru 缓存淘汰策略

|--byteview.go // 缓存值的抽象与封装

|--cache.go // 并发控制

|--geecache.go // 负责与外部交互,控制缓存存储和获取的主流程

|

接下来我们将实现流程 ⑴ 和 ⑶,远程交互的部分后续再实现。

回调 Getter

我们思考一下,如果缓存不存在,应从数据源(文件,数据库等)获取数据并添加到缓存中。GeeCache 是否应该支持多种数据源的配置呢?不应该,一是数据源的种类太多,没办法一一实现;二是扩展性不好。如何从源头获取数据,应该是用户决定的事情,我们就把这件事交给用户好了。因此,我们设计了一个回调函数(callback),在缓存不存在时,调用这个函数,得到源数据。

day2-single-node/geecache/geecache.go - github

1

2

3

4

5

6

7

8

9

10

11

12

|

// A Getter loads data for a key.

type Getter interface {

Get(key string) ([]byte, error)

}

// A GetterFunc implements Getter with a function.

type GetterFunc func(key string) ([]byte, error)

// Get implements Getter interface function

func (f GetterFunc) Get(key string) ([]byte, error) {

return f(key)

}

|

- 定义接口 Getter 和 回调函数

Get(key string)([]byte, error),参数是 key,返回值是 []byte。

- 定义函数类型 GetterFunc,并实现 Getter 接口的

Get 方法。

- 函数类型实现某一个接口,称之为接口型函数,方便使用者在调用时既能够传入函数作为参数,也能够传入实现了该接口的结构体作为参数。

了解接口型函数的使用场景,可以参考 Go 接口型函数的使用场景 - 7days-golang Q & A

我们可以写一个测试用例来保证回调函数能够正常工作。

1

2

3

4

5

6

7

8

9

10

|

func TestGetter(t *testing.T) {

var f Getter = GetterFunc(func(key string) ([]byte, error) {

return []byte(key), nil

})

expect := []byte("key")

if v, _ := f.Get("key"); !reflect.DeepEqual(v, expect) {

t.Errorf("callback failed")

}

}

|

- 在这个测试用例中,我们借助 GetterFunc 的类型转换,将一个匿名回调函数转换成了接口

f Getter。

- 调用该接口的方法

f.Get(key string),实际上就是在调用匿名回调函数。

定义一个函数类型 F,并且实现接口 A 的方法,然后在这个方法中调用自己。这是 Go 语言中将其他函数(参数返回值定义与 F 一致)转换为接口 A 的常用技巧。

Group 的定义

接下来是最核心数据结构 Group 的定义:

day2-single-node/geecache/geecache.go - github

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

|

// A Group is a cache namespace and associated data loaded spread over

type Group struct {

name string

getter Getter

mainCache cache

}

var (

mu sync.RWMutex

groups = make(map[string]*Group)

)

// NewGroup create a new instance of Group

func NewGroup(name string, cacheBytes int64, getter Getter) *Group {

if getter == nil {

panic("nil Getter")

}

mu.Lock()

defer mu.Unlock()

g := &Group{

name: name,

getter: getter,

mainCache: cache{cacheBytes: cacheBytes},

}

groups[name] = g

return g

}

// GetGroup returns the named group previously created with NewGroup, or

// nil if there's no such group.

func GetGroup(name string) *Group {

mu.RLock()

g := groups[name]

mu.RUnlock()

return g

}

|

- 一个 Group 可以认为是一个缓存的命名空间,每个 Group 拥有一个唯一的名称

name。比如可以创建三个 Group,缓存学生的成绩命名为 scores,缓存学生信息的命名为 info,缓存学生课程的命名为 courses。

- 第二个属性是

getter Getter,即缓存未命中时获取源数据的回调(callback)。

- 第三个属性是

mainCache cache,即一开始实现的并发缓存。

- 构建函数

NewGroup 用来实例化 Group,并且将 group 存储在全局变量 groups 中。

GetGroup 用来特定名称的 Group,这里使用了只读锁 RLock(),因为不涉及任何冲突变量的写操作。

Group 的 Get 方法

接下来是 GeeCache 最为核心的方法 Get:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

|

// Get value for a key from cache

func (g *Group) Get(key string) (ByteView, error) {

if key == "" {

return ByteView{}, fmt.Errorf("key is required")

}

if v, ok := g.mainCache.get(key); ok {

log.Println("[GeeCache] hit")

return v, nil

}

return g.load(key)

}

func (g *Group) load(key string) (value ByteView, err error) {

return g.getLocally(key)

}

func (g *Group) getLocally(key string) (ByteView, error) {

bytes, err := g.getter.Get(key)

if err != nil {

return ByteView{}, err

}

value := ByteView{b: cloneBytes(bytes)}

g.populateCache(key, value)

return value, nil

}

func (g *Group) populateCache(key string, value ByteView) {

g.mainCache.add(key, value)

}

|

- Get 方法实现了上述所说的流程 ⑴ 和 ⑶。

- 流程 ⑴ :从 mainCache 中查找缓存,如果存在则返回缓存值。

- 流程 ⑶ :缓存不存在,则调用 load 方法,load 调用 getLocally(分布式场景下会调用 getFromPeer 从其他节点获取),getLocally 调用用户回调函数

g.getter.Get() 获取源数据,并且将源数据添加到缓存 mainCache 中(通过 populateCache 方法)

至此,这一章节的单机并发缓存就已经完成了。

测试

可以写测试用例,也可以写 main 函数来测试这一章节实现的功能。那我们通过测试用例来看一下,如何使用我们实现的单机并发缓存吧。

首先,用一个 map 模拟耗时的数据库。

1

2

3

4

5

|

var db = map[string]string{

"Tom": "630",

"Jack": "589",

"Sam": "567",

}

|

创建 group 实例,并测试 Get 方法

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

func TestGet(t *testing.T) {

loadCounts := make(map[string]int, len(db))

gee := NewGroup("scores", 2<<10, GetterFunc(

func(key string) ([]byte, error) {

log.Println("[SlowDB] search key", key)

if v, ok := db[key]; ok {

if _, ok := loadCounts[key]; !ok {

loadCounts[key] = 0

}

loadCounts[key] += 1

return []byte(v), nil

}

return nil, fmt.Errorf("%s not exist", key)

}))

for k, v := range db {

if view, err := gee.Get(k); err != nil || view.String() != v {

t.Fatal("failed to get value of Tom")

} // load from callback function

if _, err := gee.Get(k); err != nil || loadCounts[k] > 1 {

t.Fatalf("cache %s miss", k)

} // cache hit

}

if view, err := gee.Get("unknown"); err == nil {

t.Fatalf("the value of unknow should be empty, but %s got", view)

}

}

|

- 在这个测试用例中,我们主要测试了 2 种情况

- 1)在缓存为空的情况下,能够通过回调函数获取到源数据。

- 2)在缓存已经存在的情况下,是否直接从缓存中获取,为了实现这一点,使用

loadCounts 统计某个键调用回调函数的次数,如果次数大于1,则表示调用了多次回调函数,没有缓存。

测试结果如下:

1

2

3

4

5

6

7

8

9

10

|

$ go test -run TestGet

2020/02/11 22:07:31 [SlowDB] search key Sam

2020/02/11 22:07:31 [GeeCache] hit

2020/02/11 22:07:31 [SlowDB] search key Tom

2020/02/11 22:07:31 [GeeCache] hit

2020/02/11 22:07:31 [SlowDB] search key Jack

2020/02/11 22:07:31 [GeeCache] hit

2020/02/11 22:07:31 [SlowDB] search key unknown

PASS

ok geecache 0.008s

|

可以很清晰地看到,缓存为空时,调用了回调函数,第二次访问时,则直接从缓存中读取。

HTTP 服务端

- 介绍如何使用 Go 语言标准库

http 搭建 HTTP Server

- 并实现 main 函数启动 HTTP Server 测试 API,代码约60行

http 标准库

Go 语言提供了 http 标准库,可以非常方便地搭建 HTTP 服务端和客户端。比如我们可以实现一个服务端,无论接收到什么请求,都返回字符串 “Hello World!”

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

package main

import (

"log"

"net/http"

)

type server int

func (h *server) ServeHTTP(w http.ResponseWriter, r *http.Request) {

log.Println(r.URL.Path)

w.Write([]byte("Hello World!"))

}

func main() {

var s server

http.ListenAndServe("localhost:9999", &s)

}

|

- 创建任意类型 server,并实现

ServeHTTP 方法。

- 调用

http.ListenAndServe 在 9999 端口启动 http 服务,处理请求的对象为 s server。

接下来我们执行 go run . 启动服务,借助 curl 来测试效果:

1

2

3

4

|

$ curl http://localhost:9999

Hello World!

$ curl http://localhost:9999/abc

Hello World!

|

Go 程序日志输出

1

2

|

2020/02/11 22:56:32 /

2020/02/11 22:56:34 /abc

|

http.ListenAndServe 接收 2 个参数,第一个参数是服务启动的地址,第二个参数是 Handler,任何实现了 ServeHTTP 方法的对象都可以作为 HTTP 的 Handler。

在标准库中,http.Handler 接口的定义如下:

1

2

3

4

5

|

package http

type Handler interface {

ServeHTTP(w ResponseWriter, r *Request)

}

|

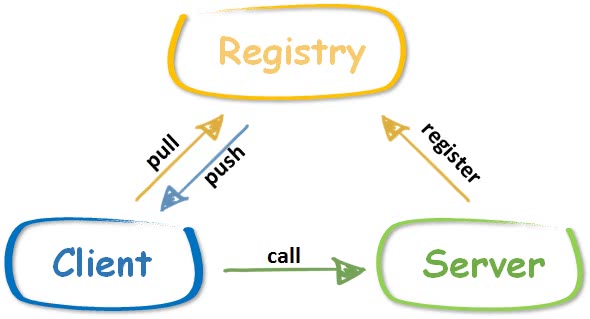

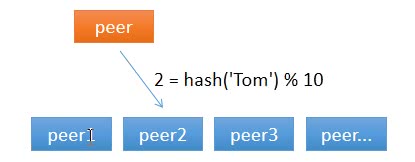

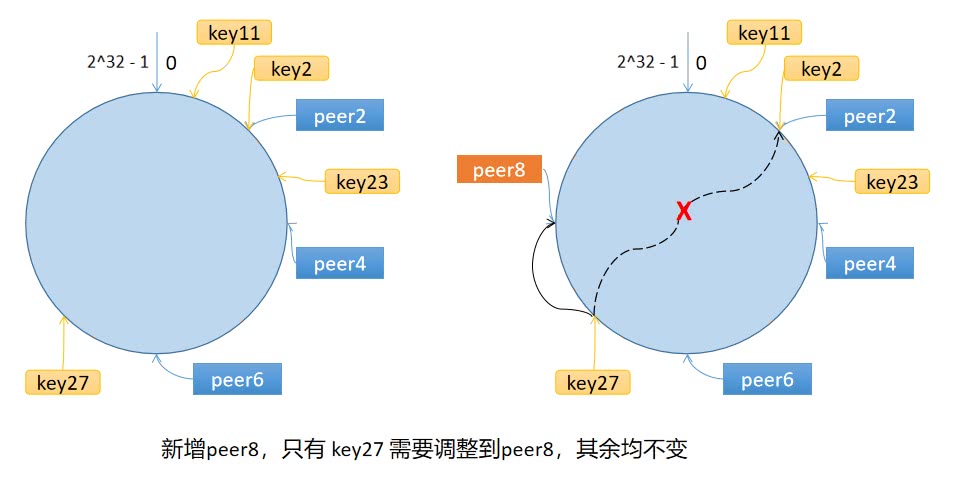

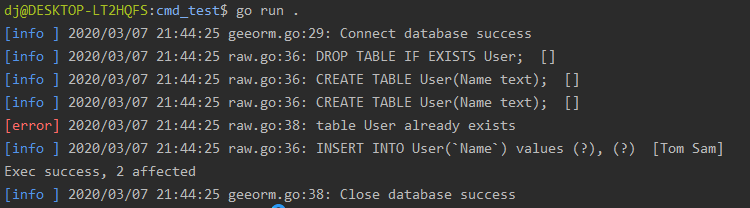

GeeCache HTTP 服务端